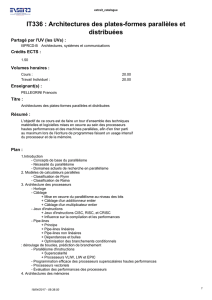

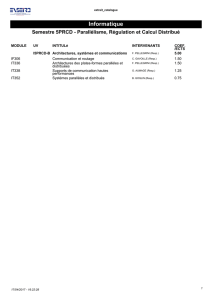

Cours 1 - LOG640 - Introduction au traitement parallèle

Introduction aux

architectures

parallèles

Professeur: Nilo STOLTE

Chargé de Cours: Mohammed ELKANOUNI

Département de génie logiciel et des TI

2

INTRODUCTION AU TRAITEMENT PARALLÈLE

Sommaire

Parallélisme et programmation

Machines Parallèles

Programmation parallèle

Les algorithmes parallèles

3

INTRODUCTION AU TRAITEMENT PARALLÈLE

Besoin de performance

Les applications traditionnelles (calcul intensif):

-Prévision météo

-Simulation scientifique: mécanique, aérodynamique,

électrique, biologique

Nouvelles applications (données intensives):

-Traitement d’image, multimédia, infographie

Les applications futures:

-CAO, RV, etc.

4

INTRODUCTION AU TRAITEMENT PARALLÈLE

Besoin de performance

Puissance de traitement et/ou la disponibilité

Puissance de traitement recouvre 2 notions: la latence de

traitement et le débit de traitement

La latence représente le temps nécessaire pour l’exécution

d’un traitement.

Le débit représente le nombre de traitement exécutable par

unité de temps

Disponibilité: résistance aux pannes, maintien de la

performance

5

INTRODUCTION AU TRAITEMENT PARALLÈLE

Besoin de performance

Modélisation du climat:

-1018 FLOP pour une simulation de 10 ans (10 jours @

1 Tflops)

-Génère 100 GB de données

Graphisme 3D à temps réel:

-Résolution 10242éléments

-10242x 30 fps x 300 ops/el = 9437184000 ops/sec ???

-I/O doit correspondre à cet exigence

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

1

/

38

100%