Le cours en ppt

1

L3 PRO

2

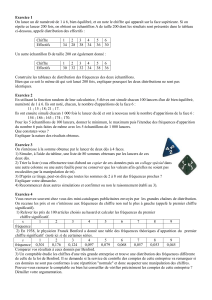

Echantillonnage – Estimation d’un paramètre

Extraction de néchantillons d’une population P

Si l’on extrait plusieurs échantillons représentatifs de taille nfixée, les

différences observées entre les résultats obtenus sont dues à des

fluctuations d’échantillonnage. A partir d’un échantillon, on n’a donc pas

de certitudes mais des estimations de paramètres.

L'estimation d'un paramètre peut être faite

- par un seul nombre: estimation ponctuelle

- par 2 nombres entre lesquels le paramètre peut se trouver: estimation

par intervalle

3

Echantillonnage – Estimation d’un paramètre

Estimation ponctuelle d’une moyenne

1

)(

1

2

2

n

xx

s

n

ii

x

Estimateur sans biais

n

ii

x

n

x1

1

x barre

n

s

sx

x

Ecart type de la moyenne

4

Echantillonnage – Estimation d’un paramètre

Pour améliorer la connaissance de la moyenne, il faut augmenter la taille de

l’échantillon

5

Intervalle de confiance de la moyenne

Cas des grands échantillons (variance connue):

Soit une population obéissant à une loi normale de moyenne met

d’écart type s.

s

m

s

1)Pr( 2/2/ n

Zx

n

Zx

Echantillonnage – Estimation d’un paramètre

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

1

/

76

100%