La Quantification des Signaux - Faculté Polytechnique de Mons

Chapitre 2

La Quantification des Signaux

Notes de Cours.

B. Gosselin

2.1 Introduction

La représentation numérique d’un signal implique la quantification de chaque échantillon selon

un nombre fini de valeurs discrètes. L’objectif visé est, soit une transmission, soit un traitement

déterminé (filtrage, analyse spectrale,…) :

• Dans le premier cas, chaque échantillon du signal est quantifié, codé, puis transmis; à la

réception, il est décodé, puis converti en amplitude continue : après interpolation, on souhaite

retrouver l’image la plus fidèle possible du signal original. La statistique du signal doit donc être

préservée : elle va influencer d’une façon essentielle la procédure de quantification.

• Dans le second cas, la loi de quantification est imposée par le système de traitement ; une

contrainte importante pour un système de traitement numérique consiste à commettre des erreurs

de calcul qui soient négligeables vis-à-vis de l’incertitude sur le signal lui-même ; cet objectif doit

être atteint malgré le caractère non - stationnaire de certains signaux, tel le signal vocal par

exemple.

L’erreur qui résulte de la quantification d’un signal déterministe est aussi déterministe ; ses

propriétés peuvent donc, en principe, être établies par une approche déterministe. En réalité, les

signaux tels que, par exemple, le signal vocal, doivent être considérés comme étant aléatoires : la

suite des erreurs de quantification est par conséquent aussi aléatoire, et l’on parle alors de bruit de

quantification. Il est très important d’en connaître les propriétés statistiques, tout au moins celles

des premier et second ordre, c’est-à-dire :

La Quantification des Signaux

Copyright © 2002 Faculté polytechnique de Mons – B. Gosselin

2

• la densité de probabilité

(

)

epe;

• la moyenne e

µ;

• la variance 2

e

σ;

• la fonction d’autocovariance

(

)

k

ee

φ;

• la covariance mutuelle avec le signal

(

)

k

ex

φ;

• le rapport signal à bruit RSB.

Considérons un signal

(

)

tx à temps continu et à bande limitée

[

]

BB +− ,. Lorsqu’on

l’échantillonne à une fréquence supérieure ou égale à la fréquence de Nyquist Bfe2=, on obtient,

sans perte d’information, un signal à temps discret

(

)

nx . On interprétera ce signal comme un

processus aléatoire à temps discret

(

)

nX . On suppose que ce processus aléatoire possède les

bonnes propriétés habituelles de stationnarité et d’ergodicité. A la sortie du quantificateur, ce

processus devient un processus aléatoire à valeurs discrètes, c’est à dire que

(

)

XQY = prend ses

valeurs dans un ensemble fini de L éléments.

Une loi de quantification sans mémoire, ou instantanée, est définie par :

• (L+1) niveaux de décision : L

xxx

⋯

,, 10 ;

• L valeurs quantifiées : L

yyy

⋯

,, 21 .

A toute amplitude Xcomprise dans l’intervalle

[

]

ii xx ,

1−, on fait correspondre une valeur quantifiée

i

y située dans cet intervalle :

i

yY =si

[

]

ii xxX ,

1−

∈pour Li ,,2,1

⋯

=

(2.1)

Les amplitudes extrêmes du signal sont en principe −∞=

0

x et +∞=

L

x; en fait, le domaine de

variation de x est borné et supposé symétrique par rapport à l’origine. On a donc max0 xx −= et

max

xxL+= .

La valeur quantifiée de sortie peut également être représentée au moyen d’un mot,

généralement au format binaire, choisi parmi les L que contient un dictionnaire. Ainsi, par exemple,

lorsque le nombre de valeurs quantifiées est une puissance de 2, soit b

L

2

=

, chaque valeur

quantifiée peut être représentée par un mot de b bits, en codant les indices de référence de ces

valeurs.

La loi de quantification

(

)

xQ peut affecter deux formes :

• L est pair et 0

=

x est un niveau de décision (midrise characteristic) ;

• L est impair et

0

=

y

est une valeur de sortie (midthread characteristic) ;

La Quantification des Signaux

Copyright © 2002 Faculté polytechnique de Mons – B. Gosselin

3

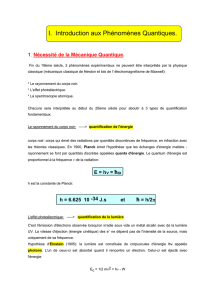

Ces caractéristiques sont représentées à la figure 2.1, qui illustre également l’erreur de quantification

(

)

xxQe −= . La seconde caractéristique, qui assure une valeur quantifiée insensible aux petites

fluctuations éventuelles autour de l’origine, est en général préférée.

La différence entre deux niveaux de quantification successifs est appelée pas de

quantification :

1−

−=∆ iii xx (2.2)

Le pas de quantification est en général fonction de l’amplitude du signal (quantification non

uniforme). Le cas le plus simple est celui de la quantification uniforme.

y

x

x(2)

x(1) x(3)

y(8)

x(7)x(6)x(5)

y(2)

y(3)

y(7)

y(6)

y(1)

e = y - x

x

y

x

x(2)x(1) x(3)

y(9)

x(6)x(5)x(4)

y(2)

y(3)

y(8)

y(7)

y(1)

e = y - x

x

Figure 2.1 - Exemples de lois de quantification.

La statistique du bruit de quantification

(

)

ne est relativement aisée à déterminer lorsque le

signal est aléatoire et de grande amplitude, c’est-à-dire lorsqu’à la fois son écart-type et la différence

entre deux échantillons successifs sont grands vis-à-vis du pas de quantification. Les propriétés qui

correspondent à la quantification d’un bruit blanc continu gaussien de variance finie lorsque le pas de

quantification tend vers zéro sont appelées propriétés asymptotiques. Ces dernières ne sont

toutefois pas valables pour les signaux aléatoires dont l’amplitude est de l’ordre de grandeur du pas

de quantification, et une analyse mathématique précise de la quantification est dans ce cas

indispensable.

La Quantification des Signaux

Copyright © 2002 Faculté polytechnique de Mons – B. Gosselin

4

2.2 Quantification Uniforme

Une loi uniforme et symétrique (figure 2.2) est caractérisée par :

• Les niveaux de saturation s

x±;

• Le nombre de niveaux quantifiés L; on choisi normalement L (ou L+1) = b

2

.

Le pas de quantification

∆

vaut alors : L

xs

2

=∆ , (2.3)

et la valeur quantifiée i

y est choisie au milieu de l’intervalle i:2

1ii

i

xx

y

+

=− (2.4)

x(1)

-xs

xs

x(2)

x(8)

x(3) x(4)

x(5) x(6) x(7)

y(1)

y(4)

y(6)

y(7)

y(8)

y(9)

y(2)

y(3)

y

x

x

e = y - x

∆

/2

-

∆

/2

Figure 2.2 - Loi de Quantification Uniforme.

• Pour 2

∆

⋅

=≤ L

xx s, l’erreur de quantification est comprise entre 2

∆

− et 2

∆

+:

2

∆

≤⇒≤≤− exxx ss (2.5)

On parle dans ce cas d’erreur (ou de bruit) de granulation.

• Lorsque s

xx >, Il y a dépassement ; on parle alors d’erreur (ou de bruit) de saturation ou de

dépassement.

La Quantification des Signaux

Copyright © 2002 Faculté polytechnique de Mons – B. Gosselin

5

Erreur de granulation

Soit un signal x, dont la densité de probabilité

(

)

xpx est Gaussienne, d’écart-type x

σ(figure

2.3). L’aire hachurée définit la probabilité pour que les amplitudes de x contribuent à la valeur

quantifiée k

y, soit :

2

2

∆

+<≤

∆

−kk yxy (2.6)

px

xyk

Figure 2.3 - Quantification d’un signal Gaussien.

La densité de probabilité

(

)

epe de l’erreur de granulation peut être obtenue par la superposition de

telles aires ramenées entre 2

∆

− et 2

∆

+:

(

)

(

)

(

)

∑

∆

⋅+=

k

kxe erecteypep 2/ (2.7)

où la fonction

(

)

erect 2/∆ est définie par :

(

)

ailleurs

rect

,0

,1

=

α<τ≤α−=τ

α (2.8)

On conçoit aisément que lorsque le rapport

∆

σ

x tend vers l’infini, la loi (2.7) tende vers une

répartition de moyenne nulle, et uniforme entre 2

∆

− et 2

∆

+ (

∆

σ

x> 3 ou 4 est considéré comme

suffisant en pratique). Si la probabilité de dépassement est négligeable, on a donc :

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

1

/

31

100%