interprétation statistique de l`entropie troisième principe de la

Q Interprétation statistique de l’entropie (34-109) Page 1 sur 3 JN Beury

A

B

B

B

B

A

A

A

INTERPRÉTATION STATISTIQUE DE L’ENTROPIE

TROISIÈME PRINCIPE DE LA THERMODYNAMIQUE

I. INTERPRÉTATION STATISTIQUE DE L’ENTROPIE

I.1 Position du problème

a) Modèle de système thermodynamique

On considère le système

(

)

Σ

thermodynamique suivant : N molécules Mi identiques qui peuvent être soit dans l’état

(+) ou dans l’état (–).

{Mi : (+) ou (–) ; 1iN≤≤ }définit le système à l’échelle microscopique. Cette donnée est un microétat du système

()

Σ, c'est-à-dire que l’on connaît l’état de chaque molécule qui constitue le système thermodynamique.

À l’échelle macroscopique, un observateur ne peut pas distinguer les différentes molécules dans l’état (+) ;

uniquement le nombre total N+ de molécules dans l’état (+) est accessible (par exemple une mesure de la pression

dans les deux compartiments). On en déduit NNN

−

+

=−

N+

caractérise un macroétat de

(

)

Σ : N+ est donc un paramètre d’état du système.

b) Cas particuliers

Si N+ = 0, il existe un seul microétat accessible au système et il est parfaitement connu. Les différentes molécules

sont dans l’état (–) : il n’existe aucune information manquante sur le système.

Si 2

N

N+=, il existe un grand nombre de microétats possibles. On sait que la moitié des molécules est dans l’état

(+) et l’autre moitié dans l’état (–). On ne connaît pas l’état d’une molécule donnée : il existe de l’information

manquante sur le système.

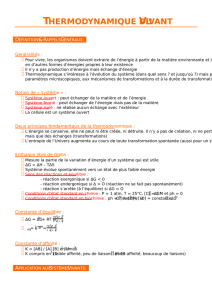

c) Exemple de système à 2 molécules

On considère un système constitué de 2 molécules. Il y a 4 microétats possibles (2 façons possibles de placer chaque

particule, soit 2N microétats dans le cas général).

Les 4 microétats sont représentés ci-dessous :

Macroétat N+ = 0 Macroétat N+= 1 Macroétat N+= 2

Macroétat N+= 0 : pas d’information manquante sur le système

Macroétat N+= 1 : information manquante sur le système car on ne sait pas si A ou B est dans le compartiment de

droite (état +).

Macroétat N+= 2 : pas d’information manquante sur le système

I.2 Entropie statistique

a) Formule de Shannon

On considère un macroétat quelconque ne correspondant pas nécessairement à un état d’équilibre thermodynamique

()

Σ.

Pour ce macroétat donné, il y a plusieurs microétats accessibles. Pour chaque microétat accessible, on appelle pi la

probabilité d’occupation de ce microétat.

Q Interprétation statistique de l’entropie (34-109) Page 2 sur 3 JN Beury

AB B B BAAA

microétat n°1 microétat n°2 microétat n°3 microétat n°4

On définit S l’entropie statistique du système :

microétats

accessibles

ln

B

ii

Sk pp=−

∑

Cette formule est issue de la théorie de l’information développée par Shannon en 1948.

kB est la constante de Boltzmann = 1,38×10-23 J.K-1.

La valeur de cette constante est choisie pour que l’entropie ainsi définie coïncide avec l’entropie définie

précédemment en thermodynamique.

b) Exemple d’un système constitué de deux molécules

N+ = 0 : p1 = 1 ; p2 = p3 = p4 = 0. On a donc S = 0. L’entropie est nulle lorsqu’il n’existe aucune information

manquante sur le système.

S > 0 si 0N+≠ et NN

+≠.

On admet que l’entropie est une mesure de l’information manquante sur le système. On dit aussi qu’elle

mesure le désordre.

c) Entropie molaire des corps purs

Soit un corps pur donné. Pour une pression donnée, on constate que

corps pur gaz corps pur liquide corps pur solidemm m

SS S>

Cela signifie que l’on ignore moins de choses sur l’état microscopique solide que sur l’état microscopique gazeux.

On a une structure ordonnée à grande distance dans les solides : réseaux cristallins et absence d’une telle structure

dans les gaz.

I.3 Formule de Boltzmann

L’expression de l’entropie statistique permet de donner une signification à l’entropie, même lorsque le système est hors

équilibre. On va caractériser l’équilibre pour un système et avoir une expression plus simple de l’entropie.

a) Système isolé avec deux microétats accessibles

On appelle p1 et p2 la probabilité d’occupation du microétat 1 et du microétat 2. On a 12

1pp+=

On a vu dans le cours sur le deuxième principe que l’entropie est maximale à l’équilibre.

[

]

(

)

(

)

112 2 11 1 1

ln ln ln 1 ln 1

BB

Skpppp kpp p p

=− + =− + − −

() ( )

11 12

1

d1ln 1ln1 ln ln 0

dBB

Skp pkpp

p

=− + − − − =− − =

pour p1 = p2 = 1

2.

L’entropie est maximale pour p1 = p2 = 1

2.

b) Généralisation d’un système isolé à l’équilibre

Pour un système isolé à l’équilibre, tous les microétats sont équiprobables : c’est l’hypothèse

microcanonique.

c) Formule de Boltzmann

On considère un macroétat donné.

On appelle Ω le nombre de microétats accessibles pour ce macroétat donné.

On a vu que toutes les probabilités d’occupation des microétats sont identiques :

12

...pp p

Ω

===. On la note p.

La somme des probabilités vaut 1. On a donc : 12

... 1pp p p

Ω

+

++ ==Ω, donc 1

p

=

Ω

L’entropie statistique s’écrit :

microétats 1 1

accessibles

ln ln ln ln

BkkBiiB B

ii

Sk pp k pp k ppkpp

ΩΩ

==

=− =− =− =− Ω

∑∑∑ . Or 1

p

=

Ω

.

On a donc 11

ln ln ln

BB B

Skppk k=− Ω =− Ω = Ω

ΩΩ

Formule de Boltzmann pour un système isolé à l’équilibre : ln

B

Sk

=

Ω.

Q Interprétation statistique de l’entropie (34-109) Page 3 sur 3 JN Beury

En 1877, Boltzmann proposa une première interprétation statistique de l’entropie. Sur la tombe de Boltzmann à

Vienne, on peut lire la formule précédente…

Si 1Ω= , S = 0 : il n’y a pas d’information manquante sur le système.

Si Ω augmente, l’entropie augmente. L’entropie mesure le désordre moléculaire.

d) Extensivité de l’entropie

Soient deux systèmes disjoints

(

)

'Σ et

()

"Σ.

On a alors '"Ω=ΩΩ et ln ln ' " ln ' ln " ' "

BB BB

Sk k k k SS= Ω= ΩΩ= Ω+ Ω= +

On établit l’extensivité de l’entropie.

I.4 Interprétation statistique de la détente de Joule Gay-Lussac

On considère le modèle simplifié d’un système isolé constitué de N molécules pouvant être dans l’état

(+) ou dans l’état (–).

Etat initial : Les n moles de gaz sont située à gauche dans l’état (–) de volume V.

Etat final : Les n moles de gaz occupent le volume 2V.

On suppose que ces deux états ont la même énergie. L’énergie est indépendante de la répartition des molécules entre les

deux compartiments : elle est donc conservée au cours de la détente. Le modèle adopté est en accord avec la

conservation de l’énergie interne obtenue avec une approche microscopique.

• État initial : N+ = 0 . On a 1

I

Ω= et 0

I

S=.

• État final : 2

N

N+=. On cherche à calculer

F

Ω

le nombre de microétats accessibles. Il est égal au nombre de

manières de choisir N+ molécules parmi N sans tenir compte de l’ordre.

On peut montrer que

()( )

(

)

()

12... 1 !!

!!!

!!

22

N

FN

NN N N N NN

CNN

NNNN

+

+

+++

−− −+

Ω= = = =

−

ln ! 2ln !

2

FB

N

Sk N

=−

. On étudie un système à grand nombre de particules.

On peut faire un développement limité à l’infini : formule de Stirling : ln ! ln si qqqq q

≈

−→∞.

On a alors ln

FB

SkNNN=−2−2

Nln 2

NN+ln 2 ln 2 ln 2

BBA

kN knN nR

== =

Interprétation : on retrouve le même résultat qu’avant. Le choix de la constante de Boltzmann comme constante

multiplicative était donc pertinent.

Attention, c’est un hasard qu’on retrouve le même résultat car on a un modèle très simple.

Les calculs précédents peuvent être utilisés pour décrire des systèmes à deux niveaux (exemple spin +1/2 ou –1/2).

II. TROISIÈME PRINCIPE DE LA THERMODYNAMIQUE

On a vu dans le cours de thermodynamique que l’énergie interne et l’enthalpie sont définies à une constante additive près.

Le deuxième principe de la thermodynamique donne accès expérimentalement aux variations d’entropie mais pas à

l’entropie d’un état donné.

Nernst a énoncé à la fin du 19ème siècle (un siècle avant la thermodynamique statistique) le troisième principe de la

thermodynamique :

L’entropie d’un corps pur tend vers 0 lorsque la température thermodynamique T tend vers 0 K.

L’entropie est donc absolue : il n’existe pas de constante additive arbitraire.

1

/

3

100%