Validation probabiliste d`un Syst`eme de Prévision d`Ensemble

Crit`eres Mesures Comparaison Conclusions

Principes probabilistes de validation d’un EPS

”Oublier” les concepts de validation d´eterministe

•1 pr´evision = distribution

de probabilit´es (PDF)

vs.

1 v´erification = 1 valeur

num´erique

Xo

Validation des EPS par accumulation statistique.

2 crit`eres : la fiabilit´e et la r´esolution.

Crit`eres Mesures Comparaison Conclusions

Crit`ere d’´evaluation : Fiabilit´e

•Coh´erence statistique entre les pr´evisions et les observations

correspondantes.

Xo

fest la PDF pr´evue.

f0

1et f0

2sont 2 distributions

de xoquand fest pr´evue.

L’EPS est parfaitement

fiable si et seulement si

f=f0.

tout syst`eme peut ˆetre rendu

fiable par une calibration

statistique a posteriori.

•La fiabilit´e est un crit`ere n´ecessaire mais non suffisant :

cf. e.g. un syst`eme climatologique.

Crit`eres Mesures Comparaison Conclusions

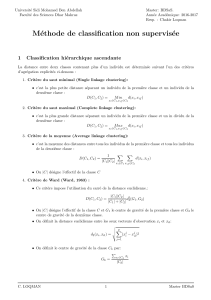

Crit`ere d’´evaluation : R´esolution

•Capacit´e de s´eparer les pr´evisions menant `a des distributions

d’observations correspondantes (DOC) bien distinctes.

système climatologique

X1X2

système déterministe

•Exemples DOC

allant d’une

r´esolution minimale

nulle pour le syst`eme

climatologique `a une

r´esolution maximale

pour le syst`eme

d´eterministe.

(la courbe rouge repr´esente ici la distribution de toutes les observations :

distribution climatologique)

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%