Exposé "le Tal"

1

TAL

TRAITEMENT

AUTOMATIQUE DU

LANGAGE.

2

Table des matières

1. DEFINITION

2. FONCTIONNEMENT D’UN SYSTEME DE T.A.L.

2.1. Analyse morpho-lexicale

2.2. Analyse syntaxique

2.3. Analyse sémantique

2.4. Analyse pragmatique

3. BASES DE CONNAISSANCES

4. OUTILS T.A.L.

5. CONCLUSION

6. BIBLIOGRAPHIE

3

1. DEFINITION

Certains parlent de traitement du langage naturel (T.L.N.), d’autres de

traitement automatique du langage naturel (T.A.L.N.) pour désigner

l’ensemble des techniques qui permettent le traitement automatique ou

quasi-automatique de l'information textuelle à l'aide de moyens

informatiques.

Nous avons choisi d’utiliser le terme de traitement automatique du

langage (T.A.L.) car l’information textuelle est généralement exprimée

dans le langage courant qui est par définition naturel.

Les premières recherches concernant le T.A.L. visaient à créer un modèle

unique, capable de formaliser la compréhension du langage dans sa

globalité. Cette approche, initiée par Chomsky, s’est vite avérée difficile à

mettre en œuvre.

A l’heure actuelle, les systèmes de T.A.L. utilisent une approche à base de

corpus, certes moins ambitieuse mais beaucoup plus pragmatique. Celle-ci

consiste à utiliser un corpus de documents représentatifs du domaine à

modéliser que le système va utiliser pour obtenir une couverture du

langage suffisante pour que le système de T.A.L. donne des résultats de

bonnes qualités.

4

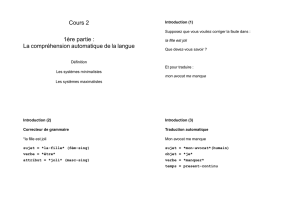

2. FONCTIONNEMENT D’UN SYSTEME DE T.A.L.

Pour pouvoir présenter d’une manière claire les techniques de T.A.L., nous

allons adopter une vision très théorique qui décompose l’analyse d’un

texte en quatre étapes successives d’analyse :

L’analyse morpho lexicale, qui se préoccupe de la structure des mots ;

L’analyse syntaxique, dédiée à l’analyse de la structure des phrases ;

L’analyse sémantique, qui s’intéresse au sens des phrases considérées

individuellement ;

L’analyse pragmatique, qui s’attache à remettre un contexte autour des

phrases.

(cf schéma page 5)

Dans la pratique, un texte n’est pas soumis à l’analyse successive de

différents modules, chacun traitant une caractéristique spécifique du

langage. Ces différents niveaux d’analyse interagissent dynamiquement

au cours du traitement d’un document écrit. Cette distinction entre les

caractéristiques du langage n’a donc qu’un intérêt pédagogique.

De plus, certains outils se consacrent à l’analyse de la structure des

phrases alors que d’autres tentent de comprendre les textes à partir du

sens des mots. De tels systèmes, basés sur l’analyse sémantique,

s’intéressent à la signification des mots plutôt qu’à leur rôle syntaxique.

5

Analyse morpho

lexicale.

Analyse

syntaxique.

Analyse

sémantique.

Analyse

pragmatique.

Base de

connaissances

Contexte

sens

Le

Roi

Est

Mort

SENS

6

6

7

7

8

8

9

9

10

10

1

/

10

100%