Probabilités 7. Variance, moments et espaces Lp

Probabilit´es

7. Variance, moments et espaces Lp

Denis Villemonais

IECL – ´

Ecole des Mines de Nancy

30 mai 2016

1 / 26

1. Variance et covariance

D´efinition/proposition

Soient X,Ytelles que E(X2)<∞et E(Y2)<∞.

La variance de Xest bien d´efinie, donn´ee par

Var(X) = E(X2)−E(X)2

=E(X−E(X))2≥0.

La covariance de Xet Yest bien d´efinie, donn´ee par

Cov(X,Y) = E(XY )−E(X)E(Y)

=E[(X−E(X))(Y−E(Y))]

La fonction Cov est bilin´eaire sym´etrique.

X,Yind´ependants ⇒Cov(X,Y)=0.

2 / 26

Exemple 1. Soit Xde loi 1

λe−x/λ1x>0λ1(dx )et Y=X+ 1.

1. Calculer la variance de X.

2. Calculer la covariance de Xet Y.

Solution.

1. Nous avons E(X2) = RRx21

λe−x/λ1x>0/ λ1(dx )=2λ2,donc

Var(X)est bien d´efinie. De plus, E(X) = λ, donc

Var(X) =E(X2)−E(X)2=λ2.

2. Y2=X2+ 2X+ 1, avec X≥0presque sˆurement, donc

E(Y2) = E(X2)+2E(X) + 1 = 2λ2+ 2λ+ 1 <∞.

De plus,

E(Y) = E(X+ 1) = E(X) + 1 = λ+ 1,

E(XY ) = E(X(X+ 1)) = E(X2) + E(X)=2λ2+λ.

En d´efinitive,

Cov(X,Y) = E(XY )−E(X)E(Y)=2λ2+λ−λ2−λ=λ2.

3 / 26

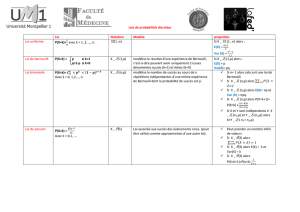

Les espaces Lp,1≤p≤ ∞

Soit (Ω,F,P)un espace de probabilit´e.

Definition/Propri´et´e

Soit p∈[1,+∞[. On appelle espace Lpl’ensemble des variables

al´eatoires `a valeurs r´eelles Xtelles que

kXkp:= ZΩ|X(ω)|pP(dω)1

p

= (E(|X|p))

1

p<∞.

L’ensemble Lpest un espace vectoriel et l’application X7→ kXkp

est une norme sur Lp, en particulier

kX+Ykp≤ kXkp+kYkp,∀X,Y∈Lp.

→On pourrait consid´erer des variables al´eatoires dans Rden

rempla¸cant |·|par la norme euclidienne.

4 / 26

Definition/Propri´et´e

On appelle espace L∞l’ensemble des variables al´eatoires `a valeurs

r´eelles Xborn´ees par une constante, c’est-`a-dire telles que

∃c≥0tel que P(|X| ≤ c)=1.

L’ensemble L∞est un espace vectoriel muni de la norme

kXk∞= inf{c≥0,t.q. P(|X| ≤ c)=1}

= min{c≥0,t.q. P(|X| ≤ c)=1}

→La formulation suivante est ´equivalente

kXk∞= max{A≥0,t.q. P(|X|>A)>0}.

→On utilise parfois la notation kXkp, mˆeme si X/∈Lp. Dans ce

cas, on a kXkp:= +∞.

5 / 26

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

1

/

26

100%