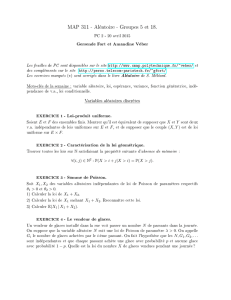

(un exemple simple : lancer de des).

Lp

i= 1,2Xii

Xi

X1X1+X2

{1,···, n}λ > 0

(Xi)i≥1m σ2

¯

Xn=1

n

n

X

i=1

Xi

S2

n=1

n−1

n

X

i=1

(Xi−¯

Xn)2

X, Y, Z

[0,1]

X=x∈[0,1] Y fY|X=x

fY|X=x(y) = (y−x)e−(y−x)1y>x,

X=x∈[0,1] Y=y > x Z fZ|X=x,Y =y

fZ|X=x,Y =y(z) = (y−x)e−z(y−x)1z>0.

(X, Y, Z)

Z

(X, Y )Z=z

U=Y−X V =Z(Y−X) (X, U, V )X, U

V

1n p p ≤n Ap

p

App n

p1,···, pkn Ap1,···, Apk

φ

φ(n)n n

φ(n) = nY

pdiviseur premier de n

(1 −1

p).

µRF:R→[0,1]

F F −1u∈]0,1[

F−1(u) = inf{x∈Rtel que F(x)≥u}.

F u ∈]0,1[

Du={x∈R|F(x)≥u}

F−1(u)

Du= [F−1(u),+∞[.

x∈Ru∈]0,1[ u≤F(x)F−1(u)≤x

U[0,1] F−1(U)µ

{1,···, n}

U, V [0,1]

X=√−2 log Ucos(2πV )Y=√−2 log Usin(2πV )

(Ui)i≥0[0,1] λ > 0

N= min{n≥0|U0.···.Un≤exp(−λ)}

N

n≥0Vn=−ln(Un)n≥1Sn=Pn−1

k=0 Vn

P(N= 0) P(N= 1)

n≥1{N=n}={Sn< λ et Sn+1 ≥λ}

Sn

fn(x) = xn−1

(n−1)!e−x1x≥0.

(Ω,F,P)X∈L1(Ω,F,P)G F

E(X|G)

E(E(X|G)) = E(X)

XGE(X|G) = X

E(a1X1+a2X2|G) = a1E(X1|G) + a2E(X2|G)

X≥0E(X|G)≥0

σ(X)GE(X|G) = E(X)

X

(Ω,F,P)G F

(X|G) = E[(X−E[X|G])2|G].

(X) = E[ (X|G)] + (E[X|G]).

L2

X Y (Ω,F,P)

Y X xi, i ≥1

Y X =xE(Y|X)

(Xi)i≥1µ σ2

NN∗Xim s2

SN=

N

X

i=1

Xi.

SNN=n Sn

E[SN|N]E[SN]

(SN)

X m σ2(Xm

r)m,r∈N

X

ZnZ0= 1

Zn+1 =X(n+1)

1+. . . +X(n+1)

Zn.

E(Zn+1)E(Zn)E(Zn)

n

Znn

Sn

n S0= 1

Sn+1 Sn=k

E(Sn+1|Sn)E(Sn)

Sn

Wn=Sn(Sn+1)

(n+2)(n+3) E(Wn+1|Wn) = Wn

TN

m∈NT T −m T ≥m

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

1

/

16

100%