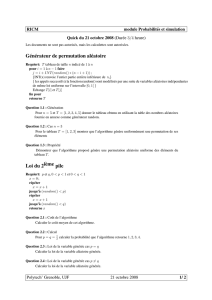

Signaux Aléatoires : Cours sur les Processus et Filtrage

Telechargé par

Anouer Ghrairi

SIGNAUX AL´

EATOIRES

Hichem Naamen

5 mai 2022

Table des mati`eres

1 Rappels 1

1.1 Signaux temporels discrets .......................................... 1

1.2 Syst`emes temporels discrets ......................................... 2

1.2.1 Lin´earit´e et invariance temporelle .................................. 2

1.2.2 Causalit´e ............................................... 3

1.2.3 Stabilit´e ................................................ 3

1.2.4 Inversibilit´e .............................................. 4

1.3 Description dans le domaine temporel des filtres LSI ........................... 4

1.4 Transform´e de Fourier discr`ete temporelle ................................. 5

1.5 Transform´e en z ................................................ 7

1.6 Classes sp´eciales de filtres .......................................... 8

1.7 Organigramme des filtres .......................................... 9

1.8 DFT et FFT ................................................. 10

1.9 Combinaison des syst`emes LTI ....................................... 11

1.9.1 Couplage s´erie : ............................................ 11

1.9.2 Couplage parall`ele : ......................................... 12

1.9.3 Feedback : ............................................... 12

2 Processus al´eatoires `a temps discret 14

2.1 Variables al´eatoires .............................................. 14

2.1.1 d´efinitions ............................................... 14

2.2 Moments statistiques ............................................. 18

2.2.1 D´efinitions de quelques estimateurs statistiques .......................... 18

2.2.2 Remarques .............................................. 19

2.3 Descripteurs .................................................. 19

2.3.1 Descripteurs du premier ordre .................................... 19

2.3.2 Descripteurs du second ordre .................................... 19

2.3.3 Auto/Inter–Corr´elation ....................................... 20

2.4 Appendice ................................................... 21

2.4.1 R´esum´e ................................................ 21

2.4.2 Variance ................................................ 22

2.4.3 Covariance .............................................. 22

2.4.4 Corr´elation .............................................. 22

2.5 Moments temporels .............................................. 23

2.5.1 Moment temporel d’ordre 1 (moyenne) ............................... 23

2.5.2 Moment temporel d’ordre 2 (fonction d’auto–corr´elation temporelle) .............. 23

2.6 Interpr´etation de la Covariance et des fonctions de Corr´elation ..................... 23

2.6.1 Interpr´etation de la Covariance ................................... 23

2.6.2 Interpr´etation des fonctions de Corr´elation ............................ 24

2.7 Notions de probabilit´es ............................................ 25

2.7.1 Fonction de r´epartition et densit´e de probabilit´es ......................... 25

2.7.2 Mod`eles statistiques ......................................... 25

2.8 D´efinitions ................................................... 26

2.9 Signaux Stationnaires Ergodiques ...................................... 26

i

TABLE DES MATI `

ERES ii

2.9.1 Signaux Stationnaires ........................................ 27

2.9.2 Signaux Ergodiques ......................................... 27

2.10 Exemple d’un signal al´eatoire : le bruit blanc ............................... 31

2.10.1 D´efinition : .............................................. 31

2.10.2 Comportement temporel : ...................................... 31

2.10.3 Comportement fr´equentiel : ..................................... 32

2.11 Densit´e spectrale de puissance ........................................ 32

3 Mod`eles param´etriques des signaux et des syst`emes 35

3.1 Les mod`eles autoregressifs AR ....................................... 35

3.2 Les mod`eles `a moyenne ajust´ee MA .................................... 38

3.3 Les mod`eles autoregressif `a moyenne ajust´ee ARMA ........................... 38

4 La matrice de Corr´elation 41

4.1 Propri´et´e 1 : La matrice Rest positive semi-d´efinie ............................ 41

4.2 Propri´et´e 2 : La matrice Rest hermitienne ................................ 41

4.3 Propri´et´e 3 : La matrice Rest Toeplitz .................................. 42

4.4 Propri´et´e 4 : Les valeurs propres de Rmsont λm

i, pour i=0,1,2...,N. ................... 42

4.5 Propri´et´e 5 : .................................................. 42

4.6 Propri´et´e 6 : Les vecteurs propres non nuls q0q1... qNcorrespondant aux valeurs propres sont

lin´eairement ind´ependants .......................................... 43

4.7 Propri´et´e 7 : Puisque la matrice de corr´elation Rest hermitienne, ses valeurs propres sont r´eelles.

Ses valeurs propres sont sup´erieures ou ´egales `a z´ero vu que la matrice Rest semi-d´efini positive . . 43

4.8 Propri´et´e 8 : Si Rest une matrice hermitienne ayant diff´erentes valeurs propres, les vecteurs propres

sont orthogonaux les uns aux autres. En cons´equence, il existe une matrice Qunitaire avec QHQ I 44

4.9 Propri´et´e 9 : La somme des valeurs propres de Rest ´egale `a la trace de R, et le produit des valeurs

propres de Rest ´egal au d´eterminant de R6................................ 45

4.10 Propri´et´e 10 : Le quotient de Rayleigh est d´efini par : RwHRw

wHwd’une matrice hermitienne et est

born´e par les valeurs propres minimale et maximale : λmin R λmax. O`u les valeur minimale et

maximale sont atteintes quand le vecteur west choisi pour ˆetre le vecteur propre correspondant aux

valeurs propres minimale et maximale, respectivement .......................... 45

5 Filtrage de Wiener 47

5.1 R´egression lin´eaire .............................................. 47

5.1.1 Mesure, mod`ele et ´ecart ....................................... 47

5.1.2 Minimisation de l’´ecart quadratique ................................ 47

5.1.3 ´

Equations de la r´egression lin´eaire ................................. 49

5.2 Filtrage de Wiener .............................................. 50

5.2.1 D´efinition du probl`eme ........................................ 50

5.2.2 R´esolution au sens des moindres carr´es ............................... 51

5.2.3 Description matricielle ........................................ 52

5.2.4 Applications du filtrage de Wiener ................................. 53

5.3 Suppression d’une perturbation ....................................... 53

5.3.1 Filtrage de Wiener classique ..................................... 54

5.3.2 Remarque ............................................... 54

6 Filtrage adaptatif 56

6.1 Pourquoi du filtrage adaptatif ? ....................................... 56

6.1.1 Quelques exemples : soustraction de bruit, ´egalisation et identification. ............. 56

6.1.1.1 Soustraction de bruit. ................................... 56

6.1.1.2 Egalisation. ......................................... 56

6.1.1.3 Identification. ....................................... 57

6.2 Filtrage adaptatif ............................................... 57

6.2.1 Algorithme r´ecursif des moindres carr´es (RLMS) ......................... 58

6.2.2 Gain d’adaptation normalis´e .................................... 60

TABLE DES MATI `

ERES iii

7 Filtrage de Kalman 61

7.1 Introduction .................................................. 61

7.1.1 ´

Equation du processus ........................................ 62

7.1.2 ´

Equation de mesure ......................................... 62

7.2 Estimations optimales ............................................ 62

7.3 Notations adopt´ees .............................................. 63

7.4 Filtre de Kalman ............................................... 65

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

1

/

77

100%