See discussions, stats, and author profiles for this publication at: https://www.researchgate.net/publication/285745781

Validation interne des méthodes d'analyse

Article · January 2001

CITATIONS

38

READS

7,567

1 author:

Some of the authors of this publication are also working on these related projects:

Method validation & Uncertainty View project

Max H. Feinberg

45 PUBLICATIONS314 CITATIONS

SEE PROFILE

All content following this page was uploaded by Max H. Feinberg on 12 June 2018.

The user has requested enhancement of the downloaded file.

Toute reproduction sans autorisation du Centre français d’exploitation du droit de copie est strictement interdite.

© Techniques de l’Ingénieur, traité Analyse et Caractérisation P 224 − 1

Validation interne des méthodes

d’analyse

par

Max FEINBERG

Docteur ès sciences

Directeur de recherche à l’Institut national de la recherche

agronomique (INRA) – Laboratoire de chimie analytique

Professeur à l’Institut national agronomique Paris-Grignon (INAPG)

vec la mise en place des systèmes d’assurance qualité dans les laboratoires,

la validation des méthodes d’analyse est aujourd’hui un objectif important.

Elle est souvent perçue comme une contrainte car elle fait appel à des démarches

statistiques mal maîtrisées par les analystes. Il faut regretter cette attitude car, le

laboratoire a tout à gagner en utilisant des méthodes qui fournissent des résul-

tats dans lesquels leurs « clients » peuvent avoir confiance. C’est une consé-

quence du passage de méthodes d’analyse qualitatives à des méthodes

quantitatives. Ainsi, trop souvent on associe l’achat d’un nouvel appareil plus

« performant » à un progrès, sans se soucier si cette performance est réelle au

niveau du rendu du résultat.

C’est pourquoi, il existe encore de nombreuses zones d’ombre dans la défini-

tion, et en conséquence l’évaluation, des critères de performance des méthodes.

1. Qualité des méthodes d’analyse.......................................................... P 224 – 3

1.1 Logique de l’assurance qualité................................................................... — 3

1.2 Organisation de la traçabilité des mesures............................................... — 3

2. Principes de validation d’une méthode............................................. — 5

2.1 Objectifs et moyens..................................................................................... — 5

2.2 Cycle de vie d’une méthode d’analyse ...................................................... — 5

2.3 Critères de validation .................................................................................. — 6

3. Méthodes statistiques de validation .................................................. — 7

3.1 Caractéristiques d’étalonnage.................................................................... — 7

3.2 Limites de détection et de quantification .................................................. — 8

3.3 Recherche des limites du domaine de linéarité........................................ — 9

3.4 Contrôle de la qualité d’un étalonnage...................................................... — 10

3.5 Incertitude, fidélité et justesse.................................................................... — 11

3.6 Capacité de mesure..................................................................................... — 15

3.7 Justesse d’une méthode............................................................................. — 15

3.8 Spécificité..................................................................................................... — 17

3.9 Robustesse................................................................................................... — 18

3.10 Cartes de contrôle........................................................................................ — 19

4. Procédures formalisées de validation des méthodes.................... — 20

4.1 Guides pour l’industrie pharmaceutique................................................... — 20

4.2 Normes......................................................................................................... — 20

5. Informatisation des calculs................................................................... — 21

6. Conclusion ................................................................................................. — 23

Pour en savoir plus........................................................................................... Doc. P 224

A

VALIDATION INTERNE DES MÉTHODES D’ANALYSE ___________________________________________________________________________________________

Toute reproduction sans autorisation du Centre français d’exploitation du droit de copie est strictement interdite.

P 224 − 2© Techniques de l’Ingénieur, traité Analyse et Caractérisation

Le meilleur exemple est celui de la limite de détection qui est abondamment

employé (en particulier par les constructeurs d’appareils) alors qu’il existe plu-

sieurs dizaines de mode de calcul qui conduisent tous sur des valeurs diffé-

rentes. Ces critères soulèvent aussi des problèmes statistiques complexes qui

n’ont pas toujours reçu de solutions satisfaisantes. C’est aux analystes qu’il

incombe de poser correctement ces questions afin d’obtenir des réponses clai-

res. C’est pourquoi, nous pensons que la normalisation des modes de calcul des

critères de validation des méthodes représente une approche qui, à l’heure

actuelle, permettra de mieux poser ces problèmes.

Principales notations

Symbole Définition

a

0blanc-ordonnée à l’origine de la droite de régression

a

1sensibilité-pente de la droite de régression

b

0ordonnée à l’origine de la droite d’ajouts

b

1pente de la droite d’ajouts

C

e

concentration corrigée d’échantillon

CV

coefficient de variation

d

i

différence des moyennes entre une méthode

alternative et une méthode de référence

e

bruit de fond, résidu

p

nombre de solutions étalons

r

coefficient de corrélation

r

limite de répétabilité ou répétabilité

r

teneur retrouvée

R

limite de reproductibilité ou reproductibilité

s

e

écart-type résiduel

estimateur de la variance résiduelle

écart-type de

a

0

écart-type de

a

1

variance du blanc

a

0

variance de la sensibilité

a

1

SCE

Somme des Carrés des Écarts à la moyenne

SCE

x

=

s

e

2

s

a

0

s

a

1

s

a

0

2

s

a

1

2

x

i

x

–()

2

i

∑

SPE

Somme des Produits des Écarts aux moyennes

SPE

xy

=

v

teneur ajoutée

w

teneur après ajout

x

concentration de la solution

x

teneur avant ajout

moyenne des

x

i

y

réponse instrumentale mesurée

moyenne sur les

i

et

j

de

y

ij

moyenne des valeurs

y

ij

sur les répétitions

j

valeur théorique de la réponse

ε

ij

erreur expérimentale

θ

1valeur vraie de

a

1

θ

2valeur vraie de

a

0

Liste des indices

0 ordonnée à l’origine LD limite de détection

1 pente NC niveau critique

Hor Horwitz bl blanc

Lim limite LQ limite de

quantification

Principales notations

Symbole Définition

x

i

x

–()

y

i

y

–()

i

∑

x

y

y

i

y

i

ˆ

__________________________________________________________________________________________ VALIDATION INTERNE DES MÉTHODES D’ANALYSE

Toute reproduction sans autorisation du Centre français d’exploitation du droit de copie est strictement interdite.

© Techniques de l’Ingénieur, traité Analyse et Caractérisation P 224 − 3

1. Qualité des méthodes

d’analyse

Le lecteur pourra se reporter aux articles suivants :

—

Qualité et assurance qualité en chimie analytique

[P 280] ;

—

Matériaux de référence

[P 240].

1.1 Logique de l’assurance qualité

La qualité d’une analyse n’existe pas dans l’absolu mais se définit

à partir des besoins explicites ou implicites des utilisateurs ou des

clients du laboratoire. Elle s’exprime donc à plusieurs niveaux.

■La qualité métrologique. Un besoin évident est que le résultat

soit juste et qu’il reflète exactement le contenu de l’échantillon. À

travers cette exigence de justesse, il apparaît qu’il faut mettre en

place des systèmes de contrôle assurés par des structures indépen-

dantes du laboratoire.

■La qualité technique ou de capacité de mesure. Les analyses sont

faites pour prendre des décisions, il faut donc que la fidélité de la

méthode soit adaptée au type d’échantillon à contrôler.

■La qualité commerciale. C’est une exigence de rapidité dans la

fourniture du résultat et une recherche de prestations au coût le plus

faible possible.

■La qualité d’usage social. Ce dernier besoin s’est exprimé à la

suite de considérations d’hygiène et de sécurité. Ainsi, on peut exi-

ger l’innocuité d’une technique vis-à-vis de l’utilisateur ou de l’envi-

ronnement.

Pour être sûr d’atteindre ces objectifs, une logique commune a

servi à élaborer les différents modèles et référentiels d’assurance de

la qualité. En effet, leur but final est de mettre en place et de faire

fonctionner un système qui garantisse au client les différents

niveaux de qualité du résultat d’analyse. Il faut donc que les diffé-

rentes opérations qui ont permis de produire le résultat soient iden-

tifiables à tout moment : elles doivent être traçables. La figure 1

schématise la logique des systèmes d’assurance qualité.

Par définition, le point de départ est le besoin du client. Pour être

opérationnel celui-ci doit être traduit sous la forme de spécifications

techniques propres, comme : une limite de détection, un temps de

réponse ou un domaine d’application. Ensuite, le laboratoire pourra

mettre en œuvre des moyens techniques (les instruments et les

réactifs) et un mode opératoire (la procédure) qui permettront

d’atteindre ces spécifications. Enfin, pour être, parfaitement sûr que

les spécifications sont atteintes, il faut valider la procédure, c’est-à-

dire apporter les preuves formelles que les résultats sont conformes

aux objectifs.

Sur la figure 1 apparaissent deux opérations qui étaient générale-

ment peu prises en compte dans les laboratoires, à savoir la docu-

mentation et l’archivage. En effet, l’assurance de la qualité exige

qu’à tout moment on puisse retrouver les éléments qui ont servi à la

production d’un résultat : numéros de lot des réactifs, données

d’étalonnage, conditions de fonctionnement des appareils… C’est

ce qu’on appelle la traçabilité des mesures.

Cette nouvelle organisation du travail des laboratoires peut avoir

des conséquences techniques intéressantes car elle montre qu’il

n’est pas toujours nécessaire d’appliquer une méthode sophisti-

quée et onéreuse pour répondre correctement à une demande.

Ainsi, à partir des spécifications, le laboratoire doit pouvoir établir

les moyens analytiques optimaux à utiliser.

Une autre conséquence de la logique qualité est de considérer

que la production des résultats d’analyse implique trois acteurs : un

producteur et un client mais aussi un organisme de contrôle qui

intervient pour vérifier que la logique qualité est bien respectée. Son

rôle est particulièrement net dans les domaines de la traçabilité et

de la métrologie.

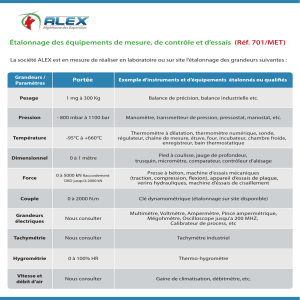

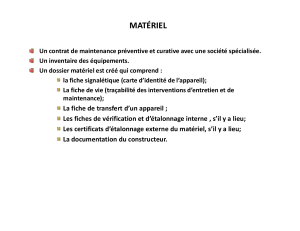

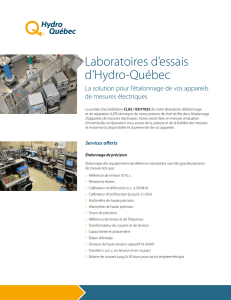

1.2 Organisation de la traçabilité

des mesures

Établir la traçabilité consiste à fournir à tout moment les informa-

tions et les documents qui permettent de savoir comment un résul-

tat a été obtenu. On doit pouvoir remonter de proche en proche et

sans interruption jusqu’à des systèmes d’étalonnage qui auront été

certifiés par des organismes officiels. Ainsi, tout équipement utilisé

pour effectuer des essais ou des étalonnages doit être étalonné ou

vérifié avant d’être mis en service. Le laboratoire doit disposer d’un

programme et d’une procédure établis pour l’étalonnage et la vérifi-

cation de son équipement, y compris l’utilisation des matériaux de

référence et des étalons de référence (encadré 1).

■La traçabilité du mesurage doit être assurée en ayant recours aux

services d’étalonnage de laboratoires qui peuvent apporter la

preuve de la traçabilité et de leur compétence. Les certificats d’éta-

lonnage délivrés par ces laboratoires doivent montrer qu’il existe un

lien avec un étalon primaire ou une constante naturelle reliée à

l’unité SI (Système International d’unités) (encadré 1) par une

chaîne continue d’étalonnages. Les certificats doivent contenir les

résultats de mesure, y compris l’incertitude de mesure ou une décla-

ration de conformité à une spécification métrologique identifiée.

Lorsqu’il est impossible d’établir la traçabilité aux unités de

mesure SI ou lorsqu’elle n’est pas pertinente, d’autres moyens

d’obtenir la confiance dans les résultats doivent être appliqués,

comme :

— la participation à un programme approprié de comparaisons

inter-laboratoires ou d’essais d’aptitude ;

— l’utilisation de matériaux de référence appropriés, certifiés et

caractérisés ;

— un essai ou un étalonnage par une méthode alternative ;

— des mesurages fondés sur les rapports et la réciprocité ;

— des normes ou des méthodes d’accord clairement spécifiées et

convenues par toutes les parties concernées.

Figure 1 – Logique de l’assurance qualité

Besoin

Spécification

Preuves

Moyens et procédureDocumentation Archivage

Validation de la procédureDocumentation Archivage

Exemple : un laboratoire de l’industrie pharmaceutique qui appli-

que les Bonnes pratiques de laboratoire (BPL) doit garder pendant au

moins 10 ans les traces des mesures effectuées dans le cadre de

l’étude d’un nouveau médicament. Cette obligation réglementaire est

lourde, surtout si le système d’archivage est informatisé et doit suivre

l’évolution des systèmes informatiques.

Exemple : l’analyse du calcium dans un verre, avec une incertitude

de 1,0 µg.kg– 1, ne requiert pas la même approche que l’analyse du cal-

cium à 0,2 g.kg– 1 dans un échantillon de terre.

Exemple : l’organisme de contrôle enverra des auditeurs qui véri-

fieront si le laboratoire utilise un système d’étalonnage reconnu,

archive ses résultats et gère correctement ses documents.

VALIDATION INTERNE DES MÉTHODES D’ANALYSE ___________________________________________________________________________________________

Toute reproduction sans autorisation du Centre français d’exploitation du droit de copie est strictement interdite.

P 224 − 4© Techniques de l’Ingénieur, traité Analyse et Caractérisation

Le laboratoire doit avoir un programme et une procédure pour

l’étalonnage et la vérification de ses étalons de référence. Plusieurs

situations peuvent alors se présenter, en fonction du type de matrice

ou de l’analyte recherché :

— si des étalons de référence (cf. encadré 1) peuvent être obte-

nus auprès d’organismes de métrologie compétents qui peuvent

fournir la traçabilité jusqu’aux étalons de référence universels, ils

doivent être utilisés seulement pour l’étalonnage et à nulle autre

fin ;

— lorsque des matériaux de référence (cf. encadré 1) traçables ne

sont pas disponibles ou si l’on est en présence d’étalons internes

(préparés par le laboratoire) ou extérieurs (par exemple, utilisés

dans un essai d’aptitude), il convient de montrer que ces matériaux

sont vérifiés dans toute la mesure des possibilités techniques et

économiques.

D’une façon générale, le laboratoire doit avoir rédigé des procédu-

res qui décrivent la manutention, le transport, le stockage et l’utilisa-

tion des étalons de référence, tels que les poids, et matériaux de

référence afin de prévenir toute contamination ou détérioration.

Dans le cas où on ne pourrait utiliser que des matériaux de référence,

comme lors d’un étalonnage d’une méthode en fluorescence X, ils

doivent, si possible, être raccordés à des unités de mesure SI ou à

des matériaux de référence certifiés internationaux ou nationaux.

■Le laboratoire doit établir un système coordonné pour identifier

les échantillons d’essai et d’étalonnage. L’identification doit être

conservée durant toute la durée de vie de l’échantillon dans le labo-

ratoire. Le système doit être conçu et géré de façon à garantir

l’impossibilité de confondre les échantillons, physiquement ou

lorsqu’il y est fait référence dans les enregistrements ou autres

documents. Le cas échéant, le système doit prévoir comment se fera

la subdivision ou le transfert des échantillons à l’intérieur ou hors du

laboratoire lorsque plusieurs mesures doivent être effectuées sur

des prises d’essai différentes.

Dans ce but, l’étape de réception d’un échantillon prend un rôle

prépondérant. Ainsi, à la réception de l’objet d’essai, toute anomalie

ou écart par rapport aux conditions normales, telles qu’elles sont

spécifiées dans la méthode d’essai ou d’étalonnage pertinente, doit

être enregistré. S’il y a le moindre doute quant à l’adéquation d’un

échantillon ou s’il n’est pas conforme à la description fournie ou

encore si l’essai demandé n’est pas spécifié avec une précision suf-

fisante, le laboratoire doit consulter le client pour obtenir de nouvel-

les instructions avant de procéder à l’essai. Le laboratoire doit

établir si l’objet a été convenablement préparé ou si le client exige

que la préparation soit réalisée par le laboratoire. Il n’est donc pas

surprenant que la mise en place d’un système qualité commence

souvent par une réorganisation de la salle de réception des échan-

tillons.

Le laboratoire doit disposer de procédures et d’installations

appropriées pour éviter la détérioration ou l’endommagement de

l’échantillon de travail lors de son stockage, de sa manutention, de

sa préparation et de l’essai. Lorsqu’il est nécessaire de stocker ou de

conditionner des objets dans des conditions ambiantes spécifiées,

ces dernières doivent être maintenues, surveillées et enregistrées.

Lorsqu’un échantillon ou une partie de cet objet doit être mis en

sécurité (par exemple pour des raisons d’enregistrement, de sécu-

rité ou pour permettre des essais ultérieurs), le laboratoire doit pré-

voir des dispositions de stockage qui protègent la condition et

l’intégrité de l’objet ou des parties de l’objet.

■La traçabilité doit devenir un souci permanent des analystes et du

personnel du laboratoire. Il est alors évident que les moyens infor-

matiques permettront de simplifier ces différentes opérations.

C’est pourquoi, lorsque des ordinateurs ou un équipement auto-

matisé sont utilisés pour la saisie, le traitement, l’enregistrement, le

rapport, le stockage ou la recherche de données d’essai ou d’étalon-

nage, le laboratoire doit s’assurer que :

— les logiciels sont documentés avec une précision suffisante et

convenablement validés ou vérifiés quant à leur aptitude à l’emploi ;

— des procédures sont mises en place et appliquées pour proté-

ger l’intégrité des données ; de telles procédures doivent inclure,

mais non exclusivement, l’intégrité de la saisie ou du recueil des

données, leur stockage, leur transmission et leur traitement ;

— les ordinateurs et appareils automatisés sont entretenus afin

de garantir un bon fonctionnement et disposent des conditions

ambiantes et opérationnelles nécessaires à la préservation de l’inté-

grité des données.

Encadré 1 : étalons et matériaux de référence

■Système international d’unités ou système SI : il fut créé en

1960 par la Conférence Générale des Poids et Mesures. Dans le

système SI, on distingue trois classes d’unités : les sept unités

de base ; les unités dérivées et les unités supplémentaires. Les

unités de base sont : le mètre, le kilogramme, la seconde,

l’ampère, le kelvin, la candela et la mole.

■Étalons primaires : étalons matériels conservés par le Bureau

International des Poids et Mesures (BIEM) qui servent à matéria-

liser, quand c’est possible, les unités de mesure. Par exemple, la

masse en platine iridié du Pavillon de Breteuil sert à étalonner

toutes les masses de 1 kg utilisées dans le monde, à travers un

ensemble d’étalons secondaires traçables. Toutes les unités de

mesure ne possèdent pas une forme matérialisée.

■Étalons de référence : ils doivent être étalonnés par un orga-

nisme capable de fournir la traçabilité de leur valeur de réfé-

rence, à partir d’étalons de référence primaires. C’est pourquoi

on les appelle aussi étalons secondaires extérieurs. Par exem-

ple, ce sont des masses qui serviront, à intervalle régulier, à véri-

fier l’exactitude des balances. Ces masses pourront aussi faire

l’objet d’un étalonnage régulier, réalisé par un organisme com-

pétent. Les étalons de mesure de référence doivent être utilisés

seulement pour l’étalonnage et à nulle autre fin, sauf si l’on peut

montrer que leur performance en tant qu’étalons de référence

ne sera pas invalidée.

■Matériaux de référence certifiés (MRC) : matériaux de réfé-

rence dont la valeur est établie par un organisme compétent

comme le Bureau National de Métrologie (BNM), le Bureau

Communautaire de Référence (BCR) ou le

National Institute for

Sciences and Technology

(NIST). Ils servent à matérialiser, pour

un analyste et une matrice donnés, la mole. Une procédure clas-

sique consiste à déterminer la valeur de référence au moyen de

méthodes d’analyse basées sur des principes variés, afin d’évi-

ter les biais systématiques. Par exemple, on utilisera la spectro-

métrie d’absorption atomique, la polarographie impulsionnelle,

l’activation neutronique et la spectrométrie d’émission plasma

pour certifier la teneur en nickel ou en fer d’un acier.

■Matériaux de référence : ils sont utilisés par les laboratoires

d’analyse comme étalons de référence pour établir indirecte-

ment la traçabilité de la plupart des analytes vis-à-vis de la mole,

pour laquelle il n’existe pas d’étalon matériel. En général, leur

valeur de référence est établie par consensus, si plusieurs labo-

ratoires ont participé à son élaboration, mais elle peut aussi être

obtenue par des répétitions multiples. Chaque fois que possible,

les matériaux de référence doivent être raccordés à des unités

de mesure SI ou à des matériaux de référence certifiés interna-

tionaux ou nationaux. Lorsque des matériaux de référence tra-

çables ne sont pas disponibles, les matériaux de référence

interne doivent être vérifiés dans toute la mesure des possibili-

tés techniques et économiques.

Exemple : il n’est pas rare d’utiliser un système d’étiquettes à

code-barres pour identifier un échantillon. Dès réception, le nombre

convenable d’étiquettes est imprimé en fonction de la demande qui

accompagne l’échantillon et à tout moment on peut savoir l’état

d’avancement des analyses d’après les enregistrements réalisés par

chaque cellule analytique.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

1

/

24

100%