REPUBLIQUE ALGERIENNE DEMOCRATIQUE ET POPULAIRE Université de Batna Faculté des sciences

REPUBLIQUE ALGERIENNE DEMOCRATIQUE ET POPULAIRE

Université de Batna

Faculté des sciences

Département de mathématiques

Thèse de Doctorat d’ Etat

Présentée par :

Guedjiba Said

Sur les k

G- inverses d’opérateurs linéaires

Soutenue le : 21-11-2005

Devant le jury :

M. Denche Professeur à l’univ. De Constantine Président du jury

R. Benacer Professeur à l’univ. De Batna Rapporteur

M. Deghdak Maître de conférences à l’univ. De Constantine Examinateur

K. Messaoudi Maître de conférences à l’univ. De Batna Examinateur

B. Teniou Maître de conférences à l’univ. De Constantine Examinateur

ﺹﺨﻠﻤ

ﻥﻜﻴﻟ

E

ﻭ

F

لﻘﺤﻟﺍ ﺱﻔﻨ ﻰﻠﻋ ﻥﻴﻴﻋﺎﻌﺸ ﻥﻴﺌﺎﻀﻓ ﺘﻌﻨ ،ﺭﺒ

E

→

F

:

A

ﺎﻴﻁﺨ ﺍﺭﺜﺅﻤ . ﺭﺜﻜﺍ ﺩﺤﺍ لﻭﺎﻨﺘﻴ ﺙﺤﺒﻟﺍ ﺎﻋﻭﻴﺸ ﺕﺎﻴﻀﺎﻴﺭﻟﺍ ﺕﺎﻋﻭﻀﻭﻤﻭ،ﺔﻴﻁﺨﻟﺍ ﺕﺍﺭﺜﺅﻤﻟﺍ ﺕﺎﺒﻭﻠﻘﻤ ﻉﻭﻀﻭﻤ ﻭﻫ ﻥﺍ ﺙﻴﺤ ﺔﻟﺩﺎﻌﻤﻟﺍ

yAx=

ﻞﺤﻠﻟ ﺔﻠﺑﺎﻗ نﻮﻜﺗ

ﻲﻄﺨﻟا ﺮﺛﺆﻤﻟا نﺎآ ﻰﺘﻣ

A

ﺐﻠﻘﻠﻟ ﻼﺑﺎﻗ ، يأتﻻﺎﺤﻟا ﻦﻣ ﺮﻴﺜآ ﻲﻓ ﻖﻘﺤﺘﻳ ﻻ يﺬﻟا ﺮﻣﻻا اﺪه ﻼﺑﺎﻘﺗ ﺮﺛﺆﻤﻟا نﻮآ ، ﺎﻣ ﻮه و

بﺮﻗا صاﻮﺥ ﻪﻟ ﺮﺛﺆﻣ ﻦﻋ ﺚﺤﺒﻟا ﺐﻠﻄﺘﻳيدﺎﻌﻟا بﻮﻠﻘﻤﻟا صاﻮﺥ ﻦﻣ نﻮﻜﺗ ﺎﻣ .

يدﺎﻌﻟا بﻮﻠﻘﻤﻟا نﺎآ اذﺎﻓ

B

ﻦﻴﺘﻟدﺎﻌﻤﻟا ﻖﻘﺤﻳ

F

IAB= و

E

IBA=،لﺎﺜﻤﻟا ﻞﻴﺒﺳ ﻰﻠﻋ و ﻪﻧﺎﻓ ، ﺮﺛﺆﻤﺑ ﻲﻔﺘﻜﻧ ﺪﻗ

B

ﻖﻘﺤﻳ

ىﺪﺡإ، ﻦﻴﺘﻟدﺎﻌﻤﻟا ﺎﺘﻠآ وأ

QBA

=

و

P

A

B

=

، ﺚﻴﺡ

P

و Q ﻦﻴﺋﺎﻀﻔﻟا ﻰﻠﻋ ﺎﻃﺎﻘﺳإ ﻲه

E

و F، نا ذإ ﺐﻴﺗﺮﺘﻟا ﻰﻠﻋ

صاﻮﺨﻟا ﺚﻴﺡ ﻦﻣ ﺔﻘﺑﺎﻄﻤﻟا تاﺮﺛﺆﻤﻟا ﻰﻟا تاﺮﺛﺆﻤﻟا بﺮﻗا ﻲه تﺎﻃﺎﻘﺳﻻا .ﻨﺘﻳ ﺎﻨﺜﺤﺑ لوﺎ

P

و Q ﻦﻣ اروﺬﺟ ﺎﻤهرﺎﺒﺘﻋﺎﺑ

ﺔﺒﺗﺮﻣ

kتﺎﻃﺎﻘﺳﻻ . ﻭﻋﺩﻨ

k

1-ﺭﺜﺅﻤﻟﺍ ﺎﻤﻤﻌﻤ ﺎﺒﻭﻠﻘﻤ EFB →: ﻕﻘﺤﻴ ﻯﺩﻟﺍ ،

*

,)( INkAAAB k

∈

=

ﻥﻭﻜ ﺔﻟﺎﺤ ﻲﻓ ﻭ

A

k

1- ﺎﺒﻭﻠﻘﻤ ﺎﻤﻤﻌﻤ

B

ﻰﻋﺩﻴ ﻪﻨﺈﻓ

k

G-ﺎﻤﻤﻌﻤ ﺎﺒﻭﻠﻘﻤ . لﻭﺎﻨﺘﻴ ﺙﺤﺒﻟﺍ , ﺕﻻﺩﺎﻌﻤ ،ﺔﻴﻓﻭﻔﺼﻤﻟﺍ ﺕﻻﺩﺎﻌﻤﻟﺍ ﺎﻬﻨﻤ ﺭﻜﺩﻨ ﻲﺘﻟﺍ ﺕﺎﻘﻴﺒﻁﺘﻟﺍ ﺽﻌﺒ ،ﻑﻴﺭﺎﻌﺘﻟﺎﺒ ﺔﻘﻠﻌﺘﻤﻟﺍ ﺹﺍﻭﺨﻟﺍ ﻰﻟﺍ ﺔﻓﺎﻀﺍ

لﺤ ﻲﻓ ﻥﺘﻭﻴﻨ ﺔﻘﻴﺭﻁ ،ﺔﻴﻁﺨ ﺕﺍﺭﺜﺅﻤﺒ لﻜﺸﻟﺍ ﻥﻤ ﺔﻟﺩﺎﻌﻤ

0)(

=

xf

ﻲﻓ ﺔﻤﻤﻌﻤﻟﺍ ﺕﺎﺒﻭﻠﻘﻤﻠﻟ ﺔﻴﺒﻴﺭﻘﺘ ﺹﺍﻭﺨ لﻭﺎﻨﺘﻴ ﺎﻤﻜ ،ﺔﻴﻤﻴﻅﻨﻟﺍ ﺕﺍﺀﺎﻀﻔﻟﺍ.

ﺔﻴﺣﺎﺘﺘﻓﻻا تﺎﻤﻠﻜﻟا

ﻲﻄﺥ ﺮﺛﺆﻣ ،

k

1- ،ﻡﻤﻌﻤ ﺏﻭﻠﻘﻤ

k

G-،ﻁﺎﻘﺴﺍ ، ﻡﻤﻌﻤ ﺏﻭﻠﻘﻤ ﻟﺍ ﺭﺩﺠ ﻱﺩﺎﻴﺤﻟﺍ ﻕﻴﺒﻁﺘ.

REMERCIEMENTS

Je tiens à exprimer ma reconnaissance à Mr R. Benacer pour les

conseils et les encouragements qu’il m’a accordés.

Je remercie vivement Mr. M. Denche qui m’a fait le grand honneur de

présider le jury.

Je remercie également Messieurs M. Deghdak, K. Messaoudi, et B.

Teniou pour avoir accepté de faire part du jury.

Je remercie une autre fois Mr K. Messaoudi, directeur du LTM pour

l’assistance materielle et technique, ainsi que tous ceux qui ont contribué

à l’élaboration de ce travail.

SOMMAIRE

Notations ..................................................................3

Introduction ..........................................................4

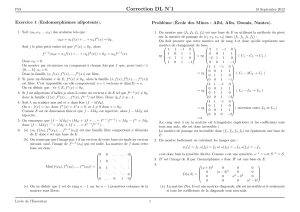

Chapitre1

0-Preléminaires .....................................................................7

1- 1 Dé…nitions et exemples .................................................8

1- 2 Existence de 1kinverse, Gkinverse ..........................12

1- 3 Gkinverse d’un bloc de Jordan ..................................16

1- 4 Méthode de calcul .......................................................19

1- 5 Sur les racines de l’unité ...............................................22

1- 6 Equations matricielles ...................................................26

Chapitre 2

2-Introduction ...................................................................29

2- 1 Inversion dans les espaces pré-Hilbertiens .................31

2- 2 Forme de A0dans des bases singulières::....................32

2- 3 Détermination de A0par paassage à la limite .............35

2- 4 L’inverse de Moore-Penrose .........................................36

2- 5 Discontinuité de l’inverse de Moore-Penrose ..................38

1

2- 7 Proprietés approximantes ......................................... ...40

2- 8 Methode de Newton ....................................................43

Chapitre 3

3- 1 Proprietés algèbriques des inverses généralisés ..................47

3- 2 Existence de 1kinverses , Gkinverses ............................52

3- 3 1kinverses , Gkinverses et projections ..........................54

3- 4 Sur la théorie de Nashed-Votruba .....................................58

3- 5 Equations à opérateurs linéaires .......................................59

Chapitre 4

4- 1 Inversion dans les espaces de Banach ................................63

4- 2 Inverses des opérateurs ................................................66

4- 3 Sur les racines de l’identité......................................... .....67

4- 4 Approximation dans les espaces de Hilbert .......................71

4- 5 Cas mixtes .........................................................................73

4- 6 Décomposition suivant une proj. ........................................74

Conclusion ........................................................................78

Annexe ............................................................................79

Bibliographie......................................................................85

2

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

1

/

90

100%