pour - AgroParisTech

APPROCHE CHIMIOMETRIQUE

DES RESULTATS D’UNE ANALYSE CHIMIQUE

Christian J. Ducauze et Arlette Baillet-Guffroy

1

APPROCHE CHIMIOMETRIQUE

DES RESULTATS D’UNE ANALYSE CHIMIQUE

-Résumé-

1-

Introduction : définition d’une analyse chimique

- L’analyse chimique peut se définir comme une suite d’opérations élémentaires

statistiquement indépendantes les unes des autres

2- Obtenir une donnée analytique : démarche habituelle des analystes

- Le résultat d’une analyse doit être considéré comme une variable aléatoire continue

- Description statistique d’une distribution de valeurs expérimentales (résultats des n

répétitions d’une analyse) : moyenne et estimation de l’écart-type

- Une loi de probabilité théorique : la loi Normale. Notions de mode (= valeur probable

= espérance mathématique de la variable X), de variance, de risque de première espèce

- Expression classique du résultat (donnée analytique) : moyenne et intervalle de

confiance estimé de la moyenne

- Elimination des « aberrants »

3- Réflexion sur la démarche des analystes

- La démarche probabiliste habituelle : ajustement des résultats d’analyse obtenus

expérimentalement à une loi Normale (par suppression des valeurs extrêmes ou par

transformation de la variable)

- Une démarche non probabiliste : la donnée analytique est fournie par la médiane de la

distribution des résultats expérimentaux

4- Etude d’un exemple

- Présentation de l’étude : estimation de la concentration en plomb dans du foie de bœuf

à partir de 20 analyses statistiquement indépendantes les unes des autres

- Ajustement à la loi Normale (tests d’ajustement) par suppression des valeurs

extrêmes (les « aberrants ») ou par transformation de la variable

- Comparaison des données analytiques produites à la suite d’une démarche probabiliste

à celles que fournit une démarche non probabiliste

5- Conclusions et discussion

- Pertinence de la démarche probabiliste : application du Théorème Central Limite

- La médiane est préférable à la moyenne pour exprimer le résultat de l’analyse, c’est-à-

dire la donnée analytique attendue

- La moyenne est utile pour repérer les valeurs « aberrantes » qui ont été obtenues

2

APPROCHE CHIMIOMETRIQUE

DES RESULTATS D’UNE ANALYSE CHIMIQUE

1 – Introduction : définition d’une analyse chimique

Cette approche chimiométrique est une réflexion sur la façon dont peuvent s’appliquer

quelques notions statistiques simples et bien connues à un ensemble de résultats d’analyses

chimiques. Il est donc nécessaire d’avoir compris ce qu’est une analyse chimique : on peut la

définir comme une suite d’opérations élémentaires, indépendantes les unes des autres – au

sens statistique de ce terme –, qui commencent au moment du prélèvement l’échantillon

analytique (prise d’essai) et aboutissent à un résultat, exprimé le plus souvent sous forme

d’une concentration.

Quelques précisions sont utiles pour éclairer cette définition :

1. Chaque « opération élémentaire » correspond à une action particulière de

l’expérimentateur, par exemple « effectuer une pesée », « prélever un volume connu de

réactif », « porter à une température déterminée » ou encore « lire le résultat d’une

mesure », etc.

2. « Indépendance statistique » veut dire que l’erreur expérimentale associée à chaque

opération élémentaire est sans influence sur les autres ; par exemple, l’erreur de lecture sur

un appareil de mesure ne dépend pas de l’erreur de pesée et inversement.

3. On a pris l’habitude de regrouper les différentes opérations élémentaires en quelques

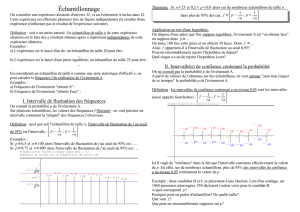

étapes principales, qui sont présentées sur la figure 1.

Le but est de mieux faire comprendre ici la démarche suivie pour élaborer une donnée

chimique – c’est « le » résultat attendu – à partir des résultats d’analyse qui ont été obtenus.

On va tout d’abord décrire la démarche habituelle de l’analyste pour essayer ensuite, à l’aide

d’un exemple, de mieux comprendre son fondement et juger de sa pertinence.

On supposera que la méthode d’analyse choisie a été préalablement validée, qu’il s’agit par

exemple d’une méthode de référence. Autrement dit, on fait l’hypothèse que cette méthode est

sensée fournir une valeur juste, c’est-à-dire acceptée comme telle par les différents

interlocuteurs que concerne cette analyse.

3

Figure 1 : Principales étapes d’une analyse chimique

2 - Obtenir une donnée analytique : démarche habituelle

des analystes

En appliquant la méthode d’analyse choisie à l’échantillon analytique, on obtient un premier

résultat x – en général la concentration de l’analyte (élément, ion ou molécule) dans

l’échantillon – qu’on pourrait considérer a priori comme la valeur recherchée. Mais

l’expérimentateur averti a aussitôt un doute car il sait qu’en répétant la même analyse sur le

même échantillon, il a peu de chances de retrouver exactement le même résultat ; il a

conscience du fait que le résultat obtenu contient une part d’erreur et que cette erreur ne sera

pas identique d’une analyse à l’autre ; il lui est en effet difficile de reproduire chaque fois, de

façon identique, toutes les opérations élémentaires de l’analyse. De fait, il faut considérer que

le résultat obtenu contient certes la valeur recherchée

Τ

mais aussi une erreur – appelée « aléa

expérimental » et désignée par e – qui résulte de l’erreur expérimentale attachée à chaque

opération élémentaire de l’analyse. On pose ainsi implicitement que le résultat x

i

obtenu à la

suite d’une analyse (i) est :

x

i

= T + e

i

(1)

Prélèvement de

l’échantillon analytique

Traitement de

l’échantillon

Conversion du signal

analytique

Conservation

Etalonnage Mesure

Résultat d’analyse

?

A interpréter et à valider pour pouvoir

disposer d’une donnée analytique

4

e

i

étant une variable aléatoire et T, la Teneur ou valeur vraie (« True value »), qui est une

constante pour l’échantillon considéré.

Il y a donc lieu de considérer que x

i

est une variable aléatoire,

puisque c’est la somme de la

variable aléatoire e

i

et de la constante T. Comme e

i

, x

i

peut théoriquement prendre une infinité

de

valeurs ; en d’autres termes, entre deux valeurs parfaitement déterminées de x

i,

une infinité

de valeurs sont possibles et, si ce n’est pas le cas en pratique, c’est parce que les appareils de

mesure utilisés pour l’analyse fournissent des valeurs arrondies, que le statisticien nommerait

« valeurs discrètes ». Cependant, d’un point de vue théorique, nous sommes bien amenés à

admettre que, x

i

pouvant prendre une infinité de valeurs, le modèle (1) conduit à définir le

résultat d’une analyse comme une variable aléatoire continue.

Le statisticien dira qu’il associe au résultat d’une analyse la variable aléatoire continue X qui

peut prendre une infinité de valeurs x

i.

Son réflexe sera alors de rechercher la loi de

distribution de X, autrement dit d’essayer de comprendre comment sont statistiquement

distribuées les valeurs x

i

de X.

L’analyste a le même réflexe : en répétant plusieurs fois son analyse, il va chercher à se faire

une opinion sur la dispersion des résultats x

i

et à tirer une conclusion qu’il exprimera en

fournissant la donnée analytique.

L’analyse va donc être répétée n fois, n étant d’autant plus grand que la dispersion attendue

des x

i

est plus forte. La suite est connue : partant des n valeurs x

i

obtenues, on va calculer une

moyennex et une estimation de l’écart-type s, soit :

n

x

x

n

ii

∑

=

=

1

(2)

1

)(

1

2

−

−

=

∑

=

n

xx

s

n

ii

(3)

Il faut s’arrêter un instant sur cette expression de s. Il s’agit, en effet, d’une estimation de

l’écart-type et non de l’écart-type σ, tel que le définit le statisticien. En effet, lorsque le

statisticien étudie la loi de distribution d’une variable aléatoire X, il définit tout d’abordx, qui

est la moyenne arithmétique d’un échantillon de n valeurs x

i

de la variable X, pour considérer

que lorsque n augmente indéfiniment, x tend vers une valeur limite µ, appelée moyenne de la

population, soit :

n

x

x

n

ii

nn

∑

==µ

=

∞→∞→

1

limlim

(4)

On dit aussi que µ est la valeur probable de X ou encore l’espérance mathématique de X,

désignée par E(X), ou enfin le mode de la distribution.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%