Chapitre 2 – Processus aléatoires - Etud.insa

Chapitre 2 – Processus aléatoires

• Définition

Un processus aléatoire peut être défini comme une

variable aléatoire dépendant explicitement d’un ou

plusieurs paramètres. Dans notre cas, d’un seul

paramètre : le temps.

• Exemple

- Considérons le processus aléatoire constitué des fonctions

où dépendent du jet d’un dé, donc

du hasard .

Chaque fonction est un signal aléatoire, on dit une réalisation

du processus

cos( )At

,,A

Chapitre 2 – Processus aléatoires

• Plus formellement

• Soit un univers associé à une expérience aléatoire

Un processus aléatoire (stochastique) est défini par

• On peut l’interpréter comme

- Une famille de fonction dépendant de

- Une simple fonction de t lorsque

- Une variable aléatoire lorsque

- Un nombre lorsque

( , ( ), )PP

ou

( , ) ( , )

T

t X t

X

et t

est fixé

est fixét

et sont fixést

Chapitre 2 – Processus aléatoires

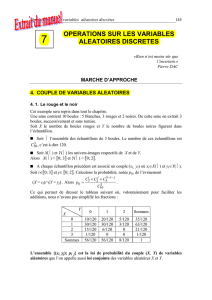

• Exemple (suite)

• Lorsque est fixé, on obtient une réalisation qui est une fonction du

temps, prise dans un ensemble de fonctions sinusoïdales.

• Lorsque est fixé on obtient une simple variable aléatoire qui peut

prendre valeurs réelles.

• Lorsque et sont fixés, on obtient un simple réel.

( , ) ( )cos( ( ). ( ))X t A t

t

3

6 216

3

6 216

t

Chapitre 2 – Processus aléatoires

• Si le temps est discret, c’est-à-dire que le hasard

intervient à des instants aléatoires connus a priori, on

parle de processus à temps discret, dénombrable.

• Si le temps est continu, le hasard se manifeste à tout

instant, on dit que le processus est à temps continu,

ensemble continu.

• Si la variable aléatoire prend des valeurs dans un

ensemble discret, le processus est dit à état discret.

• Si la variable aléatoire prend des valeurs dans un

ensemble continu, le processus est dit à état continu.

• On peut avoir toutes les combinaisons possibles, par

exemple : temps continu, état discret…

T

T

Chapitre 2 – Processus aléatoires

• Fonction de répartition d’ordre 1

Si l’on fixe le temps, on obtient une variable aléatoire,

soit qui peut être caractérisée par sa fonction de

répartition dite d’ordre 1

• Densité de probabilité d’ordre 1

La densité de probabilité d’ordre 1 est la dérivée de par

rapport à

1

()Xt

1 1 1 1 1

( , ) Pr ( )F x t X t x

1

F

1

x

1 1 1

1 1 1 1

( , )

( , ) F x t

f x t x

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

1

/

23

100%