La recherche à l’Institut Géographique National Activité 2002

La recherche

à l’Institut Géographique National

Activité 2002

La recherche en 2002

01 Classement IGN-SR : 03-001/R-LIV

02 Livre

03 Nom et adresse du directeur de la publication

Jacques Poulain

IGN, Direction Technique

2-4 avenue Pasteur

F-94165 SAINT MANDE CEDEX

04 Rédacteur en chef

Serge Motet

IGN, Direction Technique, Service de la Recherche

2-4 avenue Pasteur

F-94165 SAINT MANDE CEDEX

05 Réalisé au Service de la Recherche de l'IGN

Institut Géographique National

2-4 avenue Pasteur

F-94165 SAINT MANDE CEDEX

06 Titre : La recherche en 2002

07 Date d'édition : 2003/3

13 Numéro 74

15 Nom de la collection : Bulletin d'Information de l'IGN

Résumé

Ce numéro 74 dresse le bilan de l'activité de recherche en 2002 à l'Institut Géographique National. Outre le bilan des quatre

laboratoires de l'IGN, il présente des résultats concernant la restitution automatique des bâtiments en trois dimensions, l'ortho-

photographie à grande échelle, le levé laser aéroporté, la prise de vue aérienne numérique en infrarouge, la correction des mesures

issues du GPS, l'unification d'informations géographiques, l'ordonnancement puis l'évaluation des outils de généralisation automatique,

les logiciels pour l'Internet consacrés à l'information géographique, la mesure du champ de pesanteur terrestre et de la rotation de la

Terre ainsi qu'une analyse de risque appliquée au réseau de métro parisien.

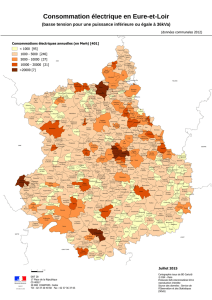

En couverture

Indice de centralité intermédiaire sur le réseau métro+RER de Paris intra-muros dans une logique de desserte uniforme du

territoire. Les valeurs obtenues correspondent à la densité de probabilité de fréquentation des stations et des arcs du réseau pour un

déplacement aléatoire sur le territoire. La loi probabiliste d'un tel déplacement est telle que les stations de départ et d'arrivée sont les

accès au réseau les plus proches d'un couple origine-destination tiré aléatoirement sur le territoire parisien. La gamme des valeurs

s'étend de 0 à 25% (du jaune clair au marron foncé). Seule une partie du réseau est présentée ici sur un extrait IGN du plan de Paris

centré sur le 1er arrondissement.

Mot-clé principal : Information géographique.

Mots-clés : IGN, recherche, cartographie, géodésie, instrumentation, photogrammétrie, SIG, traitement d'image.

Abonnement gratuit, courrier & publications, s’adresser à :

Isabelle Melot

IGN, Direction Technique,

2-4 avenue Pasteur

F-94165 SAINT MANDE CEDEX

BD ALTI, BD CARTO, BD TOPO, BD ORTHO, GÉOROUTE et FEIV sont des marques déposées de l'Institut Géographique National

Table des matières

A. Bilan …………………………………………………………………………………………………………………………. 1

A.1 La recherche à l’IGN (S. Motet) …………………………………………………………………………………….. 1

A.2 Les travaux du laboratoire MATIS (M. Pierrot Deseilligny) ………………………………………………………. 5

A.3 Les travaux du laboratoire OEMI (Ch. Thom) ..……………………………………………………………………. 7

A.4 Les travaux du laboratoire COGIT (A. Ruas) ……..………………………………………………………………. 9

A.5 Les travaux du laboratoire LAREG (M. Kasser) ………………………………………………………………….. 13

B. Quelques actions marquantes …………………………………………………………………………….. 15

B.1 Prototype de logiciel pour la réalisation de BD Bâti 3-D (G. Maillet & D. Flamanc) …………………………. 15

B.2 Fabrication de vraies ortho-images et correction des ombres (D. Boldo) ……………………………………. 25

B.3 Le levé laser aéroporté : techniques, applications et recherche (O. de Joinville,

S. Saur & F. Bretar) ...……….………………………………………………………………………………………. 37

B.4 Un canal proche infrarouge pour la caméra numérique de l’IGN (J.-Ph. Souchon & Ch. Thom) ...……….. 53

B.5 Développement d’un lidar Raman pour le sondage de la vapeur d’eau et la correction des délais

troposphériques en GPS (O. Bock, J. Tarniewicz, Y. Morille, J. Pelon & Ch. Thom) ………………………. 63

B.6 Unification des bases de données géographiques (S. Mustière, N. Gesbert & D. Sheeren) ……………… 71

B.7 L'évaluation de la généralisation (S. Bard) ……………………………………………………………………… 79

B.8 Coordination multi-agents pour la généralisation automatique (C. Duchêne) ……………………………… 87

B.9 Fonctionnalité et vulnérabilité du réseau de métro parisien (J.-F. Gleyze) …………………………………. 97

B.10 « Oxygène » : une plate-forme inter-opérable pour le déploiement

de services Web géographiques (Th. Badard & A. Braun) …..……………………………………………..... 113

B.11 Simulation du champ de pesanteur à partir d'un modèle géologique en trois dimensions :

un outil pour l'évaluation des méthodes de calcul de géoïde (O. Jamet) …………………………………… 123

B.12 Combinaison de séries temporelles des positions des stations et des paramètres

de rotation de la Terre (Z. Altamimi) …………………………………………………………………….……… 131

C. Publications …………………………………………………………………………………………………………134

Thèses de doctorat ……………………………………………………………………………………………………… 134

Rapports de mi-thèse (doctorats) …………………………………………………………………………………… 135

Articles (journaux scientifiques) ……………………………………………………………………………………… 135

Autres articles ……………………………………………………………………………………………………………. 136

Articles parus dans ce bulletin ……………………………………………………………………………………….. 136

Communications à congrès ………………………………………………………………………………………….. 137

Livres ………………………………………………………………………………………………………………………. 138

Chapitres de livres ……………………………………………………………………………………………………… 139

Rapports de stage ……………………………………………………………………………………………………… 139

Rapports internes & comptes rendus ……………………………………………………………………………….. 140

A.1 La recherche à l'IGN

Serge Motet

Ce bulletin n°74 dresse le bilan des activités menées en 2002 par l'Institut Géographique National (IGN) dans le

cadre de sa mission de recherche.

La recherche de l'IGN se caractérise par ses domaines de compétence et ses finalités.

Les domaines sont ceux qu'utilisent l'IGN dans son activité de production : instrumentation pour la topographie et

la localisation, photogrammétrie, traitement d'image, système d'information géographique, cartographie et géodésie.

Concernant les finalités, elles sont déterminées en fonction d'une activité future. Plus précisément, les

connaissances développées par l'IGN visent :

à l'amélioration de la productivité de l'IGN, par exemple : les études sur la détection de changements et la mise

à jour des bases de données ;

•

•

•

•

•

•

•

au développement de nouveaux produits, par exemple : les images de la caméra numérique ou la diffusion des

mises à jour ;

à l'émergence des applications, par exemple : les études sur les risques.

Organisation de la recherche

L'IGN est un établissement public à caractère administratif, dont une des missions est la recherche. Cette

recherche est mise en œuvre au sein de quatre laboratoires :

le laboratoire MATIS : (Méthodes d’Analyse et de Traitement d’Images pour la Stéréorestitution) pour la

photogrammétrie et l'analyse d'image ;

le laboratoire OEMI (Laboratoire d’OptoÉlectronique et de Micro-Informatique) pour l'instrumentation et les

capteurs ;

le laboratoire COGIT (Conception Objet et Généralisation de l’Information Topographique) pour les systèmes

d'information géographique et la cartographie ;

le laboratoire LAREG (LAboratoire de REcherche en Géodésie) pour la géodésie.

Les trois premiers laboratoires se trouvent à Saint-Mandé (Val-de-Marne, 94). Le laboratoire LAREG est une

unité de l'Ecole nationale des sciences géographiques (ENSG) et se situe donc à Marne-la-Vallée (Seine et Marne, 77).

L'orientation et l'évaluation de la recherche sont soumises à un Comité scientifique et technique placé auprès du

Directeur général.

Quelques points marquants

En traitement d'image, l'année a été marquée par le démarrage significatif des études sur le laser aéroporté et le

lancement des recherches sur les modèles de bâtiments à partir de données issues de levés terrestres, photogram-

métriques ou laser.

En instrumentation, on notera les premiers résultats de l'activité d'analyse de concentration de vapeur d'eau qui

vise à améliorer la mesure de l'altitude par GPS.

En information géographique, on citera la fin d'un projet européen sur l'intégration d'information à plusieurs

échelles et le lancement d'un nouveau projet sur un moteur de recherche géographique sur l'Internet.

En géodésie, on retiendra une contribution de la géodésie spatiale à la connaissance des mouvements de la

plaque européenne.

Bulletin d’Information de l’IGN n° 74 (2003/3) 1

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

1

/

144

100%