Proposition_2013_longue.pdf

1

Une étude de

)(r

n

l

, la longueur de la plus longue suite de succès

obtenue au moins r fois en n épreuves de Bernoulli

jkentzel@ac-toulouse.fr

Notations : On considère

n

)1( n

épreuves successives de Bernoulli, désignées par

1

C

,

2

C

…

n

C

.

On désigne par

p

)10( p

la probabilité d’un succès,

)1( i

CPp

.

Soit

r

un entier,

nr 1

.

)(r

n

l

est la variable aléatoire : longueur maximum (d’une suite de

succès) obtenue au moins

r

fois, chacune des

r

suites étant séparée des autres par (au moins)

un échec si

1r

.

Exemple avec

20n

: 1111 0 111 0 11 0 1111 0 111 (suite plausible si

p

est assez grand) :

4

)2(

20

)1(

20 ll

,

3

)4(

20

)3(

20 ll

,

2

)5(

20 l

,

0

)(

20

r

l

si

5r

.

On va notamment s’intéresser au mode de

)(r

n

l

dont la probabilité est étonnamment grande.

A priori

nr 1

mais on s’intéresse surtout à des valeurs de

r

pas trop grandes, par exemple parce que

10

)(

r

n

lP

si

2/nr

.

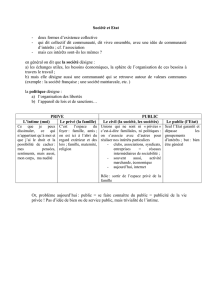

L’origine de cette étude est une activité proposée à des élèves de la classe de première, dans le cas

particulier où

2/1p

et

1r

, activité reposant sur le fait que dans ce cas

96,05

)1(

200 lP

,

décrite sur cette page et utilisant cette simulation.

La variable aléatoire

)1(

n

l

est bien connue sous le nom de « longest head run ». ([Biblio1])

1 ) ETUDE D’UNE VARIABLE ALÉATOIREAUXILIAIRE

Notations : Pour

nk 1

, une

k

-suite est une suite de

k

succès consécutifs.

)(k

n

D

kn

D,

est la variable aléatoire : nombre de

k

-suites, disjointes, et séparées (s’il y en a

plusieurs) par (au moins) un échec, obtenues.

Exemple avec la suite considérée ci-dessus :

5

)2(

20

)1(

20 DD

,

4

)3(

20 D

,

2

)4(

20 D

,

0

)(

20

k

D

si

205 k

.

L’intérêt de

)(k

n

D

va immédiatement apparaître.

On peut vérifier que si

1k

,

klP r

n)(

)( )( rDP k

n

)( )1( rDP k

n

: (3)

Lien entre

)(k

n

D

et

)(r

n

l

Encadré 1

L’événement « il y a au moins

r

k

-suites » est à la fois

rD k

n

)(

et

kl r

n

)(

:

On en déduit :

kl r

n)(

kl r

n)(

1

)( kl r

n

rD k

n

)(

rD k

n

)1(

. (2)

Toute

)1( k

-suite contient une

k

-suite donc la suite

k

k

nrD )( )(

est décroissante.

On a donc

rDP k

n

)(

(

)

)1( rD k

n

)( )( rDP k

n

)( )1( rDP k

n

et (2) implique : pour

1k

,

klP r

n)(

)( )( rDP k

n

)( )1( rDP k

n

. (3)

Le calcul de

klP r

n

)(

est ainsi parfaitement connu pour les petites valeurs de

n

et de

k

car on a

des formules de récurrence sur

n

et

r

donnant

)( )( rDP k

n

pour tout

1r

:

2

Loi de

)(k

n

D

Encadré 2

Soit

k

un entier fixé,

1k

. On écrit

)(k

nn DD

dans cet encadré.

Supposons d’abord que

2 kn

.

Soit

r

un entier fixé. On suppose que

1r

. ( le cas

0r

est trivial :

1)0( )(

k

n

DP

)

Tout repose sur le fait que l’événement

rD k

n

)(

=

rDn

se traduit par :

soit il y avait déjà au moins

r

k

-suites après la

ème

n)1(

épreuve

soit il y en avait

1r

et la

ème

r

apparaît sous la forme 0111…11.

rDn

est donc la réunion disjointe de

rDn

1

et de

1

1rDn

1...01 nknkn CCC

=

1

1rD kn

1...01 nknkn CCC

.

On a alors une intersection d’événements indépendants dont la probabilité est

.)1( 1

rDP kn

)1...().0( 1 nknkn CCPCP

, c’est à dire

[

)1( 1

rDP kn

)( 1rDP kn

] .

k

pp1

.

On a donc

)( rDP n

=

)( 1rDP n

+ [

)1( 1

rDP kn

)( 1rDP kn

] .

k

pp1

. (5)

Il reste à calculer les valeurs initiales (initiales en

n

) pour

1r

.

La formule de récurrence (ne) fonctionne (que) si

11 kn

, soit

2 kn

. (5’)

Il y a donc a priori (

1k

) termes à calculer « à la main ».

Le premier terme non nul de la suite

n

k

nrDP

)(

est obtenu pour

1 rrkn

et il vaut

1

1

r

r

kpp

, c’est la probabilité d’obtenir

r

suites de

k

succès séparées par

1r

échecs.

On n’utilise en fait cette dernière formule que pour

1r

car si

2r

,

1 rrkn

212 kk

et d’après (5’) tous les termes à calculer « à la main » sont nuls.

Dans le cas où

1r

, on a alors le premier terme non nul avec

krrkn 1

et on calcule

seulement

kk

kpDP )1( )(

et

1)( 12)1(

kkk

kppDP

.

La formule (5) montre qu’on a aussi une récurrence sur

r

:

les résultats au rang

r

nécessitent ceux au rang

1r

.

A l’aide d’un tableur on a

facilement représenté ci-contre

chacune des suites

3501

)( )((

n

k

nrDP

pour

2r

et

k

entre 1 et 8 dans le cas

6,0p

.

Ces suites

n

k

nrDP )(( )(

sont,

évidemment, (strictement)

croissantes et elles convergent

vers 1.

Figure 1

P (D_n(k)>=2), k entre 1 et 8

0

0,2

0,4

0,6

0,8

1

1,2

121 41 61 81 101 121 141 161 181 201 221 241 261 281 301 321 341

k = 1

k = 2

k = 3

k = 4

k = 5

k = 6

k = 7

k = 8

3

2 )APPLICATION A LA LOI DE

)(r

n

l

Utilisant la formule (3),

klP r

n)(

)( )( rDP k

n

)( )1( rDP k

n

, on obtient par exemple :

Figure 2

L’allure de ces courbes, croissantes puis décroissantes, n’est pas étonnante car pour chaque

r

fixé, si

1k

, chaque suite

n

r

nklP )( )(

est obtenue, en vertu de (3), en soustrayant deux

suites

n

k

nrDP )(( )(

consécutives, consécutives en

k

.

Le cas

0k

est à part, car on n’a défini

)(k

n

D

que si

1k

donc (3) n’est pas valide si

0k

, mais

il ne pose pas de problème de calcul :

rDPrDPlPlP nn

r

n

r

n

)1()1()()( 1110

.

Parmi les suites

n

r

nklP )( )(

, les suites

n

r

n

lP )0( )(

sont les seules à être monotones

(décroissantes). Sur la figure 2 on a tracé seulement

nn

lP )0( )1(

Voir des dessins en couleurs sur les courbes qui suivent

Il semble qu’on ne dispose pas de formules explicites permettant de calculer

klP r

n

)(

(sauf dans le cas

1r

où ces formules sont très compliquées).

3 ) APPROXIMATIONS

On peut prouver par la méthode dite de Stein-Chen que si

p

est assez petite et si

n

et

k

, surtout

n

,

sont assez grands (ces conditions sont précisées plus loin; on suppose seulement a priori que

1k

),

)(k

n

D

suit (approximativement) une loi de Poisson.

R Arratia, L Goldstein et L Gordon-1989 « Two moments suffice for Poisson approximations : the

Chen-Stein method »

Description du principe utilisé Encadré 3

Rappel : Soit

un réel fixé entre 0 et 1. On désigne par

i

S

,

*

INi

,des variables de Bernoulli

indépendantes et identiques de paramètre

. Pour tout

1n

, on pose

nn SSSX ...

21

.

4

n

X

compte les « succès » au cours des

n

premières épreuves et suit la loi binomiale

);(

nB

.

si

n

avec

petit et

n

grand (on précise parfois :

01,0

,

100n

et

101

n

),

alors

n

X

suit approximativement la loi de Poisson de paramètre

.

Principe de la preuve :

kn

k

nk

n

kXP

1..

=

kn

k

kknnn

1..

!)1)...(1(

donc si

est petit et

k

est petit devant

n

:

kXP n

n

k

k

k

n

1..

!

1

.

!)( Lnn

ke

k

n

n

ke

k

n

.

!)(

. (6)

L’hypothèse

petit est essentielle. La loi de Poisson est parfois dite loi (de comptage) des événements rares.

Principe de la méthode de Stein-Chen

Soit

n

un entier (non nul) fixé.

Nos variables indépendantes de Bernoulli,

1

C

,

2

C

…

n

C

suivent la loi

pCP i )1(

.

Soit

k

un entier (non nul) fixé,

nk

.

On peut observer l’apparition d’une suite ininterrompue d’au moins

k

succès au moment

si et

seulement si

k

et

1... 11

CCC k

.

Une telle suite est « nouvelle » et doit être comptabilisée au temps

(

k

) si et seulement si

k

et

1...

21

k

CCC

ou bien si

1 k

et

1...111

CCCC kk

On pose

kk CCCS ...

21

et si

1 k

,

CCCCS kk 11...1

.

nk S

est le nombre de suites ininterrompues (et disjointes) d’au moins

k

succès observées à

l’instant

n

, c'est-à-dire que

)(k

n

nk DS

.

Pour

1 k

, toutes les variables

S

sont des variables de Bernoulli suivant la même loi

définie par

k

ppSP 11

.

Le problème est que ces variables

S

ne sont pas indépendantes.

Toutefois, chaque variable

S

est indépendante de toutes les variables

S

vérifiant

k

.

Ainsi, si

n

est bien plus grand que

k

,

nk

k

k

nSSD

1

)(

où la somme

nk S

1

apparaît

comme « assez proche » d’une somme de

)( kn

variables de Bernoulli indépendantes de même

loi, donc, suivant notre rappel, d’une variable suivant une loi de Poisson de paramètre

k

ppkn 1

.

Par ailleurs

kk

nk

k

nk

k

nppknpSESESEDE

1)()( 1

)(

et c’est ce

dernier nombre qu’on prend a priori comme paramètre de notre approximation de Poisson de

)(k

n

D

.

On désigne cette loi de Poisson par

)(k

n

N

kn

N,

. Son paramètre est

11

, pknpk

kn

.

Ceci signifie que

!!

,

,,s

e

s

esNP s

s

kn

kn kn

. (7)

5

La qualité, très bonne quand

p

est assez petite, de cette approximation de

)(k

n

D

par

)(k

n

N

est précisée

en annexe. On y verra que

kk

n

k

npkANPADP

INA

Sup )22(

)()(

. Cette majoration de

l’erreur est satisfaisante car on va voir que c’est surtout quand

2/1p

qu’on a des résultats

intéressants cependant que les petites valeurs de

k

sont accessibles informatiquement.

L’ identité (3) s’écrit aussi

klP r

n)(

)(1 )( rDP k

n

))(1( )1( rDP k

n

.

On a donc pour l’instant, pour

1k

,

klP r

n

)(

)( )1( rDP k

n

)( )( rDP k

n

d’où

klP r

n

)(

1

0

,1, ,1, !

)(

!

r

s

s

kn

s

kn knkn e

s

e

s

. (8)

Deuxième approximation Encadré 4

La dérivée de cette fonction (de la variable

n

) est compliquée, comme le lien entre

11

, pknpk

kn

et

111

1

1,

pknpk

kn

.

Par ailleurs, il va de soi que lorsqu’on s’intéresse aux variations de

klP r

n

)(

quand un des

nombres

p

,

r

,

n

et

k

varie, les trois autres sont fixés mais on va voir que dans les calculs qui

nous intéresseront (on ne cherche que des grandes probabilités !),

k

sera de l’ordre de

nLn

.

Il s’ensuivra que dès que

n

sera un peu grand, le rôle de

k

dans la valeur de

11

, pknpk

kn

sera plus important à cause de la présence de

k

p

que de celle de

kn

.

Il est donc raisonnable de remplacer dans ce qui précède

11

, pknpk

kn

par

pnpXk 1

et

1, kn

par

pX

. L’erreur qui en résulte est quantifiée en annexe (où on verra

qu’elle est d’autant plus faible que

p

est petite, et négligeable dès que

k

grandit un peu).

On voit que cette simplification revient à approximer

)(k

n

D

par une loi de Poisson dont le

paramètre,

pnpk1

, est un peu plus simple que celui de

)(k

n

N

.

En remplaçant

11

, pknpk

kn

par

pnpXk 1

et

1, kn

par

pX

dans (8), on

obtient :

!

)( )( r

X

erDP r

Xk

n

avec

pnpXk 1

d’où

klP r

n

)(

1

0!!

r

s

X

s

pX

se

s

X

e

s

pX

1

0)(

!

r

s

XpXs

seep

s

X

. (8’)

Soit

r

un entier fixé,

nr 1

.

On désigne par

nn k

r

k

cette nouvelle approximation de

klP r

n

)(

:

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%