Pourquoi virtualiser une base de données

© APPEX 2012 - Reproduction interdite sans autorisation écrite préalable

APPEX, 42, Rue Galilée 75016 PARIS - Fixe : +33 (0) 1 49 24 93 61 Page 1 / 2

Virtualisation de bases de données : régime sec pour le Big Data !

Source : IT Business Edge,

Auteur : Jed Hueh, CEO DELPHIX

Date : 18 juillet 2012

Les entreprises sont saturées par des volumes de

données en croissance constante.

Les Data Centers ingèrent des données issues d'une

multitude de sources qui, elles-mêmes augmentent

chaque année.

Les utilisateurs aujourd'hui génèrent et consultent de

grands volumes de données à partir de supports

variés : smartphones, tablettes tactiles, ordinateurs

personnels portables ou fixes, ou serveurs.

Les satellites, capteurs, signaux GPS, réseaux sociaux,

appareils photos et caméras, tous contribuent à

enrichir, en volumétrie, le Big Data.

De nouvelles technologies ont émergé pour gérer

toutes ces données (Hadoop, NoSQL, etc.).

Ces nouvelles technologies ne sont pas parvenues

encore à traiter efficacement la source la plus

importante, et certainement la plus onéreuse du Big

Data dans les entreprises aujourd'hui : les applications

qui accèdent aux bases de données relationnelles.

Le commerce mondial dépend étroitement de ces

applications qui accèdent à ces bases, comme les

ERP, le CRM, la Business Intelligence, les sites de

commerce électronique, etc.

Les bases de données de l’entreprise constituent un

patrimoine informationnel vital. Il est de la

responsabilité du département informatique de le

maintenir et de le protéger des agressions potentielles.

De manière à se prémunir, entre autres, contre les

incidents des applications en production, les

organisations informatiques créent des environnements

structurés, en couches, pour le développement, les

tests, l'assurance qualité, l'intégration, le reporting

opérationnel, la formation et les projets pilotes. Puis, les

organisations informatiques créent des copies

supplémentaires de tous ces environnements pour les

sauvegardes et les restaurations en cas de sinistre.

Une base de production, unique, d'1To, peut facilement

générer 30 To au regard de cette succession de

couches supplémentaires. Cette masse de données

finale n’a pour conséquence que d’augmenter la

quantité de matériel nécessaire et peut parfois étouffer

certaines organisations informatiques.

Une fois crée un environnement de développement ou

de test, celui-ci peut aussitôt devenir obsolète, ne

reflétant plus les derniers enregistrements de

l'environnement de production. En conséquence de

quoi, les organisations informatiques doivent rafraîchir

ces environnements, distribuant les données d'un lieu à

un autre. Dans le but de sauvegarder ces

environnements, des copies systématiques doivent être

réalisées de manière journalière ou hebdomadaire,

ajoutant encore une manipulation supplémentaire au

niveau des données.

Chaque rafraîchissement des données, sauvegarde ou

restauration ajoute une charge sur les serveurs, les

baies de stockage, le réseau, et se conclut par une

copie redondante des données. La gestion de cette

diffusion de données nécessite des efforts coordonnés

d'équipes informatiques multiples : les DBAs de

production, les gestionnaires d'infrastructures, les

administrateurs système, les DBAs projet.

Toutes ces différentes couches et ces multiples tâches

alourdissent considérablement les charges et les

processus des organisations informatiques, ralentissant

leur capacité d'innovation et limitant l’agilité des

Directions Métiers à répondre à des opportunités

commerciales ou à des menaces de la concurrence.

C'est l’une des principales raisons du retard et du

dépassement de budgets des projets informatiques.

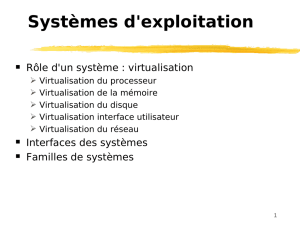

Ces dernières années, les technologies de virtualisation

ont participé à la transformation des data centers, en

consolidant des CPUS et des serveurs sous-utilisés et

en réduisant les coûts et les délais de mise à

disposition des serveurs. L’adoption de cette notion de

virtualisation dans l’écosystème des bases de données

a connu une forte résistance et offert de faibles retours

sur investissement. Aujourd'hui, l'opportunité majeure

pour la virtualisation et la consolidation n'est plus au

niveau du serveur mais au niveau des données. C’est

tout le positionnement de Delphix.

© APPEX 2012 - Reproduction interdite sans autorisation écrite préalable

APPEX, 42, Rue Galilée 75016 PARIS - Fixe : +33 (0) 1 49 24 93 61 Page 2 / 2

Pourquoi virtualiser une base de données ?

Pourquoi est-il nécessaire de créer et d’envoyer

toutes les copies de bases de production vers tous

les environnements de non-production lorsque 98%

de ces données sont redondantes ?

Virtualiser les données des bases relationnelles peut

offrir de sérieuses économies et permettre des gains

très importants aux organisations.

Chaque fois que Facebook se déploie dans un

nouveau pays, l’entreprise doit adapter ses applications

financières pour tenir compte de la législation locale. En

virtualisant ses bases avec la solution Delphix,

Facebook peut générer de nouveaux environnements

de développement, de tests et d'assurance qualité en

quelques minutes -sans ajouter de nouveaux matériels-

permettant ainsi à Facebook de répondre rapidement à

de nouvelles opportunités et poursuivre son

développement à l'international.

Une des plus grandes banques mondiales, a

récemment réalisé une montée de version du référentiel

de son application de gestion de risque boursier en une

seule journée en générant un bac à sable virtuel pour la

réalisation des tests. Avant l'utilisation de la solution

Delphix, il aurait fallu à cette organisation six mois pour

la mise à disposition de ce nouvel environnement de

test.

Alors qu'aujourd'hui les développeurs se sont habitués

à disposer de leur propre machine virtuelle pour

permettre la réalisation de tests isolés, ils doivent

souvent partager les mêmes bases physiques. Cela

engendre de sérieuses difficultés en termes

d’organisation et de gestion des priorités provoquant

des retards dans les calendriers des projets et les

livraisons des versions applicatives.

StubHub, une division d'Ebay, fournit maintenant à

ses développeurs leurs propres bases de données

virtuelles indépendantes grâce à Delphix qui a

transformé leur approche économique de la gestion des

bases de données.

Gérer les données à travers les différents

environnements est un travail minutieux qui nécessite

une solution qui fournit la cohérence transactionnelle, la

synchronisation des données entre plusieurs sources,

la gestion du transport, et la virtualisation des données.

Le support d'une base comme Oracle peut être très

complexe, nécessitant une maîtrise et des

compétences sur les bases opérationnelles, les

entrepôts de données, les technologies RAC et Data

Guard.

Delphix est une plateforme de virtualisation des

données dotée d’une interface conviviale et complète

de gestion. C’est déjà une solution largement déployée

au cœur des data centers d'aujourd'hui.

La virtualisation est une technologie éprouvée qui a

transformé l'utilisation des serveurs et des CPUs. Avec

Delphix, l'époque où il fallait des jours pour créer et

déplacer des copies de bases physiques est révolue.

Les organisations peuvent désormais faire mieux avec

moins en virtualisant leur infrastructure de base de

données.

Production Development Unit Test QA Cutover Test Reporting

10:1

Ratio de consolidation

des bases

Delphix remplace le matériel complexe par du logiciel intelligent qui virtualise vos bases de données

Fourniture de BDs à la demande,

integration, synchronisation,

et retour arrière

VDB

Les VDB fonctionnent à

l’identique des bases

physiques

1

/

2

100%