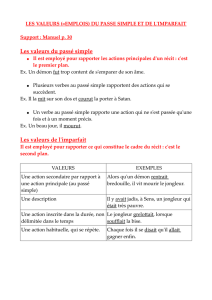

9 .2 Bernard Laur

Le Dsi en jongleur chinois

Technologie, réseaux, sécurité, développements… Face à leurs évolutions, comment

maintenir la continuité des services rendus par l’informatique ? Quelques réponses

donnés par Bernard Laur, consultant en stratégie informatique.

Lorsque l’on ne tient pas seulement compte de la première facture, mais de toutes celles qui suivent (formation,

assistance, administration...) le poste de travail est l’élément le plus onéreux d’une architecture informatique. A

150€ l’heure de technicien, on a vite fait de mettre en l’air l’économie d’un projet. Certains choix peuvent s’avérer

très pénalisants.

On peut citer à cet égard l’exemple de la ville de Munich. Son projet de migration de ses postes de travail vers

Linux a déjà pris un an de retard. Menée dans deux ou trois ans, on peut penser qu’une telle opération se

passera sans difficulté. Aujourd’hui, ça marche, mais seulement à 90%. Les performances du noyau ne sont pas

en cause. On manque simplement encore de code d’environnement, et pour les 10% restant, il n’y a pas les bons

drivers, ou le bios pose problème… Souvenons-nous qu’à ses débuts, windows NT ne marchait que sur machines

neuves. Il a mis 10 ans à percer et à devenir compatible avec tous les drivers des machines. On le critique parce

qu’il serait « trop gros ». Tellement gros qu’il va fonctionner peut-être à 96%. 96% contre 90%, c’est ce qui fera

toute là différence des coûts, et de l’économie de deux projets.

Depuis 15 ans, l’informatique s’est popularisée et les discours sur l’informatique, en parallèle, sont devenus

simplistes. Mais laisser s’appliquer les règles de conduite de l’informatique individuelle dans l’entreprise conduirait

à un résultat dantesque.

En informatique grand public, on ne gère pas un parc, on remplace tout. Souvent aussi, on perd tous. Des années

de photos par exemple. L’informatique grand public ne connaît pas le problème de l’informatique de l’entreprise :

faire vivre dans le temps ses programmes et ses données, à coup de migrations et de gestion d’héritage. Ce qui

se traduit presque toujours par : gérer une diversité d’architectures.

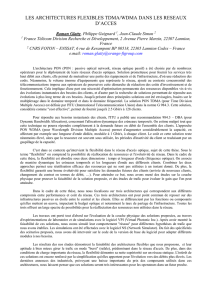

Le directeur informatique ressemble à un jongleur chinois avec ses assiettes. Il doit en ajouter sans cesse, sans

casser celles qui tournent déjà. L’hétérogénéité du parc est un état de fait : il n’y a pas les budgets pour tout

changer en permanence. Il y a des solutions intéressantes qui permettent de reprendre une partie de l’héritage,

le déport d’interface par exemple, mais il n’existe pas de solution uniforme : technologies et architectures sont

multiformes.

Bien sûr, on pourra trouver

le

cas de la nouvelle architecture-panancée et celui de l’entreprise qui a réussi à tout

migrer en même temps. Mais le cas général reste celui d’une dualité entre une partie de l’architecture qui

récupère l’existant et la fait tourner, tandis qu’une autre partie est tournée vers l’avenir. Il faut faire cohabiter

mainframes et peer-to peer, en même temps que des architectures client/serveur à plusieurs niveaux.

Puissance, sécurité, développements

Les cycles de l’innovation se sont beaucoup accélérés. Tous les équipements offrent une puissance suffisante par

rapport aux usages que l’on peut envisager d’en faire. Les derniers smartphones ont la puissance des PC d’il y a

3-4 ans, avec des disques durs de 5 Go. A comparer avec les 3 Go de données d’un poste de travail classique. Le

Pda apparaît davantage comme un hybride. Même s’il est meilleur en entrées/sorties, il est en perte vitesse sur

le marché. Sans supprimer le PC, le smartphone permettra de consulter celui-ci, où que l’on soit. L’absence de

clavier est un désavantage, pour aujourd’hui. Mais lorsqu’on montre un blackberry à « des jeunes », c'est-à-dire à

ceux qui formeront le personnel des entreprises dans quelques années ils demandent : « pourquoi un clavier

azerty ? »

Les réseaux deviennent pervasifs et l’internet synchrone. Dans sa nouvelle version, la livebox de France Telecom

bascule du Gprs au wifi. Certains opérateurs nordiques proposent de passer par Skipe. Le Pc portable de Fujitsu

intègre un décodeur Tnt. Sony voit ses ventes percer grâce à la qualité de ses écrans. Le poste de travail se doit

d’être mobile, multifonctionnel, avec « tout dans la boîte ».

La montée en puissance des réseaux et des serveurs laisse apparaître une croyance dans des « postes de travail

légers » où l’on trouverait moins de choses et qui seraient éventuellement moins puissants. Une diminution de la

puissance ? Cela ne s’est encore jamais vu. Et il faut être très prudent. Faire tourner un OS demande de la

puissance. Obtenir une bonne restitution aussi. Les économies de bande passante, pour éviter les engorgements

et les pics, demandent de la compression. La sécurisation des postes, un gros enjeu, demande elle aussi

beaucoup de compression et du cryptage.

Auparavant, les programmes étaient compilés, pour un couple machine/Os. Aujourd’hui, ils deviennent

indépendants. Ils tournent sur n’importe quelle machine, avec n’importe quel Os. Ils sont interprétés sur la

machine, qui devient plus gourmande en puissance et en mémoire. La portabilité des applications repose sur leur

capacité d’interprétation, elle demande des postes de travail sophistiqués. Tout concourt à la nécessité de

disposer de puissance.

La problématique est celle du processus, de la continuité dans la chaîne du traitement de l’information, sans

reprise manuelle. D’où l’importance croissante du middleware, qui assure l’interopérabilité entre machines,

applications, réseaux et permet de lier des systèmes auparavant incompatibles entre eux.

1

/

2

100%