biodiversité HenkVanDijk2005

2005-1

Licence BOP + TPV

Biodiversité 1 - S5

-

cours Henk van Dijk -

2005

1. Chronologie des idées sur l'évolution et sur la biodiversité

2. L'origine de la vie

3. Les transitions majeures dans l'évolution

4. Evolution moléculaire et phylogénie

1. CHRONOLOGIE DES IDÉES SUR L'ÉVOLUTION ET SUR LA BIODIVERSITE

1.1. Les idées traditionnelles sur le monde vivant

1.2. Lamarck

1.3. Cuvier

1.4. Darwin

1.5. Soma et lignée germinale

1.6. La synthèse de génétique et évolution

1.7. La micro-évolution

1.8. La macro-évolution

1.9. L'évolution neutre

1.1. LES IDEES TRADITIONNELLES SUR LE MONDE VIVANT

L'idée que le monde vivant actuel est le résultat d'une évolution, dont les mécanismes agissent

toujours, est relativement nouvelle. Les conceptions traditionnelles étaient:

Le monde vivant a toujours été comme il est aujourd'hui et ne change pas systématiquement (Aristote)

La situation actuelle est le résultat d'une création qui était parfaite et qui a donc amené à une situation

stable et immuable (la tradition judéo/chrétienne).

Dans la culture européenne la dernière idée était la seule présente jusqu'au début du 19ème siècle. II existait

une unité des idées de la théologie et de la biologie. Plusieurs catégories se distinguent dans la création:

- les plantes

- les animaux inférieurs

- les animaux supérieurs

Dans chacune des catégories il y a un grand nombre d'espèces. Hors catégorie l'espèce humaine est le

couronnement de la création. L'espèce est l'unité de création; les membres actuels d'une espèce représentent

la totalité des descendants d'un même couple créé par Dieu. Ils ont la même essence. La variabilité intra-

spécifique observée était interprétée comme des imperfections par rapport au "type idéal".

Les deux biologistes les plus importants dans cette tradition étaient Linné et Buffon. Carl von Linné ou

Linneaus (1707-1778) a placé la plupart des espèces connues alors dans un système hiérarchique (1753-

1758). Ce système correspond en fait assez bien aux interprétations actuelles des relations évolutives entre

espèces, ce qui a sans doute contribué au milieu conceptuel dans lequel les théories évolutionnistes ont pu

se développer ultérieurement.

Buffon (1707-1788) a eu à son époque une très grande influence. Son "Histoire Naturelle" (1749) a

2005-2

été imprimée en nombreux exemplaires. Il a mis l'accent sur l'unité dans la nature plutôt que de s'intéresser à

la subdivision et à la classification.

1.2. LAMARCK

Jean Baptiste Pierre Antoine de Monet, Chevalier de Lamarck (1744-1829), né à Bazentin, un village entre

Albert et Bapaume, a été le premier vrai évolutionniste. On a pu suivre le développement de ses idées grâce à

ses "Discours d'ouverture", qui commençaient chaque année sa série de cours,

et qui, pour la plupart, ont été conservés.

En 1800 il a formulé pour la première fois la notion d'évolution (en 1799 il n'en

parlait pas encore). Lamarck avait la disposition, à partir de la fin des années

1790, d'une grande collection de mollusques, fossiles et vivants. II a remarqué

des analogies entre espèces fossiles et espèces actuelles. II semblait même

possible de définir des séries de fossiles selon la chronologie des strates où ils

étaient trouvés. Certaines de ces séries allaient sans interruption de l'ère

tertiaire au présent.

La possibilité que tout cela soit le résultat de beaucoup d'extinctions et de

nouvelles créations ne concordait pas avec les idées théologiques de l'époque:

la création était unique, sans trop de "miracles" après. A cela Lamarck a opposé

l'idée d'une évolution des espèces telle qu'elles restent bien adaptées à un

environnement continuellement changeant.

Ses idées:

- il existe une "force" interne poussant à une plus grande complexité de l'organisme;

- il y a des changements adaptatifs dus aux conditions particulières de l'environnement: les

organes les plus utilisés s'agrandissent, les organes peu utilisés diminuent de taille;

- cette adaptation est transmise aux descendants (-> l'hérédité des caractères acquis).

Ces mécanismes amènent à une évolution de chaque espèce pour obtenir/maintenir une bonne adaptation à

l'environnement et parallèlement à une augmentation en complexité, sans mettre en question l'espèce comme

unité de création.

1.3. CUVIER

George Cuvier (1769-1832), était le grand adversaire de Lamarck. II n'a jamais accepté l'évolution, bien

qu'ayant apporté beaucoup de nouvelles connaissances qui ont finalement soutenu la théorie de l'évolution.

Cuvier a développé l'anatomie comparée (vertébrés et invertébrés) et a fondé la paléontologie. Il a constaté que

chacune des strates géologiques (trouvées dans le bassin de Paris) possédait ses propres espèces, parfois

tout à fait différentes. N'acceptant pas l'évolution, il a dû expliquer ces différents ensembles d'espèces comme

étant le résultat d'un grand nombre de catastrophes successives causant l'extinction d'une partie des espèces.

Remarquez que selon Lamarck il n'y pas eu extinction mais transformation en d'autres formes (donc évolution).

Une autre idée assez répandue était la persistance ailleurs sur la planète des espèces disparues en Europe,

mais à l'époque de Cuvier il restaient encore peu de territoires inconnus qui pouvaient cacher, par exemple, des

mammouths!

1.4. DARWIN

Charles Darwin (1809-1882), Angleterre, est le père spirituel de deux

théories qui ont changé radicalement la biologie bien que n'ayant pas été

immédiatement acceptées par le monde scientifique. Comme Lamarck il a,

à un certain moment, rejeté l'idée d'un monde vivant statique depuis la

création, mais pour le reste il n'y a quasiment que des contrastes entre ces

deux hommes. Les deux théories révolutionnaires de Darwin, développées

en 1837 après son voyage sur le "Beagle" mais publiées seulement en 1859

("On the origin of species by means of natural selection or the preservation

of favoured races in the struggle for life") sont:

2005-3

- L'origine commune des espèces. Après avoir étudié des espèces animales sur les îles d'un même

archipel, il a adopté l'idée que les nombreuses espèces voisines, parfois une espèce par île, sont nées d'un

ancêtre commun. Ce concept de la spéciation comme origine des espèces implique que toutes les espèces

sont finalement originaires d'un seul ou de peu d'êtres qui ont vécu il y a très longtemps. Une conséquence très

choquante de cette théorie est que l'espèce humaine, faisant partie de ce système, a un ancêtre commun avec

les singes. Darwin a, pour ainsi dire, détrôné l'homme comme créature unique.

Bien que les différences entre espèces soient normalement bien nettes, l'évolution est, selon Darwin,

graduelle. Pour résoudre cette contradiction apparente il faut concevoir qu'une espèce est subdivisée en

populations géographiquement éloignées: celles-ci peuvent indépendamment accumuler des différences

jusqu'à ce qu'elles ne soient plus interfertiles et soient donc devenues des espèces nouvelles.

- La sélection naturelle. Cette théorie consiste en trois déductions basées sur quatre faits observés.

Fait 1: Toutes les espèces montrent une grande fertilité potentielle. Leurs populations augmenteraient

exponentiellement si tous les individus nés se reproduisaient à leur tour.

Fait 2: En dehors de petites fluctuations entre années et des grandes fluctuations exceptionnelles, les

populations sont normalement de taille stable. C'est sans doute une conséquence du fait que les ressources

naturelles sont limitées et assez constantes dans un environnement stable.

Déduction 1:

Comme il y a beaucoup plus d'individus produits que les ressources disponibles ne le

permettent, tandis que la taille de la population reste stable, il y a forcément une forte compétition entre

individus d'une population. Il en résulte que ne survit qu'une partie, souvent très petite, des jeunes de chaque

génération.

Fait 3: Tous les individus sont différents; chaque population montre une variabilité énorme.

Fait 4: Une bonne partie de cette variabilité est héritable (les mécanismes de cette hérédité étaient

totalement inconnus à l'époque de Darwin)

Déduction 2:

La survie n'est pas aléatoire, mais dépend pour une part de la constitution héréditaire des

individus. C'est cette survie inégale qui est à la base de la sélection naturelle.

Déduction 3:

Au cours des générations le processus de la sélection naturelle amènera à un changement

graduel des populations, c'est à dire, à l'évolution (et sous certaines conditions à la naissance de nouvelles

espèces).

La "force interne" de Lamarck, qui pourrait être considérée comme faisant partie de la création, est

remplacée par l'explication matérialiste de Darwin. Darwin n'a donc pas uniquement détrôné l'homme comme

étant unique parmi les créatures mais il a aussi "détrôné Dieu comme créateur".

1.5. SOMA ET LIGNEE GERMINALE

L'idée que les espèces existantes ont des ancêtres communs a été acceptée assez rapidement par les

collègues biologistes de Darwin. C'était déjà moins le cas avec le concept des changements graduels; le

"saltationisme" était très populaire à l'époque (l'évolution se déroule essentiellement par sauts d'une génération

à une autre). La sélection naturelle, finalement, n'avait initialement quasiment pas de partisans. Le mécanisme

proposé par Lamarck était apparemment plus logique et acceptable. Il y avait deux raisons à cela:

premièrement, l'influence de l'environnement sur les individus est très nette. C'est ce que nous appelons

actuellement la plasticité phénotypique. Deuxièmement, personne ne connaissait encore le mécanisme de

l'hérédité. L'idée courante était celle de la "pangénèse": l'information vient de partout dans le corps et passe par

les gamètes (en particulier les gamètes mâles) proportionnellement avec l'importance des organes. Plus un

organe se développe, plus grande sera sa contribution à la transmission par les gamètes.

C'est par les résultats de l'allemand August Weismann (1834-1914) que l'hérédité des caractères acquis de

Lamarck a été démentie. Il a constaté que, chez les animaux, il existe des lignées de cellules qui restent

essentiellement séparées du reste de l'organisme et qui servent à la reproduction (la lignée germinale ou le

germen). Ces cellules sont capables de former des organismes complets, mais, par contre, l'ensemble des

cellules spécialisées, le soma, n'a pas d'influence sur la lignée germinale autre que sa conservation. Cette

séparation de soma et lignée germinale est visualisée par la figure 1.1A (G, la lignée germinale, passe de

génération en génération; S, le soma, meurt avec l'individu).

2005-4

Fig. 1.1A: Soma et lignée germinale

Les plantes n'ont pas de lignée germinale; en principe chaque cellule est "totipotente" et peut se développer en

une plante entière. Néanmoins le principe de Weismann reste valable, mais il faut utiliser une formulation plus

générale: l'information passe entre les générations sans que les structures codées par cette information puissent

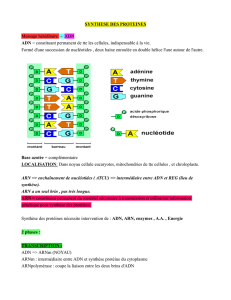

influencer ou modifier l'information à leur tour. Maintenant que l'on sait que l'ADN porte l'information génétique, et que

ce sont en premier temps les protéines, codées par l'ADN, qui constituent le phénotype, une meilleure présentation

est celle de la figure 1.113: il est évident que les modifications environnementales au niveau des protéines ne

modifient pas la séquence des nucléotides dans l'ADN. L'information dans l'ADN ne décrit pas l'organisme comme le

ferait une copie conforme (ce qui permettrait de répercuter dans l'ADN les modifications produites par

l'environnement sur l'organisme: l'idée de la pangénèse). L'ADN forme, par contre, un ensemble d'instructions,

nécessaire pour le développement de l'organisme du zygote à l'adulte et pour les processus biochimiques et

physiologiques pendant toute la vie. Il n'y a pas de moyen de modifier les instructions par leurs résultats. La seule

méthode pour changer les instructions au cours des générations est la sélection naturelle (et un mécanisme qui crée

une variation dans les instructions): les instructions les moins efficaces sont moins transmises aux générations

suivantes que celles qui marchent bien; les dernières augmentent donc en fréquence.

Fig. 1.113: C'est l'information sous forme d'ADN qui est transmise et non pas le résultat de cette information P

(protéines)

1.6. LA SYNTHESE DE GENETIQUE ET EVOLUTION

Tout au début du 20ème siècle les lois de Mendel ont été redécouvertes. Pendant une période qui a duré

jusqu'aux années 30, il y a eu une séparation en deux écoles: les "mendéliens" et les "biométriciens". Les mendéliens

ont surtout étudié les mécanismes de l'hérédité des polymorphismes; les variations continues étaient pour eux des

"bruits non-génétiques". Ils accentuaient le rôle des mutations, récemment découvertes, combiné avec une sélection

purifiante qui élimine les mutations délétères. Ils pensaient que l'évolution se déroulait par "la pression de mutation".

Même la spéciation serait le résultat de mutations avec un grand effet au niveau du génome entier.

Les biométriciens s'occupaient principalement de la variation continue (les caractères quantitatifs), dont l'hérédité

semblait être non-mendélienne. Pour eux, les caractères discontinus, obéissant aux lois de Mendel, étaient de peu

d'importance pour l'évolution. Les caractères continus semblaient avoir une hérédité "mélangeante": les jeunes sont

intermédiaires entre les deux parents. Comme mentionnée cidessus c'est l'influence apparente des facteurs

environnementaux sur les caractères continus qui a fait que les idées lamarckiennes étaient partout acceptées dans

ce milieu.

II a encore fallu une série de découvertes pour concilier et intégrer les deux vues:

• la distinction stricte de génotype (indépendant de l'environnement) et phénotype (variant avec l'environnement);

• plusieurs gènes (à petit effet) ainsi que l'environnement peuvent influencer un même caractère quantitatif; (d'un

autre côté: un gène peut influencer plusieurs caractères (pléiotropie); l'action d'un

gène peut aussi dépendre

d'un autre (épistasie) ;

•

la grande importance de la recombinaison comme source de variabilité.

2005-5

Le mécanisme génétique, maintenant donc bien connu, était en fait excellent pour expliquer d'un côté la

ressemblance entre parents et enfants ("fait 4" de la sélection naturelle, voir 1.3.) et d'un autre côté la variabilité

entre enfants ("fait 3" de la sélection naturelle). La génétique a ainsi donné une base solide à la théorie de

l'évolution darwinienne, si bien qu'elle peut sans problèmes tenir tête aux attaques qu'elle doit toujours subir.

Après la synthèse on parle de néo-darwinisme. En résumé elle dit que les gènes peuvent muter, se

recombiner chez les descendants et créer ainsi de la variabilité. La sélection fait le tri dans cette variabilité. Le

hasard joue également un rôle (voir 1.9).

Les systématiciens ont pendant cette période de plus en plus développé la notion que les espèces ne sont

pas des "types morphologiques", mais plutôt des ensembles de populations variables, ces ensembles étant

reproductivement isolés les uns des autres.

1.7. LA MICRO-EVOLUTION

Les changements à l'échelle des générations sont du domaine de la micro-évolution. La théorie des

changements de la composition génétique d'une population à cette échelle est présentée par la génétique des

populations, initiée par Hardy et Weinberg et développée dans toute sa richesse par Ronald A. Fisher (1890-

1962) et John B. S. Haldane (1892-1964) en Angleterre et Sewall Wright (1889-1988) aux EtatsUnis. Bien

qu'une partie des différences génétiques ne soit pas soumise à la sélection naturelle mais change

principalement par des processus aléatoires (l'évolution neutre, voir 1.9.), l'adaptation aux conditions

environnementales tend à s'améliorer au cours de l'évolution par la sélection naturelle. Cette tendance

permanente peut expliquer les adaptations étonnantes que l'on rencontre dans la nature, mais elle n'implique

cependant pas que l'adaptation augmente forcément tous le temps, car les conditions environnementales ne

restent pas constantes. Ce sont surtout les relations interspécifiques qui changent continuellement du fait que

les autres espèces (formant la partie biotique de l'environnement) évoluent également. Il faut donc s'améliorer

tout le temps ne serait ce que pour maintenir le même niveau d'adaptation.

1.8. LA MACRO-EVOLUTION

Bien qu'il y ait eu des grands débats sur les différences essentielles entre micro- et macro-évolution (les

"saltationistes" contre les "gradualistes") on peut dire que il n' y a en principe pas de nouveaux mécanismes

pendant la macro-évolution par rapport à la micro-évolution. La seule vraie différence est l'échelle de temps:

pour la macro-évolution cette échelle est plutôt en millions d'années au lieu d'être en générations. Néanmoins il

se manifeste de nouveaux phénomènes, notamment la spéciation et l'extinction des espèces. La spéciation est

un processus graduel, avec beaucoup de phases successives d'une divergence de plus en plus grande, mais,

sur une échelle paléontologique, c'est surtout la succession des espèces qui forme le bon niveau d'analyse. On

peut ainsi distinguer deux aspects différents que l'on peut visualiser ensemble sous forme d'un arbre

phylogénétique (voir figure 1.2): l'anagénèse (les changements dans une branche au cours du temps) et la

cladogénèse (la formation de branchements). Un tel arbre peut également montrer les extinctions qui ont eu

lieu. Les études de la macro-évolution visent à replacer les relations entre espèces dans une perspective

historique: quelles espèces, ou groupes d'espèces, ont un ancêtre commun; quand vivait cet ancêtre commun;

quelles espèces historiques sont éteintes? Un arbre phylogénétique qui est linéaire avec le temps en est la

meilleure visualisation. Pour la (re)construction d'un tel arbre, il y a deux sources d'information: les espèces

existantes et les fossiles. Il est en principe possible de construire un arbre seulement à partir des espèces

existantes, mais il est évident que les espèces éteintes manqueront dans ce cas. Les fossiles sont en plus

indispensables pour étalonner l'échelle de temps et peuvent fournir des points sûr dans une construction

essentiellement hypothétique.

Les données avec lesquelles on peut construire un arbre sont classiquement les caractères

morphologiques et, plus récemment, les différences au niveau moléculaire. L'application de l'évolution

moléculaire à la phylogénie sera développée dans le chapitre 4.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

1

/

35

100%