version PDF - Flash informatique

FI spécial été 2007 – 28 août 2007 – page 28

Haute Ecole ARC Ingénierie,

filière Informatique,

Le Locle

NeoBrain

contexte

À l’heure où l’on cartographie les génomes humains, le cerveau, organe de la pensée,

n’échappe pas au phénomène. Franz Joseph Gall fut le premier cartographe de nos fonc-

tions cognitives en 1881. Sa théorie est tombée dans les oubliettes à la fin du XIXe siècle. Il

était autrefois trop difficile d’aller à la pêche aux images dans les tréfonds de notre cerveau

en activité. Depuis, la technologie et la science ont fait bien des progrès, y compris en

cartographie cérébrale. On peut récupérer l’anatomie de notre cerveau grâce aux scanners

IRM. Ces scanners ont fait leur apparition dans les années 1980. Les données produites

sont fort précieuses, notamment pour des détections de cancer, mais insuffisantes pour

permettre d’analyser le fonctionnement de notre cerveau, qui n’est pas statique, mais vit

et évolue à chaque milliseconde.

Le domaine de recherche s’intéressant aux fonctionnements du cerveau s’appelle

l’imagerie fonctionnelle cérébrale. Cette imagerie rassemble des techniques permettant

d’obtenir une image du cerveau en activité, et pas seulement de décrire une anatomie figée

comme le fait l’IRM. Cette science a produit ses premiers résultats dans les années 1950

déjà, grâce à la tomographie par émission de positrons TEP. Cette modalité d’imagerie

fonctionnelle repose sur l’administration d’un traceur légèrement radioactif. Bien que jugé

non dangereux, cet aspect invasif laisse quelque peu perplexe. En particulier les doses de

radioactivité injectées soulèvent des problèmes de répétitivité des séances de scanning. La

précision temporelle de la TEP est par ailleurs médiocre. Deux

minutes sont nécessaires entre chaque mesure. Sa précision

spatiale n’est pas bien meilleure. Elle est de l’ordre de 1000

mm3. Pour les années 50 il s’agissait néanmoins d’un résultat

extraordinaire!

De nos jours, l’imagerie fonctionnelle tente d’exploiter au

mieux, individuellement ou en les combinant, les scanners

fonctionnels suivants se disputant le marché : l’IRMF et le

MEG (MagnétoEncéphaloGraphie). Ils sont tous les deux

non invasifs et ne présentent aucun risque pour le patient.

L’IRMF a une résolution temporelle comprise entre 1.5 et 6

secondes, et une résolution spatiale de 15 mm3. Nous allons

nous intéresser dans ce papier plus particulièrement au MEG

dont les propriétés sont bien meilleures.

le scanner fonctIonnel meg

Le MEG représente un fleuron de la technologie moderne.

Sa résolution temporelle est de l’ordre de la milliseconde, ce

qui est exceptionnel et en parfaite harmonie avec l’unité de

réaction de nos neurones.

le maillage anatomique 3D est obtenu

pas une segmentation des voxels

(pixels 3D) d’un IRM

scanner MEG mesurant l’activité neuronale

IMAGES – 28 août 2007 – page 29

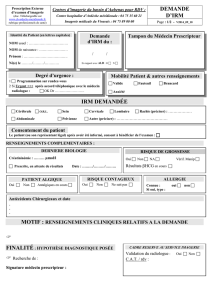

Le principal domaine d’application du MEG est le dia-

gnostic pré-opératoire en épilepsie. En effet, les capacités de

localisation du MEG ainsi que sa commodité d’utilisation en

font un outil de choix pour confirmer et localiser le (ou les)

foyer(s) épileptogène(s) déclencheurs de la crise avant résection

chirurgicale. Rappelons que la principale méthode employée

en 2006 reste l’implantation intracrânienne d’électrodes, ce

qui nécessite pour ce seul diagnostic une opération chirurgicale

délicate et fort invasive.

Le MEG est évidemment très onéreux et encore peu

répandu aujourd’hui. On en recense par exemple trois en

France et encore aucun sur le territoire Suisse. Ce scanner n’a

pas encore atteint le rang d’outil de routine clinique, mais

son usage se répand. Mis à part son prix prohibitif, il souffre

d’un problème majeur. Il ne fabrique pas de cartes neuronales

exploitables, mais se contente de mesurer périodiquement

des champs magnétiques de faible intensité. L’output est une

matrice où les lignes représentent les capteurs et où les colon-

nes représentent l’intensité temporelle. Cette matrice est déjà

extrêmement précieuse, ceci d’autant plus que le pas temporel

est la milliseconde. Il serait toutefois bien plus agréable de

disposer d’une même matrice où les lignes représenteraient

cette fois-ci les sommets du maillage obtenu par segmentation

des voxels d’une IRM. C’est à ce niveau qu’intervient le projet

NeoBrain, dont le but est de déterminer cette matrice!

le projet neobraIn

La construction de la matrice sommet x intensité à partir de

la matrice capteur x intensité est connue sous le nom du pro-

blème inverse, que l’on rencontre en imagerie fonctionnelle

cérébrale, mais aussi par exemple en physique des plasmas. Ce

problème est très complexe. Les champs magnétiques sont

déformés par les tissus cellulaires traversés entre les foyers

d’émission neuronaux (apparentés aux sommets du maillage)

et leur point de mesures externes (les capteurs). L’information

mesurée par les capteurs est de surcroît fortement bruitée, par

la faible intensité du champ (proche du champ magnétique

terrestre), par l’électronique des capteurs, et par les micro-

mouvements du patient.

Les données fonctionnelles d’activités neuronales sont ainsi

très bruitées, mais possèdent la qualité non négligeable d’être

obtenues de manière non invasive ! La grande difficulté du problème inverse est donc d’ef-

fectuer un recalage des données fonctionnelles sur les données anatomiques, tout en tenant

compte de la déformation du champ magnétique et du bruit greffé au signal mesuré.

carte neuronale

Un des principaux objectifs du projet NeoBrain est le développement d’un modèle

mathématique permettant la fabrication des cartes neuronales du cortex, avec pour input

des données anatomiques provenant d’un IRM et des données fonctionnelles issues d’un

scanner MEG dont la fenêtre de temps est de l’ordre de la milliseconde. NeoBrain se propose

donc de résoudre le problème inverse, ie de relocaliser les foyers sources d’où sont issus

les champs magnétiques. Il s’agit de répondre aux interrogations suivantes : si un capteur se

trouve en (x, y, z) et qu’il mesure une intensité k, quel groupe de neurones en est la cause ?

Quelle valeur d’intensité associer à ces neurones ? Toutes les mêmes ? Est-il judicieux de

tenir compte des capteurs voisins? Est-il nécessaire de tenir compte de l’intensité antérieure

ou postérieure ? Si oui, quelle dimension associer à cette notion de voisinage spatial et de

voisinage temporel ? ...

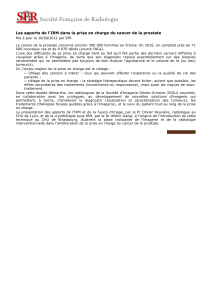

NeoBrain

implantation d’électrodes invasives, 2006

champ magnétique émis par les neurones (intérieur) et mesuré

par les capteurs MEG (extérieur)

FI spécial été 2007 – 28 août 2007 – page 30

résultats

Le modèle stochastique développé a été imputé de contraintes relaxables décrivant des

corrélations spatiales et temporelles sur l’espace des activités neuronales. Autrement dit,

deux capteurs proches, dans l’espace ou le temps, devraient selon notre bon sens posséder

des valeurs proches, ou tout du moins corrélées.

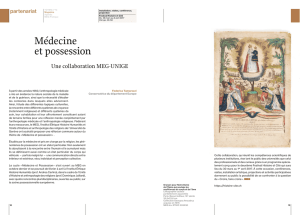

Le modèle stochastique sur champs de Markov développé dans NeoBrain produit à un

temps t fixé, une carte neuronale comme celle de la figure ci-dessous.

Un grand challenge a été relevé. Notre cerveau nous délivre ses secrets, enfin, presque:

Il reste au spécialiste de neurosciences cognitives un long travail périlleux d’interprétation.

Ce chemin-là est encore long et sinueux.

analyse des résultats

Le talon d’Achille des cartes dynamiques produites par NeoBrain est de fonctionner

dans un spectre restreint en neuroscience, ou les variations neuronales temporelles ne sont

pas brusques. Des simulations ont montré une légère tendance du modèle à gommer les

brefs pics intenses d’activités neuronales présentes lors des crises d’épilepsie par exemple.

Ces crises sont donc pour l’instant en dehors du domaine de validité de NeoBrain. Pour

les autres pathologies où les variations temporelles sont plus lisses et moins brusques, le

modèle mis en place actuellement est fonctionnel. Malheureusement, les traitements

numériques nécessaires à la construction de la carte temporelle effectuée sur une seule

machine nécessitent de longues heures de calculs pour des cortex à 6000 sommets et

2000 mesures d’intensité pour capteur MEG. La complexité de l’algorithme est estimée

élevée. La tendance à utiliser des scanneurs offrant une finesse spatiale supérieure tend à se

généraliser aujourd’hui. Dès lors, le besoin en calcul sera encore plus important demain. Il

s’agit d’un vrai problème de haute performance, nécessitant une parallélisation du modèle,

pour une exploitation en un temps raisonnable.

vIsualIsatIons des cartes neuronales

Le projet NeoBrain ne se contente pas de calculer des cartes neuronales. Il offre aussi

une plate-forme de visualisation et d’exploitation ergonomique des cartes neuronales. Il

permet de naviguer dans l’espace et le temps avec un taux de rafraîchissement de l’ordre

de 60 FPS. Des périphériques issus du monde aéronautique ont été interfacés pour piloter

finement les scènes infographiques et le player de neurones. Le retour de force permet

d’informer le clinicien d’une pathologie particulière. Différentes cartes et cortex peuvent

être synchronisés pour des analyses comparatives d’évolution d’une pathologie. Son module

de vision stéréo permet une immersion totale.

L’interface permet de monter autant de scènes que l’on souhaite, ajouter ou retirer des

cartes neuronales, d’effectuer des rendus temps réel sur des PC distants chez un ou plusieurs

collègues pour obtenir des contre-expertises. De nombreuses autres fonctionnalités sont

disponibles, comme le mapping bipolaire, par exemple. Arrêtons-nous sur l’une d’elles :

les algorithmes de lissage anatomique.

NeoBrain

MEG+IRM+NeoBrain = Carte

neuronale HSB L2

IMAGES – 28 août 2007 – page 31

déformatIon élastIque du cortex

Une grande partie de l’activité neuronale est enfouie au fond des sillons corticaux (60 %

environ). L’activité cérébrale y siégeant n’est donc pas ou peu visible au moyen d’une simple

vue 3D du cortex. Plusieurs algorithmes ont été développés pour transformer de manière

élastique le cortex afin d’étirer et d’aplatir les sillons corticaux.

Ces algorithmes de lissage ne sont pour l’instant ap-

plicables que pour les maillages où chaque hémisphère est

homéomorphe à une sphère. Ces algorithmes ne conservent

ni les angles, ni les aires, mais ont l’avantage de rendre

visible toute la surface du cortex, donc l’intégralité de la

carte neuronale.

Malheureusement, les algorithmes de segmentations

fabriquant le maillage à partir des voxels (pixels 3D) d’un

scanner IRM ont tendance à produire des surfaces homéo-

morphes à la famille des tores. Les micros tunnels ci-dessous

en sont la cause.

Le prochain challenge est donc de supprimer ces tunnels

de l’anatomie, afin de pouvoir utiliser les algorithmes de

lissage et ainsi disposer d’un outil permettant de visualiser

la totalité de la carte neuronale.

NeoBrain

NeoBrain : BrainDisplayer

lissage faible lissage plus fort lissage total, le cortex est une

sphère sans pli

tunnel issu de la segmentation imparfaite des voxels d’un IRM

FI spécial été 2007 – 28 août 2007 – page 32

pertInence des résultats pour l’économIe

En Suisse, plus de 70’000 patients souffrent de crises d’épilepsie, dont 20% résistent

au traitement pharmaceutique (Seeck, Villemure, Praxis 2002). Les accidents vasculaires

cérébraux (AVC) sont la 2ème cause de mortalité en Occident.

Vendredi 2 septembre 2005, Jacques Chirac était victime d’un AVC. Chaque année en

France, 130 000 personnes sont victimes d’un tel accident et près de 50 000 en meurent. Il

s’agit d’un véritable fléau. Communément appelés attaques cérébrales, les AVC représentent

la troisième cause de mortalité derrière les maladies cardiovasculaires et le cancer. Mais

c’est la première cause d’invalidité lourde et la deuxième cause de démence dans le monde

occidental. Le nombre d’AVC est en pleine croissance et représente dès aujourd’hui un

grave problème de santé publique.

«Les atteintes du corps, la honte des chutes, la confiscation du temps, la limitation des plaisirs,

le voile sur l’intelligence, les entraves à la liberté, le rejet des autres, les difficultés scolaires, la

peine des parents participent à la souffrance des épileptiques.» (Prof. René Souleyrol)

réseau de compétences

Ce projet s’inscrit dans l’axe de recherche environnement intelligent du centre de

compétences RCSO-TIC de la HES-SO, qui en a assuré le financement. Les travaux ont

été dirigés par la HE-ARC. Les résultats obtenus sont néanmoins le fruit d’une union

de savoir-faire très divers, couvrant un large domaine interdisciplinaire de compétences,

réunissant statisticiens, physiciens, mathématiciens, neurologues ou encore informati-

ciens. En particulier, citons le professeur Sylvain Sardy de l’université de Genève, qui

est à l’origine du modèle stochastique pour la résolution du problème inverse et Sylvain

Baillet, un chargé de recherche du CNRS qui a modélisé la propagation et déformation

des champs magnétiques à travers les tissus cellulaires cérébraux.

neuroweb.ch

L’amélioration de la qualité des cartes neuronales et la diminution du temps de calcul

sont en phase de développement au travers du projet Neuroweb.ch, qui constitue une

suite au module de calcul de carte neuronale.

Les brusques et intenses variations temporelles des activités neuronales présentes par

exemple lors de crise d’épilepsie, sont trop amorties, voire complètement gommées dans

les cartes neuronales de NeoBrain. Ce point faible peut être amélioré en dotant l’espace

topologique des données neuronales non pas de la métrique euclidienne, mais de la topo-

logie L1. Des simulations sur des signaux 1D et 2D ont montré que les pics épileptiques

sont conservés. Nous espérons que cette intéressante propriété soit préservée dans le cadre

du problème inverse et la reconstruction de la carte complète.

Une architecture peer to peer (P2P) basée sur la plate-forme xtremweb.ch (www.

xtremwebch.net/) est mise en place pour permettre une distribution efficace des calculs.

L’objectif est de tendre vers un calcul temps réel des cartes neuronales. Les cartes L1 sont

très gourmandes en calcul et requièrent une importante infrastructure pour être calculées

en un temps raisonnable.

perspectIve d’avenIr

L’imagerie fonctionnelle cérébrale a un bel avenir devant elle.

On pense immédiatement aux pathologies neurodégénératives. La recherche liée aux

maladies d’Alzheimer et de Parkinson se voit dotée ici d’un formidable outil d’analyse.

L’étude des conséquences d’un traumatisme crânien ou d’une ischémie cérébrale transi-

toire et l’assistance aux neurochirurgiens dans la stratégie opératoire vont faire un bond

en avant.

Chaque avancée importante dans la science fait apparaître inévitablement des problèmes

éthiques. Le côté non invasif de ces techniques d’imagerie permet leur exploitation dans

des domaines non médicaux. Comment ne pas penser à une modernisation des détecteurs

de mensonges dont le premier date de 1935 ? Dispose t’on aujourd’hui grâce à l’imagerie

fonctionnelle d’un outil fiable ? Aucune accréditation légale n’a été décernée à ce jour à

l’imagerie cérébrale dans un domaine d’exploitation judiciaire et ne le sera peut-être jamais.

NeoBrain

6

6

1

/

6

100%