Approche inverse en traitement du signal

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Approche inverse en traitement du signal

Éric Thiébaut

Centre de Recherche Astronomique de Lyon

Université Claude Bernard Lyon I

École Normale Supérieure de Lyon

2017

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

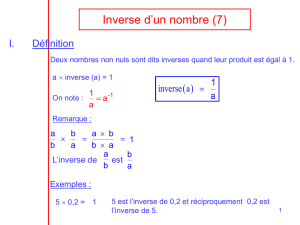

Exemple 1 : Formation d’image

formation d’image :

yi=Zh(ri−s)x(s)ds

| {z }

produit de convolution

+bi

objet : x(s)

réponse impulsionnelle (PSF) : h(r−s)

bruit : bi(au pixel n◦ià la position ri)

image observée : yi(au pixel n◦ià la position ri)

?+bruit →

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

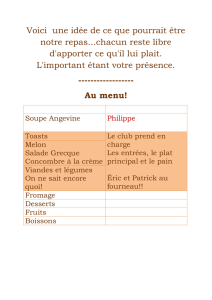

Exemple 2 : Tomographie

detecteur

source rayons X

modèle direct :

yi=ZLi

0

x(r∗+`ui) d`avec ui=ri−r∗

Li

et Li=kri−r∗k

où r∗et risont les position de la source et du ième pixel détecteur

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

Exemple 3 : Dynamique galactique

observables : distribution des vitesses Fφ(R, vφ)

modèle physique : dynamique disque galactique mince :

Fφ(R, vφ)=√2

0

Z

1

2v2

φ−ψ(R)

f(ε, R vφ)

qε+ψ(R)−1

2v2

φ

dε(transformée d’Abel)

inconnues : distribution des orbites f(ε, R vφ)

cinématique du gaz HI ⇒potentiel ψ(R)

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

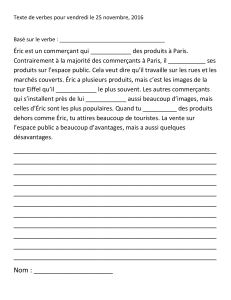

Exemple 4 : Reconstruction de phase

image observée phase dans la pupille

observables : image dans le plan focal ;

variables d’intérêt : phase dans le plan pupille

ϕ(s) = 2π

λ`(s)

avec `(s)et sla différence de marche et la position

dans la pupille ;

mesures (approximation champ lointain) :

yi=αZZ P(s) e i 2 π

λ[`(s)+hri,si/f]d2s

2

+bi

avec αune constante de normalisation, P(s)la

fonction pupille, rla position dans le plan focal et f

la distance focale.

Remarques :r/f est la direction angulaire et s/λ

est la fréquence spatiale associée.

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

Qu’est-ce qu’un problème inverse ?

Des observables disponibles et modélisables :

y=m(x) + b⇐=le modèle direct

les données y∈RM;

le modèle m:RN7→ RM;

les variables d’intérêt x∈RN;

les erreurs b∈RM.

Objectif : Retrouver les meilleurs paramètres xcompte tenu des

données yet du modèle m.

Étapes :

Contruire et analyser le modèle.

Établir un critère pour discriminer les meilleurs paramètres.

Élaborer une stratégie pour trouver la solution.

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

Le problème direct

Le problème direct consiste à construire le modèle des mesures

connaissant l’objet d’intérêt, l’instrument et le détecteur :

y=m(x) + b⇐=le modèle direct

Remarques :

le nombre de mesures est fini : M < ∞mais le nombre de paramètres peut

être arbitrairement grand : N≤ ∞ pratique Nest nécessairement fini ;

les mesures (et les paramètres) peuvent être hétérogènes ;

la partie déterministe du modèle, m(x), est connue mais peut être

arbitrairement compliquée (e.g. non-linéaire) ;

le terme non déterministe bprend en compte le bruit de mesure, les erreurs

de modélisation, etc ;

pour simplifier, nous supposerons que les variables aléatoires bsont

centrées au sens où :

E(b|x) = 0ou, au moins, E(bi|x)pVar(bi|x) ;

Exercice 1 : Montrer que

E(b|x}=0=⇒E(b) = 0.

Conséquences ?

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

Deux exemples de modèles linéaires (1/2)

Intégrale de Fredholm du 1er ordre (transformée d’Abel, réponse

instrumentale linéaire, projection, ...) :

yi=m(ri) + bi=Zh(ri,s)x(s) ds+bi

Discrétisation :

yi≈X

j

h(ri,sj)x(sj) ∆sj+bi=X

j

Hi,j xj+bi

avec xj≡x(sj)et Hi,j ≡h(ri,sj) ∆sj. En notation vectorielle :

y=H·x+b

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

Deux exemples de modèles linéaires (2/2)

Représentation de l’objet d’intérêt sur une base de fonctions :

x(s) = X

j

fj(s)xj.

Modèle direct :

yi=Zh(ri,s)x(s) ds+bi

=Zh(ri,s)X

j

fj(s)xjds+bi

=X

jZh(ri,s)fj(s) ds

| {z }

Hi,j

xj+bi

=X

j

Hi,j xj+bi

On retrouve que :

y=H·x+b

Éric Thiébaut Problèmes inverses

Introduction

Approches bayesiennes

Régularisations

Exemples

Annexes

Exemples

Problème direct

Erreurs

Solution

Modèle linéaire / non-linéaire

1modèle linéaire :

y=H·x+b

intégrale de Fredholm du 1er ordre (transformée d’Abel, convolution, ...) ;

base de fonctions ;

2modèle non-linéaire :

y=m(x)+b

tout ou partie du noyau h(r,s)à retrouver : déconvolution aveugle, synthèse

spectrale, ...

mesures de corrélation (à 2 ou 3 points)

restoration de phase : cristallographie, clôtures de phases (interférométrie),

...

⇒unicité ?

Éric Thiébaut Problèmes inverses

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

1

/

39

100%