La statistique descriptive

La statistique descriptive

•objectif : présenter les données

pour que l'on puisse en prendre

connaissance facilement

La statistique descriptive

•peut concerner :

–une variable à la fois : statistique à

une dimension

–deux variables à la fois : statistique à

deux dimensions

–plus de deux variables à la fois :

statistique multidimensionnelle

La statistique descriptive

•comporte :

–les tableaux : distributions de

fréquences

–les diagrammes : graphiques

–les paramètres statistiques : réduction

des données à quelques valeurs

numériques caractéristiques

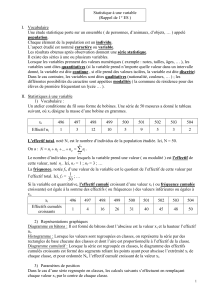

Distribution groupée :

exemple

Classe CinifiNiFi

[140-160[ 150 10 0,05 10 0,05

[160-165[ 162,5 20 0,10 30 0,15

[165-170[ 167,5 30 0,15 60 0,30

[170-175[ 172,5 45 0,225 105 0,525

[175-180[ 177,5 40 0,20 145 0,725

[180-185[ 182,5 35 0,175 180 0,90

[185-190[ 187,5 15 0,075 195 0,975

[190-200[ 195 5 0,025 200 1,0

N=200 S 1kfi =1

k = nombre de classes

Polygone des fréquences

Exemple

Nombre de colonies bactériennes/dm2

1234567891

011 12

0

5

10

15

20

25

30

35

40

45

Nombre de colonies

bactériennes/dm2 ni

1 5

2 7

315

425

535

645

732

828

916

10 12

11 3

12 1

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

1

/

49

100%