Asservissement visuel par imagerie médicale

Asservissement visuel par imagerie m´

edicale

Alexandre Krupa

INRIA Rennes - Bretagne Atlantique / IRISA

Campus universitaire de Beaulieu

35042 Rennes Cedex

t´

el : 02 99 84 25 85 - [email protected]

R´

esum´

e - Cet article pr´

esente les avanc´

ees r´

ecentes dans le domaine de l’asservissement visuel

par imagerie m´

edicale, r´

ealis´

ees notamment depuis les derni`

eres JNRR’07. Le domaine applicatif

concerne la robotique m´

edicale o`

u la tˆ

ache est r´

ealis´

ee selon un sch´

ema de commande en «boucle

ferm´

ee »utilisant directement l’information visuelle fournie par une modalit´

e d’imagerie m´

edicale telles

l’endoscopie, la fibroscopie, l’´

echographie, la tomodensitom´

etrie (scanner X), la r´

esonance magn´

etique

(IRM) ou autres.

Mots-cl´

es - Robotique m´

edicale, Asservissements visuels

I. INTRODUCTION

Apparue au milieu des ann´

ees 1980, la robotique m´

edicale et chirurgicale n’a cess´

e depuis de progresser.

En effet, grˆ

ace `

a l’introduction de nouvelles technologies de l’information et de la communication dans la

m´

edecine, une nouvelle discipline est apparue, laquelle s’int´

eresse aux Gestes M´

edicaux et Chirurgicaux

Assist´

es par Ordinateur (GMCAO). Ainsi, les techniques d’imagerie m´

edicale informatis´

ee permettent

aujourd’hui d’assister le praticien de fac¸on quantitative et fiable. L’utilisation de syst`

emes robotiques

permet d’augmenter la pr´

ecision du geste et d’effectuer des op´

erations chirurgicales peu invasives pour le

patient voir mˆ

eme des interventions ne pouvant pas ˆ

etre r´

ealis´

ees auparavant par une technique manuelle.

A leur d´

ebut, ces syst`

emes ont principalement ´

et´

e t´

el´

e-op´

er´

es par le praticien. Depuis une dizaine d’ann´

ees,

l’´

emergence des techniques d’imagerie a permis d’envisager de nouvelles applications robotiques d’assis-

tance aux gestes m´

edicaux. Il est `

a pr´

esent possible d’utiliser l’information provenant d’une ou de plusieurs

modalit´

es d’imagerie telles l’endoscopie, l’´

echographie, l’imagerie `

a rayonnement X, ou l’imagerie `

a

r´

esonance magn´

etique IRM pour guider des robots m´

edicaux. Actuellement, une grande majorit´

e des

interventions r´

ealis´

ees sous imagerie m´

edicale `

a l’aide de robots est bas´

ee sur des techniques de recalage

utilisant g´

en´

eralement des syst`

emes externes de mesure optique ou magn´

etique pour localiser la position

courante d’un instrument dans le r´

ef´

erentiel de l’imageur o`

u est planifi´

ee la position de la cible `

a atteindre

`

a partir d’une image pr´

e-op´

eratoire du patient. La pr´

ecision de la localisation et du positionnement de

l’instrument est dans ce cas directement fonction de la pr´

ecision fournie par le syst`

eme de localisation

externe utilis´

e. L’erreur de positionnement est ´

egalement plus grande lorsque la cible r´

eelle `

a atteindre est

mobile, ce qui est g´

en´

eralement le cas dˆ

u aux perturbations induites par les mouvements physiologiques

du patient. Dans ce contexte, l’asservissement visuel est une approche alternative que plusieurs ´

equipes

de recherche ont propos´

e dans des applications m´

edicales, afin de commander directement `

a partir

d’informations visuelles extraites de l’image m´

edicale, et en boucle ferm´

ee, soit le d´

eplacement de

l’imageur ou celui d’un instrument. Ces techniques ont un avantage majeur. Elles permettent d’obtenir des

pr´

ecisions de positionnement de l’ordre du pixel tout en essayant de compenser au mieux les perturbations

introduites par les mouvements physiologiques du patient au moyen de la boucle de retour visuel.

Dans cette article, nous reportons les avanc´

ees r´

ecentes de l’asservissement visuel dans le contexte

de la robotique m´

edicale. Nous nous int´

eresserons et d´

etaillerons dans la mesure du possible plus par-

ticuli`

erement les travaux r´

ealis´

es lors des 2 ou 3 derni`

eres ann´

ees dans la communaut´

e franc¸aise et

citerons quelques travaux pr´

ecurseurs ou novateurs r´

ealis´

es `

a l’´

etranger. Nous proposons ici de classer

ces travaux en fonction du dispositif d’imagerie m´

edicale utilis´

e dans l’application cibl´

ee. La section III

porte sur les travaux utilisant une ou plusieurs cam´

eras avec ou sans optique particuli`

ere. Les travaux sur

l’asservissement visuel `

a partir d’images ´

echographiques sont d´

ecrits dans la section IV. Et pour finir, la

section V pr´

esente les travaux o`

u les imageurs `

a rayonnement X ou `

a r´

esonance magn´

etique nucl´

eaire

sont consid´

er´

es. Mais tout d’abord un petit rappel sur les notions de base de l’asservissement visuel est

donn´

e dans la section qui suit.

II. ASSERVISSEMENT VISUEL

Dans cette section, nous pr´

esentons bri`

evement les bases utiles `

a la compr´

ehension de ce qu’est un

asservissement visuel. Afin d’obtenir une explication plus approfondie, nous invitons le lecteur `

a se reporter

aux articles tutoriels [1] et [2]. La commande par vision ou asservissement visuel consiste `

a contrˆ

oler

les mouvements d’un syst`

eme dynamique en int´

egrant les informations fournies par un capteur de vision

dans un syst`

eme de commande en boucle ferm´

ee. Initialement, les techniques d’asservissement visuel

ont ´

et´

e d´

evelopp´

ees pour contrˆ

oler, `

a partir de l’image fournie par une cam´

era monoculaire, des robots

de type manipulateurs. Une classification `

a pr´

esent bien connue permet de qualifier les diff´

erents types

d’asservissement visuel selon 3 crit`

eres qui sont : la configuration du capteur visuel dans le syst`

eme

robotique, le type d’architecture de commande utilis´

e et le type de grandeur `

a asservir. Ces crit`

eres sont

bri`

evement pr´

esent´

es ci-dessous.

A. Le positionnement du capteur visuel

–La configuration du capteur embarqu´

e : Comme l’expression l’indique, le capteur visuel est mont´

e

sur l’organe terminal du robot. Cette configuration est d´

enomm´

ee “eye in hand” dans la litt´

erature

anglo-saxonne. L’objectif de l’asservissement est g´

en´

eralement de d´

eplacer le capteur visuel pour

atteindre ou suivre par exemple un objet en mouvement.

–La configuration du capteur d´

eport´

e : Pour cette configuration “eye to hand”, le capteur visuel n’est

pas solidaire du robot asservi. L’objectif est de faire ´

evoluer le robot par rapport `

a son environnement

de travail, en percevant g´

en´

eralement `

a l’aide du capteur visuel l’image du robot et des objets avec

lesquels il interagit.

B. Les grandeurs asservies

–Asservissement visuel 3D :

Dans un asservissement visuel 3D, l’objectif est de contrˆ

oler le d´

eplacement du robot dans l’espace

cart´

esien. La grandeur `

a asservir correspond directement `

a l’attitude d’un rep`

ere li´

e rigidement `

a

l’effecteur du robot par rapport `

a un rep`

ere attach´

e`

a l’objet d’int´

erˆ

et. L’inconv´

enient majeur de ce type

d’asservissement est la n´

ecessit´

e d’une ´

etape de reconstruction 3D permettant de fournir une mesure

d’attitude. Cette derni`

ere peut par exemple ˆ

etre obtenue par triangulation en utilisant un syst`

eme de

vision st´

er´

eoscopique calibr´

e, ou par des techniques de reconstruction de pose dans le cas d’un capteur

monoculaire. Les techniques de reconstruction de pose utilisent des primitives extraites de l’image et

sont g´

en´

eralement bas´

ees sur la connaissance d’un mod`

ele de la sc`

ene observ´

ee. Malheureusement

quelle que soit la m´

ethode de reconstruction de pose utilis´

ee, l’estimation de l’attitude est tr`

es sensible

aux bruits de mesure et aux erreurs de calibrage du capteur visuel. Il en r´

esulte, apr`

es convergence de

l’asservissement lorsque le r´

egime permanent est atteint, un biais entre la position du robot et l’objet

d’int´

erˆ

et `

a atteindre. Cet inconv´

enient constitue le probl`

eme majeur de l’asservissement visuel 3D.

–Asservissement visuel 2D : Dans un asservissement visuel 2D, la grandeur `

a asservir est exprim´

ee

sous la forme de primitives visuelles dans l’image. Pour ce type d’asservissement, on parle ´

egalement

“d’asservissement r´

ef´

erenc´

e image”. Contrairement `

a un asservissement visuel 3D, le contrˆ

ole du

robot n’est pas effectu´

e dans l’espace cart´

esien, mais directement dans l’image. Les primitives

extraites de l’image sont g´

en´

eralement des formes g´

eom´

etriques ´

el´

ementaires qui proviennent de

l’objet d’int´

erˆ

et. Diff´

erents types de primitives peuvent ˆ

etre utilis´

es. Des coordonn´

ees de points dans

l’image sont les plus couramment utilis´

ees. Ces primitives peuvent ´

egalement ˆ

etre des droites, des

ellipses, des cylindres, des invariants projectifs, etc... Pour des sc`

enes complexes qui ne contiennent

aucune primitive g´

eom´

etrique simple, l’information du mouvement dans l’image ou directement

l’information photom´

etrique d’une r´

egion d’int´

erˆ

et de l’image peuvent ˆ

etre utilis´

ees comme primitives

visuelles.

C. L’architecture de commande du robot

–Commande s´

equentielle : Cette approche est recommand´

ee lorsque le dispositif d’imagerie ne peut

pas fournir des images `

a une cadence d’acquisition sup´

erieure au Hertz. L’asservissement fonctionne

selon un mode s´

equentiel ´

egalement appel´

e “look then move” dans la litt´

erature anglo-saxonne. La

s´

equence consiste `

a acqu´

erir une ou un ensemble d’images puis traiter et analyser ces images pour

g´

en´

erer une trajectoire en position de l’organe terminal du robot qui est envoy´

ee au contrˆ

oleur bas-

niveau du robot fourni par le constructeur. Ce dernier effectue ensuite l’asservissement en position

des coordonn´

ees articulaires. Cette s´

equence peut ˆ

etre r´

ep´

et´

ee ´

eventuellement jusqu’`

a atteindre un

crit`

ere d’arrˆ

et impos´

e. L’avantage de cette architecture r´

eside dans sa simplicit´

e, sa portabilit´

e et sa

robustesse, car le robot peut ˆ

etre consid´

er´

e comme un syst`

eme de positionnement autonome o`

u les

singularit´

es et les s´

ecurit´

es sont g´

er´

ees par le contrˆ

oleur de bas niveau du robot. L’inconv´

enient est

l’impossibilit´

e de r´

ealiser des asservissements visuels pour lesquels le but recherch´

e est la rapidit´

e.

–Commande cin´

ematique : La commande cin´

ematique est un asservissement en boucle ferm´

ee qui

consiste `

a envoyer p´

eriodiquement des consignes de vitesses articulaires au contrˆ

oleur bas niveau du

robot. La cadence du rafraˆ

ıchissement des consignes est impos´

ee par la fr´

equence d’acquisition des

images et la dur´

ee des traitements n´

ecessaires `

a l’extraction de l’information visuelle et du calcul de

la loi de commande. Ce type de commande est g´

en´

eralement utilis´

e pour des fr´

equences d’acquisition

des images allant de 1 `

a 50 Hz. La fonction de transfert du robot est consid´

er´

ee comme ´

etant un

int´

egrateur pur car les effets dynamiques ne sont pas mod´

elis´

es. Cette commande a l’avantage d’ˆ

etre

facilement mise en œuvre si le contrˆ

oleur bas niveau du robot permet de g´

en´

erer et d’appliquer une

trajectoire de positions articulaires `

a partir de consignes de vitesses articulaires. N´

eanmoins, elle

n’est pas ad´

equate pour des applications n´

ecessitant une r´

eactivit´

e´

elev´

ee du robot du fait de la non

mod´

elisation des effets dynamiques.

–Commande dynamique : La commande dynamique tient compte d’une mod´

elisation plus r´

ealiste

du comportement du robot. Une identification des param`

etres dynamiques (masses, inerties, frotte-

ments,...) du robot est n´

ecessaire afin de mettre en œuvre une commande en vitesse ou en couple

qui lin´

earise le comportement du syst`

eme. Dans ce cas, le syst`

eme de vision commande directement

les variateurs des actionneurs du robot en se substituant au contrˆ

oleur bas niveau du robot. Cette

architecture permet de tirer pleinement partie des possibilit´

es dynamiques offertes par le robot pour

r´

ealiser des asservissements visuels rapides. Elle n´

ecessite cependant une cadence ´

elev´

ee du syst`

eme

de vision (plus de 50 images/s), afin de garantir la stabilit´

e et la convergence de la commande.

III. CAM ´

ERAS AVEC OU SANS OPTIQUE PARTICULI `

ERE

Historiquement, les premiers travaux d’asservissement visuel en robotique m´

edicale ont ´

et´

e r´

ealis´

es dans

le contexte de la chirurgie laparoscopique o`

u le dispositif d’imagerie utilis´

e est un endoscope constitu´

e

d’une cam´

era coupl´

ee `

a une optique particuli`

ere de forme cylindre. Cette optique de longueur importante

est introduite dans l’abdomen du patient par l’interm´

ediaire d’un trocart pr´

ealablement positionn´

e au

travers d’un point d’incision. Un r´

eseau de fibres optiques plac´

e en p´

eriph´

erie de l’optique permet de

transporter `

a l’int´

erieur de l’abdomen du patient l’´

eclairage d’une source de lumi`

ere froide qui est situ´

ee

`

a l’ext´

erieur. Ce type d’imageur m´

edicale a l’avantage de b´

en´

eficier des bonnes propri´

et´

es des cam´

eras

classiques, qui sont entre autres une cadence ´

elev´

ee de l’acquisition d’images (25 images/s ou plus) et la

pr´

esence d’un faible temps de retard d’acquisition (de l’ordre de 20 ms). Il est donc appropri´

e pour ˆ

etre

int´

egr´

e dans des applications robotiques avec asservissement visuel utilisant une architecture de commande

cin´

ematique ou dynamique.

Les premiers travaux [3], [4], [5] ont port´

e sur le positionnement automatique d’un robot porteur

d’endoscope (configuration “eye in hand”) afin de suivre et maintenir dans le champs visuel de la cam´

era

un ou plusieurs instruments de chirurgie laparoscopique lors d’une intervention chirurgicale et ´

evitant

ainsi la pr´

esence d’un chirurgien pour manipuler l’endoscope.

Par la suite, des travaux ont port´

e sur le positionnement automatique d’un instrument de chirurgie

laparoscopique actionn´

e par un robot m´

edical command´

e par asservissement visuel (configuration “eye to

hand”). Les applications mises en œuvre ont ´

et´

e : la r´

ecup´

eration automatique par asservissement visuel

2D d’un instrument dans le champs visuel de la cam´

era [6], une tˆ

ache de suture automatique [7] effectu´

ee

par asservissement visuel 3D apr`

es indication dans l’image du point d’entr´

ee et de sortie d’une aiguille

circulaire et la compensation des mouvements physiologiques du patient au moyen d’une commande

dynamique utilisant un correcteur pr´

edictif bas´

e sur un mod`

ele du mouvement de l’organe [8].

L’utilisation de la vision pour le guidage de robot `

a l’int´

erieur du corps humain est limit´

ee par les

difficult´

es ´

emanant de l’interpr´

etation des images. Pour cette raison, les travaux mentionn´

es pr´

ec´

edemment

ont pour la plupart consid´

er´

e des informations visuelles fournies par des marqueurs artificiels ajout´

es dans

la sc`

ene. Ces marqueurs ont ´

et´

e fix´

es sur l’extr´

emit´

e des instruments [3], [4], [5], [7] et/ou ´

egalement sur

la surface de l’organe d’int´

erˆ

et par projection de spot laser [6] ou fixation de marqueurs lumineux [8].

Une m´

ethode alternative `

a l’utilisation de marqueur a ´

et´

e propos´

ee dans [9] dans le but de d´

etecter des

instruments de chirurgie laparoscopique. Cette m´

ethode est bas´

ee sur l’hypoth`

ese que chaque instrument

est introduit dans l’abdomen par un point “fixe”. Elle n´

ecessite une phase d’initialisation au d´

ebut de

l’intervention qui consiste `

a visualiser par la cam´

era endoscopique les points de l’abdomen o`

u sont

ins´

er´

es les diff´

erents instruments afin de calculer leurs coordonn´

ees 3D dans un rep`

ere li´

e au robot selon

le principe de st´

er´

eovision. Ces coordonn´

ees 3D constituent des contraintes sur les positions attendues des

outils dans les images permettant ainsi `

a un algorithme de segmentation bas´

e sur la m´

ethode de Hough

[10] d’extraire efficacement les contours lat´

eraux des instruments. La d´

etection de l’extr´

emit´

e de l’outil

est bas´

ee sur une m´

ethode d’Otsu [11] qui consiste `

a r´

ealiser un seuillage sur l’histogramme des niveaux

de gris des pixels appartenant `

a l’axe de sym´

etrie de l’instrument. Cette m´

ethode de d´

etection a ´

et´

e valid´

ee

sur cadavre lors d’une chol´

ecystectomie (ablation de la v´

esicule biliaire) et un asservissement visuel 2D

“eye in hand” a ´

et´

e mis en œuvre pour contrˆ

oler 2 degr´

es de libert´

e d’un robot porte-endoscope afin de

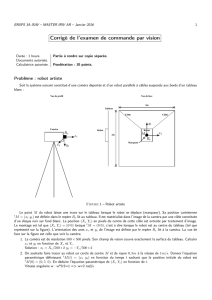

suivre et maintenir un instrument au centre de l’image (Figure 1).

En vue de r´

ealiser le positionnement relatif des instruments par rapport aux surfaces des organes,

d´

eformables et en mouvement, une approche diff´

erente consiste `

a effectuer une mesure 3D imm´

ediate

de la surface des organes. Celle-ci a ´

et´

e abord´

ee dans [12] par la mise en œuvre d’un dispositif de

lumi`

ere structur´

ee qui projette un motif sur les organes, ind´

ependamment de l’information renferm´

ee dans

la texture. Cette ´

etude concerne plus particuli`

erement la conception automatique de motifs de grandes

dimensions, codant sp´

ecifiquement la lumi`

ere et o`

u la distance de Hamming permet de quantifier la

robustesse vis-`

a-vis des occultations et des discontinuit´

es de courbures de la surface observ´

ee. Des

dispositifs de projection miniaturis´

es ont ´

et´

e d´

evelopp´

es en partenariat avec un industriel. Grˆ

ace aux

choix des indices visuels repr´

esentant les ´

el´

ements du motif et `

a un sch´

ema de d´

ecodage propos´

e, la

Fig. 1. Quelques exemples de d´

etection des instruments chirurgicaux avec la m´

ethode du “point fixe” et le robot porte-endoscope LER

command´

e par asservissement visuel 2D pour centrer l’instrument dans l’image

rapidit´

e d’ex´

ecution obtenue permet une reconstruction 3D (Figure 2) en temps r´

eel (50 ms) pour des

applications de r´

ealit´

e augment´

ee et de commande de robot [13].

Fig. 2. Projection d’un motif monochrome sur les organes de l’abdomen d’un porc - D´

ecodage : les indices visuels d´

etect´

es et d´

ecod´

es

(mis en correspondance avec le mod`

ele) sont colori´

es en rouge - Reconstruction 3D

R´

ecemment une nouvelle technique de chirurgie mini-invasive a ´

et´

e mise en place par les m´

edecins.

Cette technique consiste `

a introduire des instruments chirurgicaux dans la cavit´

e abdominale par voie

transluminale, c’est `

a dire par des orifices naturels tels que la bouche, l’anus, le vagin ou l’ur`

etre. Cette

nouvelle technique pr´

esente de nombreux avantages par rapport aux techniques traditionnelles telles que la

chirurgie ouverte (laparotomie) ou chirurgie laparoscopique. Le plus significatif est l’absence d’incisions

dans la paroi abdominale et de cicatrices visibles apr`

es l’intervention. Dans ce contexte, des travaux

de recherche [14], [15] ont ´

et´

e men´

es afin de contrˆ

oler automatiquement l’orientation de la tˆ

ete d’un

endoscope flexible robotis´

e. Deux degr´

es de libert´

e en orientation sont command´

es par un asservissement

visuel bas´

e image, de sorte que la cam´

era endoscopique maintienne une cible anatomique fixe dans l’image

(voir Figure 3). Afin de rejeter efficacement les perturbations li´

ees au mouvement respiratoire, l’asser-

vissement visuel est coupl´

e`

a un m´

ecanisme de commande r´

ep´

etitive [16]. Cette commande, r´

ecemment

utilis´

ee dans le domaine m´

edical, a une limitation importante : elle ne permet pas de rejeter efficacement

des perturbations non p´

eriodiques. Cette limitation est particuli`

erement gˆ

enante en endoscopie flexible

o`

u la cam´

era est embarqu´

ee sur le syst`

eme portant les instruments. Ainsi, dans le syst`

eme consid´

er´

e,

l’enfoncement de l’endoscope est contrˆ

ol´

e manuellement et ces mouvements manuels agissent comme

des perturbations inconnues sur l’asservissement visuel. La solution propos´

ee par les auteurs consiste `

a

d´

ecomposer ces perturbations selon 2 axes : les changements de profondeur selon l’axe de la cam´

era et les

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

1

/

14

100%