corrigé.

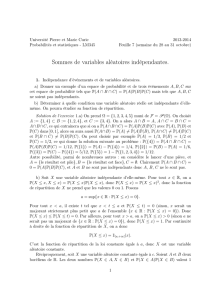

(Ω,F,P)A∈F

AP(A∩A) =

P(A)P(A)P(A) = P(A)2P(A) 0 1

X x ∈R

P(X≤x, X ≤x) = P(X≤x)P(X≤x)P(X≤x) = P(X≤x)2

X0 1

a= sup{x∈R:P(X≤x) = 0}.

x<a t x<t≤aP(X≤t)=0 x

a{x∈R:P(X≤x) = 0}

P(X≤x)≤P(X≤t)=0 x>a P(X≤x)>0a

{x∈R:P(X≤x)=0}P(X≤x)=1

X

P(X≤x) = [a,+∞[(x).

a X

X c A B

R P(X∈A, X ∈B)P(X∈A)P(X∈B) 1

c∈A∩B0X

A, B, C

P(A∩B∩C) = P(A)P(B)P(C)

A, B, C

A, B, C

P(A∩B) = P(A)P(B)P(A∩C) = P(A)P(C)

P(B∩C) = P(B)P(C)A, B, C

Ω = {1,2,3,4,5} F =P(Ω)

A:= {1,4} ⊂ B:= {1,2,4}C:= {3,4}A∩B=A A ∩C=B∩C=

A∩B∩CP(A∩B∩C) = P(A)P(B)P(C)P(A)P(B)

P(C) ]0,1[ P(A∩B) = P(A)6=P(A)P(B)P(A∩C)6=P(A)P(C)

P(B∩C)6=P(B)P(C)P(A)=1/3P(B)=1/2

P(C)=1/2P({4}) = P(A∩B∩C) =

P(A)P(B)P(C) = 1/12 P({1}) = P(A)−P({4}) = 1/4P({2}) = P(B)−P(A) = 1/6

P({3}) = P(C)−P({4})=5/12 P({5})=1−P({1,2,3,4}) = 1/12

Ω = {1,2,3,4} F =P(Ω) P

A={1,2}B={1,3}C={1,4}P(A) = P(B) = P(C)=1/2

P(A∩B) = P(A∩C) = P(B∩C)=1/4A B

A C B C P(A∩B∩C) = 1/46=

P(A)P(B)P(C) = 1/8A B C

n≥1 Ω {0,1}nP(Ω)

Pω= (ω1, . . . , ωn)∈Ωk∈ {1, . . . , n}

Xk(ω) = ωk

X1, . . . , Xn

p∈[0,1] Q(Ω,P(Ω))

(Ω,P(Ω),Q)X1, . . . , Xn

p

k∈ {1, . . . , n} {Xk= 1}={0,1}k−1× {1}×{0,1}n−k

2n−1

2n= 1/2X1, . . . , Xn

1/2B1, . . . , Bn⊂R

P(∀k∈ {1, . . . , n}, Xk∈Bk) = P(X1∈B1). . . P(Xn∈Bn).

Bk{0,1}

Bk0 1 i

k Bk0 1 P(Xk∈Bk) = 1/2

n−i k {0,1} ⊂ BkP(Xk∈Bk) = 1

2−i

2n−i

2n= 2−i

p∈[0,1] Q(Ω,P(Ω))

(Ω,P(Ω),Q)X1, . . . , Xn

p

E={x1, x2, x3}F={y1, y2, y3}R

P= (Pij )i,j=1,2,3(X, Y )

E×F i, j ∈ {1,2,3}P(X=xi, Y =

yj) = Pij X Y

P=

1

401

12

0 0 0

1

201

6

, P =

000

3

17

12

17

2

17

000

, P =

1

4

3

32

1

32

2

15

1

20

1

60

17

60

17

160

17

480

P=

1

4

3

32

1

32

2

15

1

20

1

20

1

4

1

10

3

80

.

X

Y

P(X=xi) = P(X=xi, Y =y1)+P(X=xi, Y =y2)+P(X=xi, Y =y3) = Pi1+Pi2+Pi3,

P(Y=yj) = P(X=x1, Y =yj)+P(X=x2, Y =yj)+P(X=x3, Y =yj) = P1j+P2j+P3j.

i, j Pij =P(X=xi)P(Y=yj)

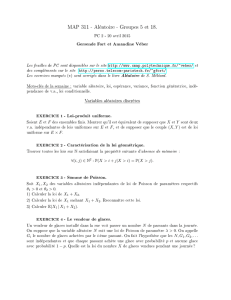

n p m p p ∈[0,1] m, n

n p n

p

X1, . . . , Xn+m

p Y =X1+. . . +XnZ=Xn+1 +. . . +Xn+m

Y Z B(n, p)B(m, p)

Y+Z=X1+. . . +Xn+mB(n+m, p)

Y Z B(n, p)B(m, p)

Y Z GY(s) = (1 −p+sp)nGZ(s) = (1 −p+sp)m

GY+Z(s) = E[sY+Z] = E[sY]E[sZ] = (1 −p+sp)n+m.

n+m p

N1, . . . , Np

λ1, . . . , λpN1+. . . +Np

N1+. . . +Np

λ1+. . .+λpp= 2

p∈[0,1]

X Y

X x1x2

P(X=x1)>0P(X=x2)>0y1y2

P(Y=y1)>0P(Y=y2)>0x1< x2y1< y2

x1+y1< x1+y2< x2+y2z1=x1+y1z2=x1+y2z3=x2+y2

P(X+Y=z1)≥P(X=x1, Y =y1)X Y

P(X+Y=z1)≥P(X=x1)P(Y=y1)>0P(X+Y=z2)>0

P(X+Y=z3)>0X+Y

X+Y

(Ω,F,P) (Xn)n≥1

(Ω,F,P)

p∈]0,1[

n≥1ω∈Ω

Sn(ω) = k∈ {1, . . . , n}Xk(ω) = 1.

Sn(Sn)n≥1

ω∈Ω

T1(ω) = min{n≥1 : Xn(ω)=1},

min ∅= +∞P(T1= +∞)T1

ω∈Ω

T2(ω) = min{n > T1(ω) : Xn(ω) = 1}.

T2T2−T1T1T2

T1T2−T1

Sn=X1+· · · +Xnn

p n p

(Sn)n≥1

Sn+1 −Sn=Xn+1 P(Sn+1 −Sn= 2) = 0 n≥1P(Sn+1 = 2)P(Sn= 0) >0

k≥1Xnω∈Ω

P(T1=k) = P(X1=· · · =Xk−1= 0, Xk= 1) = P(X1= 0) . . . P(Xk−1= 0)P(Xk= 1) = p(1−p)k−1.

P(T1<+∞) = Pk≥1P(T1=k) = 1 P(T1=

+∞)=0 T1p1−p

j≥1k≥1P(T1=j, T2=k) = 0 k≤j

k > j

P(T1=j, T2=k) = P(X1=· · · =Xj−1= 0, Xj= 1, Xj+1 =· · · =Xk−1= 0, Xk= 1) = P(X1= 0) . . . P(Xj−1= 0)P(Xj= 1)P(Xj+1 = 0) . . . P(Xk−1= 0)P(Xk= 1) = p2(1−p)k−2.

k j = 1, . . . , k −1

P({T2=k) = (k−1)p2(1 −p)k−2.

kP(T2= +∞) = 0 T1

{1,2,3, . . .}T2{2,3,4, . . .}

P(T1< T2) = 1 T1T2

P(T1= 2, T2= 2) = 0 <P(T1= 2)P(T2= 2)

k=i+j

P(T1=j, T2−T1=i) = P(T1=j, T2=k) = p2(1 −p)k−2=p(1 −p)j−1p(1 −p)i−1.

jP(T2−T1=i) = p(1 −p)i−1

P(T1=j, T2−T1=i) = P(T1=j) = P(T2−T1=i).

T2T1T1

X Y N(µ1, σ2

1)

N(µ2, σ2

2)a b c aX +bY +c

gR→R

E[g(X+Y)] = 1

2πσ1σ2Z+∞

−∞ Z+∞

−∞

e−(x−µ1)2

2σ2

1

−(y−µ2)2

2σ2

2g(x+y)dydx.

u=x+y y

E[g(X+Y)] = 1

2πσ1σ2Z+∞

−∞ Z+∞

−∞

e−(x−µ1)2

2σ2

1

−(u−x−µ2)2

2σ2

2g(u)dudx.

(x−µ1)2

2σ2

1

+(u−x−µ2)2

2σ2

2

=σ2

1+σ2

2

σ2

1σ2

2(x−λu)2+µ2

1

σ2

1

+(u−µ2)2

σ2

2

−σ2

1+σ2

2

σ2

1σ2

2

λ2

u,

6

6

7

7

1

/

7

100%