Jeu de slides... - Vincent Lemaire

(Nom du fichier) - D1 - 06-07-2006

The present document contains information that remains the property of France Telecom. The recipient’s

acceptance of this document implies his or her acknowledgement of the confidential nature of its contents

and his or her obligation not to reproduce, transmit to a third party, disclose or use for commercial purposes

any of its contents whatsoever without France Telecom’s prior written agreement.

Frank Meyer

France Telecom R&D /TECH/SUSI/TSI

L'Apprentissage Semi-

Supervisé

Quelques éléments

Distribution of this document is subject to France Telecom’s authorization

Tech/Susi/Tsi - 2006

France Télécom R&D

Sommaire

0. Quelques rappels & terminologie usuelle

1. Classification semi-supervisée

1.1 Problématique

1.2 Panorama général des méthodes

2. Clustering semi-supervisé

3. Le cas de l'apprentissage de métrique

Distribution of this document is subject to France Telecom’s authorization

Tech/Susi/Tsi - 2006

France Télécom R&D

0. Quelques rappels & terminologie 1/4

➨ Terminologie traditionnelle en data mining / apprentissage automatique

Exemples = instances = points = records = objets = lignes des données

Variables = attributs = coordonnées = features = propriétés = colonnes de

données

Classe = label = variable cible = variable à prédire (domaine supervisé)

Classification = classification supervisée = apprentissage supervisé

Exemples de méthodes : arbre de décision C5 ou CART, réseaux

de neurones type perceptron, régression linéaire, régression logistique,

K-plus-proches-voisins, Support Vector Machine...

Clustering = classification non supervisée (= malheureusement parfois

classification en français)

exemples de méthodes : K-Means, Classification Hiérarchique

Ascendante, carte de Kohonen

Distribution of this document is subject to France Telecom’s authorization

Tech/Susi/Tsi - 2006

France Télécom R&D

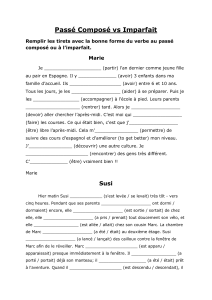

0. Quelques rappels & terminologie 2/4

oApprentissage supervisé (en anglais,

classification) :

o On a des points de n classes différentes

(par exemple n=2), l'ensemble

d'apprentissage

o On voudra par la suite classer des

nouveaux points : C'est l'ensemble des

points pour lesquels on voudra appliquer

un modèle

(...)(...)(...)

?38

rouge47

vert52

ClasseYX

X

Y

Espace descriptif (ici à 2 dimensions)

Nouvel

élément :

Ensemble

d'apprentissage

*

Distribution of this document is subject to France Telecom’s authorization

Tech/Susi/Tsi - 2006

France Télécom R&D

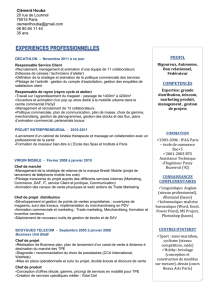

0. Quelques rappels & terminologie 3/4

oClassification, suite :

oOn cherche donc un modèle qui va

définir des frontières dans l'espace de

description (c'est l'apprentissage)

oOn en déduit, pour de nouveaux points

pas encore classés, leur classe

d'appartenance

(...)(...)(...)

Prédit : rouge38

rouge47

vert52

ClasseYX

X

Y

Espace descriptif (ici à 2 dimensions)

Nouvel

élément :

Ensemble

d'apprentissage

*

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

1

/

34

100%