Exploration de données scientifiques multi-échelles

Exploration de données

scientifiques multi-échelles

École thématique RISC-E, Nicolas Brodu, 11 octobre 2016

Données Scientifiques

Le Big Data en sciences ?

– Résolution et multiplicité des capteurs (e.g. images multispectrales)

– Volume d’images de grandes tailles (e.g. photos de manips)

– Nature des données multi-physique (e.g. ultrasons, voltage, photos, etc)

– Dimensionalité élevée (e.g. paramètres d’une simulation)

– Taille des enregistrements (e.g. séries mesurées sur plusieurs années)

Mesures

Modélisation

Prédictions

Validation

Conséquence : Diicile pour un humain « non aidé » de

percevoir des relations ou motifs récurrents dans les données,

de les modéliser, de tester des hypothèses, etc.

Pas seulement pour l’analyse de données : informatisation à tous les

niveaux de la boucle méthodologique

Données Scientifiques

Comparatif avec le “Big Data” commercial

Google / Facebook / Amazon / etc… Votre manip / terrain / mesures physio /…

Finalité = gagner des sous

– Données mesurées = toutes vos traces

– Modèles comportementaux

robustes ⇒ profilage utilisateur

– Demandes des investisseurs/clients

à prendre en compte

– Services rendus aractifs ⇒ publicité

Finalité = comprendre ce qui se passe

– Données mesurée selon hypothèses/modèle

ou question scientifique précise

– Connaissances disciplinaires à prendre en

compte:physique, biologie, etc.

– Faire mieux que l’état de l’art, dose d'inconnu

– Publications

Moyens disponibles

– Jeu d’entraînement, validation

«illimités»

– Puissance de calcul «illimitée»

Moyens disponibles

– Mesures de référence

= votre temps / argent du labo

– Votre laptop, un PC ou le cluster du labo

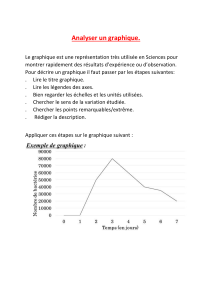

Objectifs très variés mais, de façon générale, il est utile de :

- Trouver les points intéressants (statistiques ≠ bruit de fond, anomalies ou pas)

- Aux échelles intéressantes (pas forcément celle d'acquisition)

- Et modéliser leur dynamique (diérents formalismes, pas tous appropriés)

Extraction de caractéristiques

Caractéristiques ?

– Espace de valeurs à fort potentiel, mesurées ou calculées sur les données brutes

– D’intérêt disciplinaire, souvent en lien avec une hypothèse / un modèle

– E.g.: Indice de végétation calculé à partir de bandes spectrales, tenseur des

contraintes calculé à partir de forces microscopiques, etc.

= Espace de recherche des points intéressants

En quoi des points sont-ils « intéressants » ?

– Critères statistiques :ce qui dière du reste (erreurs/outliers ? phénomène rare ?)

– Critères dynamiques : perturbation, changement d’aracteur

– Critères informatifs :points porteurs de l’information

Analyse guidée (proche de l’apprentissage supervisé)

– Partant d’exemples connus, on cherche des points similaires

Fouille exploratoire (proche de l’apprentissage non supervisé)

– Extraction automatique de groupes (clustering), de modèle de la dynamique, etc.

De diérentes natures

Données hétérogènes

Sources multiples, de natures diérentes

Échelles d’acquisition multiples

Sources multiples, de natures diérentes

Pas l’objet principal de cee présentation

En général, pour ces données, éviter les modèles linéaires (dont SVM simples):

a*x1 + b*x2 + c*x3 … ≷ seuil ? N'est généralement pas homogène !

Préférer par exemple les modèles ensemblistes, où chaque feature est traitée

séparément, puis les décisions sont combinées de façon probabiliste sur

l'ensemble des classificateurs (e.g. forêts d'arbres de décisions aléatoires).

Ou encore les méthodes "à noyau", où des fonctions projeent chaque feature

dans un espace de Hilbert, et où on peut travailler dans l'espace produit.

f(x1, ·) ⊗ f(x2, ·) ⊗ f(x3, ·) …

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

1

/

34

100%