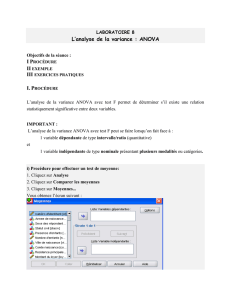

Rappels et pratique de la comparaison de moyennes

Biostatistiques et statistiques appliquées

aux sciences expérimentales

Rappels et pratique de la comparaison de moyennes

(test t, ANOVA 1, comparaisons multiples)

Jérémie Mattout#, Pascal Bessonneau

#jeremiemattout@yahoo.fr

http://www.aliquote.org/cours/2006_cogmaster_A4/

Cogmaster A4 2006-2007*

p. 1/22

• Comparaison de deux moyennes (test-t)

H0: µ = 0 ou µ1 = µ2

• Comparaison de k moyennes (k > 2 i.e. ANOVA 1)

H0: µ1 = … = µi = … = µk

• Comparaisons multiples (exercices)

p. 2/22

Programme de la séance

• Population de moyenne µ et de variance σ2

• Echantillon tiré de cette population (tirages indépendants)

{X1 … Xi … XN}

• Statistiques (caractéristiques d’échantillon)

- moyenne (estimateur sans biais de µ)

- variance (estimateur sans biais de σ2)

p. 3/22

Définitions générales

( )

!

=

"

"

=

N

i

iXX

N

s

1

2

2

1

1

!

=

=

N

i

i

X

N

X

1

1

• Distribution de

- moyenne

µ

X

- variance σX2

• Théorème central limite

«µ

µ µ

»

p. 4/22

Statistiques de la distribution d’échantillonnage de la moyenne

X

• Cas de variance σ2 connue et/ou N grand (>30) :

z ~ Normal(0,1)

p. 5/22

Comparaison de deux moyennes (1)

H0: µX = µ

N

X

XX

z

!

µ

!

µ

"

=

"

=

1,96

-1,96

H1: µX ≠ µ

z

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

1

/

22

100%