Lire l`article complet

Correspondances en Onco-hématologie - Vol. IV - n° 1 - janvier-février-mars 2009

8

méthodologie

A

u cours du suivi d’un patient en onco-

hématologie, il est habituel de collecter

des données longitudinales, comme des

mesures de numération sanguine, de maladie

résiduelle ou encore des indices de qualité de vie.

Ces données font généralement partie des critères

de jugement secondaires ou sont collectées de

manière rétrospective. Chaque série temporelle

est donc rarement complète. C’est pourquoi elle

doit faire l’objet d’un traitement statistique par-

ticulier afi n de limiter les biais.

DIFFÉRENTS TYPES DE DONNÉES

MANQUANTES

Les données manquantes en biologie sont répar-

ties en deux types : elles peuvent être manquantes

de manière intermittente (mesures manquantes à

l’évaluation t, mais disponibles à l’évaluation t+1)

ou de manière défi nitive (mesures manquantes

au-delà de l’évaluation t).

Trois principaux mécanismes de données man-

quantes sont à distinguer : complètement aléa-

toire (MCAR [missing completely at random]),

aléatoire (MAR [missing at random]) et non

aléatoire (MNAR [missing not at random]). Si

les données à l’instant t sont manquantes pour

des raisons indépendantes de l’état de santé du

patient (par exemple, lorsque l’équipe médicale

oublie de faire une mesure ou lorsque le patient

déménage), leur mécanisme est MCAR ou MAR.

Le cas particulier de la censure, où le patient n’a

pas encore atteint le temps d’évaluation, est éga-

lement considéré comme aléatoire. À l’inverse,

dans les études où le patient peut souffrir d’une

toxicité du traitement ou subir une rechute de la

maladie, un mécanisme de données manquantes

non aléatoire doit être envisagé. Dans ce cas,

si la mesure à l’instant t est liée à la toxicité ou à

l’effi cacité du traitement, la mesure des patients

ne faisant pas leur analyse peut être moins bonne

que pour ceux la faisant effectivement (par exem-

ple, mesure du taux d’hémoglobine).

MÉTHODES POUR LA PRISE EN COMPTE

DES DONNÉES MANQUANTES

Analyse univariée ✔

Une première stratégie consiste à n’utiliser que

les données complètes disponibles (complete-

case analysis). C’est la méthode la plus simple,

mais aussi la moins effi cace : non seulement elle

diminue l’effectif et la puissance statistique, mais

surtout elle sélectionne la population. Pour être

non biaisée, cette approche ne peut être appli-

quée que lorsque les données manquantes sont

complètement aléatoires (MCAR). Une variante

consiste à utiliser toutes les données disponibles

(available-case analysis) : par exemple, estimer

une différence entre chaque point de mesure

séparément (e.g. t2 versus t0 puis t3 versus t0,

etc.). L’effectif des données observées varie alors

selon les points de mesure.

Une deuxième stratégie consiste à compléter les

données manquantes, afi n de pouvoir pratiquer

l’analyse sur un jeu complet. De nombreuses

méthodes d’imputation ont été développées,

qui sont très utilisées en raison de leur relative

simplicité mais restent très conservatrices (i.e.

peu de chance de montrer des différences signi-

fi catives). La plus simple consiste à remplacer la

donnée manquante par la dernière observation

disponible (LVCF [last value carried forward]). Cela

revient à considérer que la mesure est constante

au cours du temps. C’est peu fréquent, mais,

dans certains cas, cette approche est plus utile

Théorie et pratique

des essais thérapeutiques

en onco-hématologie

Épisode 8

Theory and practice of clinical trials - Episode 8

N. Mounier*

* Département d’onco-hématologie,

hôpital de l’Archet, Nice.

9

Correspondances en Onco-hématologie - Vol. IV - n° 1 - janvier-février-mars 2009

Théorie et pratique des essais thérapeutiques en onco-hématologie

que la précédente. En particulier, si la mesure

des patients ayant une donnée manquante à un

instant t est mauvaise, et que leur mesure pré-

cédente (t–1) était déjà basse, reporter la valeur

de la dernière observation constitue un moindre

biais comparativement à une analyse limitée aux

cas complets. Une autre méthode d’imputation

simple consiste à remplacer la donnée manquante

par la moyenne des données observées chez tous

les patients, ou dans un sous-groupe de patients

ayant des caractéristiques proches, ou bien par

la moyenne des données antérieures du patient

(horizontal imputation). Outre la sous-estimation

de la variance, la principale limite de cette appro-

che est qu’elle nécessite des données MCAR pour

être non biaisée.

Des méthodes plus complexes ont été dévelop-

pées pour limiter le problème de la sous-esti-

mation de la variance. Une approche consiste à

imputer les réponses manquantes à partir d’un

modèle de régression tenant compte des don-

nées cliniques (indice d’activité, maladie, toxicité

des traitements) et des données précédentes

(regression imputation). Elle sous-estime encore

la variabilité des observations, mais réduit les

biais. Ce modèle peut également être utilisé de

manière non paramétrique, en classant les don-

nées à chaque point de mesure et en attribuant le

classement le plus bas aux données manquantes

dues à une progression de la maladie ou à une

toxicité. Une alternative consiste à assigner le

plus mauvais classement à toutes les données

manquantes, l’hypothèse sous-jacente étant que

la mesure est moins bonne pour les données man-

quantes non aléatoires que pour les données

observées.

Les différences entre les groupes sont ensuite

testées au point t choisi avec un test non paramé-

trique comme, par exemple, le test de Wilcoxon.

En pratique, si les données manquantes sont peu

nombreuses et équilibrées entre les groupes à

comparer, les résultats varient peu selon les

méthodes. En revanche, en cas de déséquilibre

ou de forte proportion de données manquantes,

le choix du test est diffi cile.

Analyse de sensibilité ✔

Les méthodes d’imputation peuvent être optimi-

sées par des approches plus lourdes en termes

de calcul. Au lieu d’une seule valeur, plusieurs

valeurs (m) sont calculées afi n de refl éter les m

distributions possibles (multiple imputation), soit

en utilisant les méthodes décrites plus haut, soit

en sélectionnant au hasard une valeur parmi les

données des patients avec données complètes

(hot deck imputation). Ensuite, l’analyse est faite

sur chacun des m jeux de données obtenus, et

combinée afin d’obtenir une variance moins

biaisée que celle estimée par imputation simple.

Le principal avantage de cette approche est de per-

mettre la réalisation d’analyses de sensibilité en

modifi ant le choix des distributions. On voit alors

si la conclusion reste la même quelles que soient

les conditions initiales (par exemple, lorsque le

pourcentage de données manquantes varie).

Analyse multivariée ✔

Le problème des données manquantes a éga-

lement un impact sur les méthodes d’analyse

multivariée. Les techniques du type analyse de

variance (ANOVA) pour mesures répétées néces-

sitent des données complètes, ce qui limite leur

utilisation aux situations où la morbidité est

faible, la compliance haute et le mécanisme de

données manquantes aléatoire. Si les données

ne sont pas complètes, l’analyse est restreinte

à des sous-groupes potentiellement non repré-

sentatifs.

Données manquantes de type MCAR et MAR ✔

Les méthodes fondées sur la maximisation de la

vraisemblance sont plus sophistiquées que celles

décrites jusqu’ici, mais permettent d’obtenir des

estimations fi ables non plus seulement dans les

cas de données MCAR, mais aussi avec données

manquantes de type MAR.

Pour les données quantitatives normales, la

nécessité d’utiliser un jeu de données complètes

peut être allégée en utilisant des modèles à effets

mixtes.

Le modèle général à effets mixtes s’écrit :

Yi = Xiβ + Zibi + εi

où Yi est le vecteur réponse de dimension ni pour

le sujet i, ni est le nombre de mesures pour le

sujet i, n est le nombre total de sujets 1 ≤ i ≤ n, Xi

et Zi sont des matrices structurées de dimension

(ni x p) et (ni x q), β est le vecteur de dimension p

des paramètres des effets fi xes, b

i

≈ n(0, D) est

le vecteur de dimension q des paramètres des

effets aléatoires, et εi ≈ n(0, Σi) est le vecteur

de dimension n

i

des composantes résiduelles ;

b1… bn et ε1… εn sont par hypothèse indépen-

dants. L’effet aléatoire permet de tenir compte

de l’hétéro généité entre individus.

Si l’hypothèse de données MAR est valide, les

méthodes fondées sur la maximisation de la

vraisemblance permettent de ne pas exclure les

patients présentant des données incomplètes.

Correspondances en Onco-hématologie - Vol. IV - n° 1 - janvier-février-mars 2009

10

10

méthodologie

De plus, ces méthodes permettent de prendre en

compte les mesures irrégulières et les covariables

dépendant du temps et de tester les changements

au cours du temps.

Données manquantes de type MNAR ✔

Cependant, dans la plupart des cas, l’absence de

mesure est due à la maladie du patient. On entre

alors dans le cadre des données manquantes de

mécanisme non aléatoire (MNAR). Peu de travaux

ont été conduits sur les données catégorielles

de type MNAR. En revanche, le cas des données

quantitatives normales de type MNAR commence

à être mieux connu.

Deux méthodes, encore expérimentales, cher-

chent à modéliser de manière conjointe la mesure

et le mécanisme de données manquantes. Il s’agit

des modèles de type sélection et des modèles de

type mélange de profi ls.

L’idée des modèles de type sélection est de

modéliser directement la manière dont le méca-

nisme de données manquantes intervient. Une

distribution sous-jacente est modélisée pour les

données longi tudinales (par exemple, au moyen

d’un modèle mixte), et le mécanisme de données

manquantes est modélisé en fonction de ces

mesures longitudinales (par exemple, au moyen

d’un modèle de Cox, vu aux chapitres 5 et 6).

La méthode générale des modèles de type

mélange de profi ls consiste à stratifi er les patients

en fonction de leur temps de survenue de don-

nées manquantes (par exemple, strate 1 : données

manquantes à partir de t2 ; strate 2 : données

manquantes à partir de t3, etc.). Puis les para-

mètres du modèle (par exemple, modèle mixte)

sont estimés pour chaque strate. L’avantage des

modèles de type mélange de profi ls est de ne pas

nécessiter une spécifi cation complète du méca-

nisme de données manquantes, notamment pas

de modèle à préciser. En revanche, les diffi cultés

d’estimation sont importantes en raison des nom-

breuses possibilités de séquences de données

manquantes conduisant à un faible effectif pour

chaque strate.

■

POUR EN SAVOIR PLUS…

• Diggle PJ, Heagerty P, Liang KY et al. Analysis of longi-

tudinal data. Oxford University Press, 2002.

10

20

30

40

50

60

70

80

90

100

0

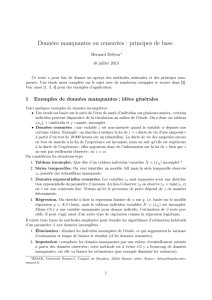

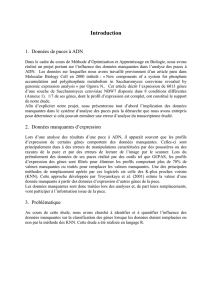

Cas complet Imputation Imputation/régression

1-3 4+ 1-3 4+ 1-3 4+

Indice de qualité de vie

Figure. Effet des méthodes d’imputation sur l’estimation de la qualité de vie (QDV).

Soit une chimiothérapie dont la dose est fonction du score pronostique (1-3 ou 4-5) :

selon les méthodes, les variations de QDV peuvent être de sens opposé.

1

/

3

100%