CANAUX DISCRETS

CANAUX DISCRETS

Marc URO

TABLE DES MATIERES

CAPACITE D'UN CANAL DISCRET......................................................................................3

CODAGE DE CANAL.............................................................................................................16

3

CANAUX DISCRETS

CAPACITÉ D'UN CANAL DISCRET

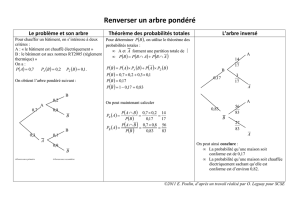

Un canal est un dispositif permettant d'acheminer un message entre deux points distants.

Comme nous allons le voir sur l'exemple ci-après, les modèles de canaux, en théorie de

l'information, résultent de la mise en cascade du canal de transmission et du récepteur.

EXEMPLE D'UNE CHAÎNE DE TRANSMISION NUMÉRIQUE EN BANDE DE BASE

On considère une source binaire S. Les symboles

ak

issus de S sont "mis en forme" par un

filtre de réponse impulsionnelle

gt

(

)

de telle sorte que le signal à la sortie de ce filtre a pour

expression

akgt

−

kT

(

)

k

=

−

∞

+

∞

∑

où

1

T

représente le débit binaire de la source. À l'extrémité du

canal de transmission sont disposés:

- un filtre adapté de réponse impulsionnelle

g

−

t

(

)

(sa présence contribue à minimiser la

probabilité d'erreur),

- un échantillonneur,

- un comparateur à seuil.

Source Formant Canal de transmission

Filtre réception

Echantillonneur

Comparateur à seuil

g(t) g(-t)

ak

Plusieurs modèles peuvent être élaborés à partir de la chaîne de transmission;

- un premier modèle est obtenu en englobant le formant, le canal de transmission, le filtre

réception et l'échantillonneur

4 _____________________________________________________________ canaux discrets

Formant Canal de transmission

Filtre réception

Echantillonneur

g(t) g(-t)

0

1

On obtient un canal à deux entrées ("0" et "1"), la variable de sortie est continue.

- si on connecte un comparateur à seuil après l'échantillonneur de telle sorte la valeur

échantillonnée est interprétée en "0" (resp. en "1") si elle est négative (resp. positive) (cette

structure de récepteur est justifiée lorsque les éléments binaires sont codés en des valeurs

symétriques -V et +V et lorsque le canal de transmission est assimilé à un canal à bruit additif

gaussien), on obtient un canal à deux entrées (les éléments binaires) et deux sorties (les

éléments binaires estimés);

Formant Canal de transmission

Filtre réception

Echantillonneur

Comparateur à seuil

à un niveau

g(-t)

0 estimé

1 estimé

1g(t)

0

Le canal est caractérisé par les correspondances probabilistes (probabilités de transition) entre

les symboles d'entrée et les symboles de sortie. Ainsi pour le récepteur décrit ci-dessus, les

zones de décision des symboles estimés peuvent être représentées comme suit;

densité de probabilité de

l’échantillon si “1” émis

densité de probabilité de

l’échantillon si “0” émis

P{“1” décidé / “0” émis}

P{“0” décidé / “1” émis}

0

V

-V

on décide “1” émis

on décide “0” émis

canaux discrets _____________________________________________________________5

Le modèle de canal associé peut être représenté de la façon suivante;

0

1

0

1

Entrée Sortie

Dans le cadre du codage de source, nous avons étudié comment utiliser les redondances d'une

source pour diminuer son débit binaire tout en conservant sa quantité d'information. Pour faire

parvenir à un destinataire la nouvelle source X ainsi obtenue, on va utiliser un canal de

transmission. La variable Y reçue à la sortie du récepteur comportera des différences avec la

variable X initialement émise dues aux perturbations (le bruit) agissant sur le support de

transmission.

XY

CANAL DE TRANSMISSION

ET RECEPTEUR

PERTURBATIONS

Du point de vue de la théorie de l'information, les imperfections du canal peuvent être

traduites en termes d'information qu'apporte la variable de sortie Y sur la variable d'entrée X.

IX;Y

(

)

=

HX

(

)

−

HX/Y

(

)

.

Le terme

HX/Y

(

)

s'appelle l'ambiguïté, il correspond à l'incertitude qui reste sur X lorsque

Y est connue: Il sera d'autant plus grand que le canal sera perturbé.

On modélisera un canal par deux alphabets (un alphabet d'entrée correspondant aux valeurs

possibles pour X et un alphabet de sortie constitué des valeurs prises par Y) et une matrice de

transition Q dont le terme

Qij

situé à la iième ligne et jième colonne représente la probabilité

pour que la iième valeur de l'alphabet d'entrée soit transformée en la jième valeur de l'alphabet

de sortie.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

1

/

26

100%