Algorithme de descente de gradient, ADAptive LInear NEuron

Modèles supervisés pour Data-Science

Massih-Reza Amini

Université Grenoble Alpes

Laboratoire d’Informatique de Grenoble

Massih-[email protected]

2/17

Programme

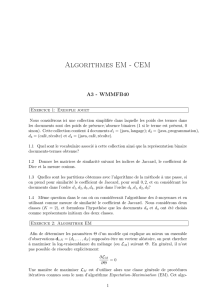

1. Principe de la minimisation du risque empirique

2. Optimisation convexe non-contrainte

3. Algorithme de descente de Gradient

4. ADAptive LInear NEuron (ADALINE)

Massih-[email protected] Machine learning

3/17

Rappel

qComme la distribution de probabilité Dest inconnue, la

forme analytique du vrai risque R(f)ne peut pas être

estimée, et donc la fonction de prédiction ne peut pas être

calculée directement.

qPrincipe de la Minimisation du Risque Empirique: Trouver

h:X → R, à partir d’une classe de fonctions Hen

minimisant l’estimateur non-biaisé de Rsur une base

d’apprentissage S= (xi,yi)m

i=1:

ˆ

Rm(f,S) = 1

m

m

i=1

[[yi×h(xi)≤0]]

Définir alors la fonction de classification fcomme

∀x,f(x) = sgn(h(x))

Massih-[email protected] Machine learning

4/17

Or la minimisation de l’erreur de classification

empirique est impossible ...

qLa fonction empirique

Rm:w7→ 1

m

m

i=1

[[yi×hw(xi)≤0]]

n’est ni continue, ni dérivable.

qLa minimisation d’une borne supérieure convexe ˆ

L(w)de

Rmprenant la valeur 1 en 0 conduira à la même

minimiseur que Rm[Bartlett et al.]

Massih-[email protected] Machine learning

5/17

Bornes supérieures convexes classiques de

l’erreur de classification

Massih-[email protected] Machine learning

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

1

/

17

100%