Classification par les centres mobiles

Universit´e de Nice SV1, ann´ee 2009-2010

D´epartement de Math´ematiques Math´ematiques pour la Biologie (semestre 2)

Cours 8 : Classification automatique de donn´ees

par la m´ethode des centres mobiles.

Comme l’algorithme de classification hi´erarchique ascendante, l’algorithme des centres mobiles (K-

mean clustering en anglais) est un outils de “fouille de donn´ees”(data mining). La fouille de donn´ees joue

un rˆole important dans presque tous les domaines scientifiques, du marketing qui l’a fait naˆıtre1,`ala

g´en´etique en passant par l’informatique (reconnaissance de forme) ou la linguistique.

1 L’algorithme des centres mobiles :

L’objectif de la m´ethode est de partitionner en diff´erentes classes des individus pour lesquels on

dispose de mesures. On repr´esente les individus comme des points de l’espace ayant pour coordonn´ees

ces mesures. On cherche `a regrouper autant que possible les individus les plus semblables (du point de

vue des mesures que l’on poss`ede) tout en s´eparant les classes le mieux possible les unes des autres.

Ici encore (comme dans le cas de la classification hi´erarchique ascendante) on choisit de proc´eder de

fa¸con automatique, c’est-`a-dire qu’on ne cherche pas `a utiliser l’expertise que l’on aurait des individus

pour trouver des regroupements avec ce que l’on connait les concernant mais plutot un moyen de faire

apparaˆıtre, uniquement `a partir des mesures, des ressemblances et des diff´erences `a priori peu visibles.

Cette id´ee, travailler automatiquement, `a l’aide de l’ordinateur et en aveugle, est appel´ee apprentissage

non supervis´e.

La m´ethode des centres mobiles s’applique lorsque l’on sait `a l’avance combien de classes on veut

obtenir. Appelons kce nombre de classes. L’algorithme est le suivant :

Etape 0 : Pour initialiser l’algorithme, on tire au hasard kindividus appartenant `a la population, C0

1,C0

2,

..., C0

k: ce sont les kcentres initiaux. On notera que l’indice num´erote les diff´erents centres et l’exposant

indique qu’il s’agit des kcentres initiaux. On choisit aussi une distance entre individus.

On va ensuite r´ep´eter un grand nombre de fois les deux ´etapes suivantes :

Etape 1 : Constitution de classes : On r´epartit l’ensemble des individus en kclasses Γ0

1,Γ

0

2, ..., Γ0

ken

regroupant autour de chaque centre C0

ipour i=1,...,n l’ensemble des individus qui sont plus proches

du centre C0

ique des autres centres C0

jpour j6=i(au sens de la distance choisie).

Etape 2 : Calcul des nouveaux centres : On d´etermine les centres de gravit´e G1,G2, .... , Gkdes

kclasses ainsi obtenues et on d´esigne ces points comme les nouveaux centres C1

1=G1,C1

2=G2, .... ,

C1

k=Gk

R´ep´etition des ´etapes 1 et 2 : on r´ep`ete ces deux ´etapes jusqu’`a la stabilisation de l’algorithme,c’est-

`a-dire jusqu’`a ce que le d´ecoupage en classes obtenu ne soit (presque) plus modifi´e par une it´eration

supl´ementaire.

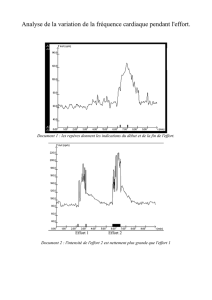

Le sch´ema ci-dessous illustre la m´ethode (`a noter qu’en pratique, bien sur, on ne fait pas ces calculs

“`a la main” mais `a l’aide d’un logiciel d’analyse de donn´ees). Dans cette figure la distance choisie est

la distance euclidienne : en effet, pour r´epartir les points du nuage en deux groupes, ceux qui sont les

plus proches d’un point C0

1et ceux qui sont les plus proches d’un autre point C0

2au sens de la distance

euclidienne, il suffit de tracer la m´ediatrice du segment [C0

1,C0

2].

Mais est-on sˆur que cet algorithme conduit bien `a une partition meilleure que celle dont on est parti,

c’est-`a-dire celle qui ´etait issue du tirage al´eatoire initial de kcentres ? Pour r´epondre `a cette question,

il faudrait pr´eciser ce que l’on entend par meilleure. Nous allons pour cela introduire la notion d’inertie

d’un nuage de points.

1Selon http ://fr.wikipedia.oeg/Exploration de donn´ees, cet algorithme qui remonte `a 1956 serait devenu c´el`ebre en

mettant en ´evidence pour les magasins Wal-Mart un lien entre l’achat de couches pour b´eb´es et l’achat de bi`eres le samedi

apr`es midi. L’analyse des r´esultats d’une classification automatique permit de comprendre qu’il s’agissait de messieurs

envoy´es par leurs compagnes chercher des couches, jug´ees trop volumineuses, et qui s’offraient alors des packs de bi`ere. On

r´eorganisa les rayons des magasins en disposant couches et packs de bi`ere `a proximit´e et les ventes de bi`ere s’envol`erent.

1

2 Inertie inter et intra classes :

On appelle inertie totale d’un nuage Γ = {Mi,i=1,...,n}la somme pond´er´ee des carr´es des distances

de ses points au centre de gravit´e du nuage. Donc, si Gd´esigne le centre de gravit´e de Γ, l’inertie totale

de Γ est, si tous les points du nuage sont de mˆeme poids ´egal `a 1

n, est donn´ee par la formule :

I(Γ) = 1

nd2(M1,G)2+d2(M2,G)2+...+d2(Mn,G)2.(1)

Notons que le centre de gravit´e est pr´ecis´ement le point Gpour lequel cette somme pond´er´ee est minimale.

L’inertie “mesure” la dispersion du nuage, elle sera grande pour un nuage tr`es disperc´e et petite lorsque

le nuage est constitu´e de points bien regroup´es. Si le nuage Γ est compos´e de kclasses Γ1,Γ

2, .... , Γk

(disjointes deux `a deux), celles-ci seront d’autant plus homog`enes que les inerties de chaque classe, I(Γ1),

I(Γ2), .... , I(Γk), calcul´ees par rapport `a leurs centres de gravit´e G1,G2, .... , Gkrespectifs, seront

faibles. La somme de ces inerties est appel´ee inertie intraclasse :

Iintra =I(Γ1)+I(Γ2)+...+I(Γk)

Les inerties des classes I(Γ1), I(Γ2), ... sont simplement calcul´ees avec la formule (1) ci-dessus o`u l’on

remplace le centre de gravit´e Gpar celui de la classe G1,G2, ... et le poids 1

npar celui de la classe.

L’inertie totale d’un nuage n’est g´en´eralement pas ´egale `a la somme des inerties des classes qui le

composent, c’est-`a-dire `a l’inertie intraclasse (sauf dans le cas o`u les centres de gravit´e de toutes les

classes sont confondus) car il faut prendre en compte ´egalement la dispersion des classes par rapport au

centre de gravit´e du nuage. Il s’agit de l’inertie interclasse d´efinie par

Iinter =p1d2(G1,G)2+p2d2(G2,G)2+...+pkd2(Gk,G)2,o`upjd´esigne le poids total de la classe Γj.

On montre le r´esultat suivant appel´e d´ecomposition de Huygens :

Th´eor`eme 1 L’inertie totale d’un nuage de points compos´e de diff´erentes classes disjointes deux `a deux

est la somme de son inertie intraclasse et de son inertie interclasse, c’est-`a-dire :

I(Γ) = I(Γ1∪Γ2∪...∪Γk)=Iintra +Iinter .

On a vu que lorsqu’un nuage est compos´e de plusieures classes, si chacune est tr`es bien regroup´ee

autour de son centre de gravit´e, son inertie intra, qui est la somme des inertie de chaque classe sera petite.

La partition d’un nuage en kclasses, pour un nombre de classes fix´e, sera d’autant meilleure que son

inertie intra sera petite, ou, puisque son inertie totale reste la mˆeme quelque soit la partition, que son

inertie extra est grande. Or on peut montrer justement que l’inertie intra classe ne peut que d´ecroˆıtre

lorsque l’on passe d’un regroupement en classes {Γi

1,Γ2,i...,Γi

k}au suivant {Γi+1

1,Γ2,i+1 ...,Γi+1

k}par

une it´eration de l’algorithme des centres mobiles. Si cette d´ecroissance ´etait toujours stricte, le nombre

de partitions diff´erentes d’un ensemble fini de points est lui-mˆeme fini (mˆeme s’il est gigantesque), on

serait sur d’atteindre ainsi le minimum. En pratique, la d´ecroissance n’est pas toujours stricte et on n’est

donc sˆurs de rien. Mais cet algorithme est populaire car il est facile `a utiliser et il suffit souvent de peu

d’it´erations pour avoir deja une partition de qualit´e.

2

3M´ethodes mixtes

L’algorithme des centres mobiles a cependant deux d´efauts principaux :

1) tout d’abord il exige de l’utilisateur de choisir `a l’avance le nombre de classes de la partition, ce qui

est parfois difficile.

2) Ensuite on s’aper¸coit que la partition que l’on obtient peut varier sensiblement en fonction du choix

des centres initiaux. Cela vient du fait que, si l’inertie intra d´ecroit effectivement `a chaque it´eration, ce

n’est pas forc´ement vers le minimum recherch´e mais parfois vers un minimum local qui n’est pas du tout

optimal. En pratique, comme le d´eroulement de l’algorithme est g´en´eralement rapide, on n’hesite pas `a

l’ex´ecuter plusieurs fois avec des choix diff´erents des centres initiaux et on compare les partitions obtenues

pour ne retenir que celle dont l’inertie intra est minimale, ou, si aucune n’est clairement minimale, la

partition qui revient le plus souvent (groupements stables).

Au dela de la classification hierarchique ascendante et de la m´ethode des centres mobiles, il existes

beaucoup d’autres m´ethodes (par exemple des m´ethodes stochastiques comme les reseaux de neurones)

mais l’utilisateur privil´egie souvent, lorsque le nombre d’individus est tr`es grands et qu’il est alors difficile

de choisir d’avance le nombre de classes, une classification mixte comme indiqu´ees sur la figure suivante :

Si l’on a des milliers, voir des dizaines de milliers d’individus `a classifier, on commence par les r´epartir

en un (trop) grand nombre de classes (par exemple k= 100) par la m´ethode des centres mobiles. Puis,

on ne retient que les centres des classes (avec leur poids qui sera proportionnel au nombre d’individus

dans chaque classe) {(Cn

1,p

1),(Cn

2,p

2),...,(Cn

100,p

100)}et on effectue une classification hi´erarchique

ascendante sur ces centres.Une partition est alors obtenue par coupure du dendrogramme que l’on choisit

aussi judicieusement que possible (par exemple au plus grand saut) pour avoir le bon nombre de classes.

On peut alors calculer leurs centres de gravit´e et finalement alouer chaque individu au centre le plus

proche, ce qui consolide la partition.

3

1

/

3

100%