1 Introduction

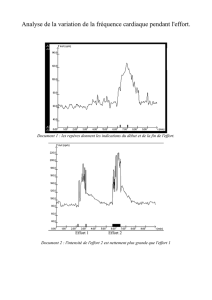

ANALYSE DE DONNEES

V 4.9

Marc MENOU

Mars 2008

M. MENOU / ANALYSE DE DONNEES

2

TABLE DES MATIERES

1 INTRODUCTION 3

2 ELEMENTS FONDAMENTAUX 8

21 RAPPELS SUR LA THEORIE DES ENSEMBLES 8

22 RAPPELS DE GEOMETRIE 8

23 RAPPELS SUR LES MATRICES 9

24 RAPPELS DE STATISTIQUE DESCRIPTIVE 10

26 RAPPELS SUR LA THEORIE DE L'INFORMATION 11

27 LES TABLEAUX 11

TABLEAUX INDIVIDUS X VARIABLES QUANTITATIVES 12

TABLEAUX LOGIQUES OU BOOLEENS OU BINAIRES 12

TABLEAUX PRESENCE ABSENCE 12

TABLEAUX DE DONNEES ORDINALES OU DE PREFERENCES 12

TABLEAUX DES RANGS 12

TABLEAUX HETEROGENES OU MIXTES 12

28 LES RELATIONS ENTRE VARIABLES 13

3 METHODES 13

4 LES ANALYSES FACTORIELLES 15

41 L'ANALYSE EN COMPOSANTES PRINCIPALES (ACP) 15

42 L'ANALYSE FACTORIELLE DES CORRESPONDANCES (AFC) 26

43 L'ANALYSE DES CORRESPONDANCES MULTIPLES ACM 30

44 L’ANALYSE FACTORIELLE DES SIMILARITES (OU DE DISSIMILARITES) ET DES PREFERENCES 32

45 L'ANALYSE DISCRIMINANTE (AFD) 36

46 L’ANALYSE DES MESURES CONJOINTES 42

47 L'ANALYSE CANONIQUE 43

5 LES METHODES DE CLASSIFICATION, DE TYPOLOGIE OU DE TAXINOMIE 46

51 L'ANALYSE NON HIERARCHIQUE 47

52 L'ANALYSE HIERARCHIQUE 53

LOGICIELS 59

BIBLIOGRAPHIE 60

3

1 Introduction

L'analyse des données est une technique relativement ancienne

1930 (PEARSON, SPEARMAN, HOTELLING). Elle a connu cependant des

développements récents 1960-1970 du fait de l'expansion de

l'informatique.

L'informatique est importante car cette technique nécessite le

brassage de beaucoup de données par beaucoup de calculs pour en

tirer des représentations graphiques. Elle apporte rapidité et

fiabilité.

L'analyse des données est une technique d'analyse statistique

d'ensemble de données. Elle cherche à décrire des tableaux et à

en exhiber des relations pertinentes. Elle se distingue de

l’analyse exploratoire des données.

La statistique est une technique qui permet la compréhension de

la réalité. C’est un moyen d’investigation de la complexité.

STATISTIQUE

REEL COMPLEXE

REPRESENTATION

SIMPLIFIEE

M. MENOU / ANALYSE DE DONNEES

4

En effet, comme le dit P. VALERY "tout ce qui est simple est

faux, tout ce qui ne l'est pas est inutilisable". Il s'agit en

quelque sorte d'"élaguer" la réalité en ne retenant que ce qui

est primordial. Il faut en particulier réduire les dimensions

de la réalité, c’est-à-dire ne pas considérer certaines

variables tout en cherchant à conserver le maximum de sens.

Cela revient à effectuer une projection.

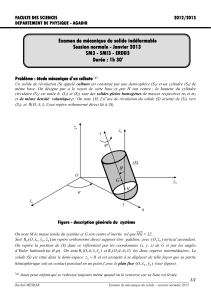

Ces trois schémas représentent une chaise dessinée dans le

plan. Ils permettent une plus ou moins bonne identification

selon l’axe de projection.

La réalité peut être considérée comme un nuage de points à n

dimensions que notre cerveau a du mal à se représenter.

La statistique est donc une méthode de traitement de

l'information. L'information est ce qui permet d'entreprendre

une action. Mais pour agir, il faut savoir. La connaissance, en

rapport avec les ensembles réels, se rapporte à ce qui pour une

population donnée, distingue ses individus. Tel l'Horace, qui a

5

cherché à distancer les Curiaces, le pouvoir ne peut s'exercer

efficacement qu'à l'encontre des individus isolés. Diviser pour

mieux régner est aussi une devise bien connue. Il faut donc

chercher la ou les variables qui opposent le plus, qui séparent

le plus, les individus. La variance est donc, comme

caractéristique de dispersion, le critère de choix le plus

désigné des critères de connaissance. L'analyse des données

repose donc essentiellement sur les notions de variances, de

covariance, de distances, de groupe, de lien et de hiérarchie.

La théorie des ensembles fournit le cadre conceptuel de base

dans lequel il convient de poser la problématique.

L'analyse des données souhaite cependant se démarquer des

techniques statistiques et économétriques classiques.

Elle cherche à regarder les données pour elles-mêmes en

oubliant les théories qui ont permis de les rassembler. Car

l'élaboration d'un modèle et l'observation projettent les idées

déjà contenues dans le cerveau. Il n'est perçu que ce que l'on

désire essentiellement percevoir. Il faut comme l’a écrit

KRISHNAMURTI : « se libérer du connu ». Pour ce faire, il faut

considérer beaucoup de données afin d’éviter l’arbitraire de

leur choix.

Bien entendu, il existe une différence entre les objectifs et

les réalisations car les moyens sont limités.

R. THOM relève que prédire n’est pas expliquer. Si les modèles

statistiques permettent la prévision, il s’agit souvent de

mettre en évidence des liaisons quantitatives observables. Cela

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

1

/

65

100%