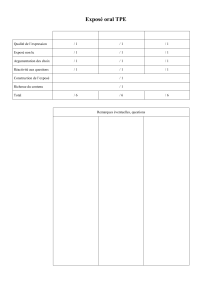

Remarques concernant l`organisation pratique de l`épreuve

1

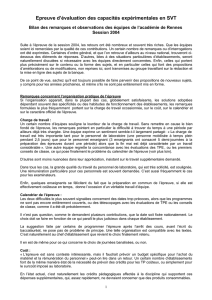

Epreuve d’évaluation des capacités expérimentales en SVT

Bilan des remarques et observations des équipes de l’académie de Rennes

Session 2004

Suite à l’épreuve de la session 2004, les retours ont été nombreux et souvent très riches. Que les équipes

soient ici remerciées par la qualité de ces contributions. Un certain nombre de remarques ou d’interrogations

ont été exprimées. Certaines d’ordre général, et que l’on retrouve d’ailleurs au niveau national, trouveront ci-

dessous des éléments de réponses. D’autres, liées à des situations particulières d’établissements, seront

naturellement discutées si nécessaire avec les équipes directement concernées. Enfin, celles qui portent

plus précisément sur le contenu ou la forme des sujets, et en particulier celles qui font des propositions

d’améliorations ou de modifications, non reprises ici, sont transmises au groupe travaillant sur la rédaction et

la mise en ligne des sujets de la banque.

De ce point de vue, sachez qu’il est toujours possible de faire parvenir des propositions de nouveaux sujets,

y compris pour les années prochaines, et même s’ils ne sont pas entièrement mis en forme.

Remarques concernant l’organisation pratique de l’épreuve

Si l’organisation apparaît, dans la plupart des cas, globalement satisfaisante, les solutions adoptées

dépendant souvent des spécificités ou des habitudes de fonctionnement des établissements, les remarques

formulées le plus fréquemment portent sur la charge de travail occasionnée, sur le coût, sur le calendrier et

sur le caractère officiel de l’épreuve.

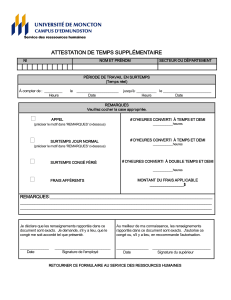

Charge de travail :

Un certain nombre d’équipes souligne la lourdeur de la charge de travail. Sans remettre en cause le bien

fondé de l’épreuve, les remarques pointent en particulier la difficulté à trouver du temps à une période par

ailleurs déjà très chargée. Une équipe exprime un sentiment semble-t-il largement partagé : « La charge de

travail est très importante tant pour le personnel de laboratoire (une personne mobilisée à temps plein

pendant 2,5 jours) que pour le personnel enseignant (3 enseignants ont consacré 5 demi-journées à la

préparation des épreuves durant une période) alors que la fin mai est déjà caractérisée par un travail

considérable ». Une autre équipe regrette la concomitance avec les évaluations des TPE , ou les premiers

conseils de classe, ce qui pose finalement le problème du calendrier de l’épreuve (voir plus loin).

D’autres sont moins nuancées dans leur appréciation, insistant sur le travail supplémentaire demandé.

Dans tous les cas, la grande qualité du travail du personnel de laboratoire, qui est très sollicité, est

soulignée. Une rémunération particulière pour ces personnels est souvent demandée. C’est aussi

fréquemment le cas pour les examinateurs.

Enfin, quelques enseignants se félicitent du fait que la préparation en commun de l’épreuve, si elle est

effectivement coûteuse en temps, donne l’occasion d’un véritable travail d’équipe.

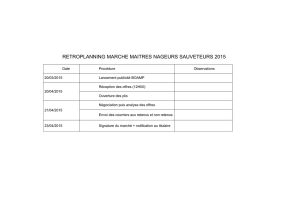

Calendrier de l’épreuve :

Les deux difficultés le plus souvent signalées concernent des dates trop précoces, alors que les

programmes ne sont pas encore entièrement couverts, ou des télescopages avec les évaluations de TPE ou

les conseils de classe, comme il a été dit précédemment.

Il n’est pas question, comme le demandent plusieurs contributions, que la date soit fixée nationalement. Le

choix doit se faire en fonction de ce qui paraît le plus judicieux dans chaque établissement.

La suggestion faite par certains de programmer l’épreuve après l’arrêt des cours, avant l’écrit du

baccalauréat, ne pose pas de problème de principe. Une telle organisation est compatible avec les textes.

C’est naturellement au chef d’établissement que revient le choix finalement retenu.

Il en est de même pour ce qui concerne le choix de journées banalisées, ou non.

Coût :

« L’épreuve est sans conteste intéressante, mais il faudrait prévoir un budget spécifique pour l’achat du

matériel et la rémunération du personnel » peut-on lire dans un retour. Un certain nombre d’établissements

font de la même manière état de la nécessité de prévoir des crédits pour les TP coûteux, ou simplement

pour le surcoût imposé au laboratoire.

2

En l’état actuel, c’est naturellement les crédits pédagogiques affectés à la discipline qui supportent ces

dépenses supplémentaires, qui, assez rapidement, ne devraient concerner que des produits consommables.

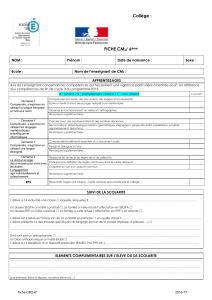

Caractère officiel / réglementation :

Quelques questions portent sur le caractère officiel de l’organisation de l’épreuve, dans la mesure où la note

compte à présent pour le baccalauréat.

En particulier, que se passera-t-il si un élève n’est pas présent le jour de l’évaluation ? La réponse set

clairement indiquée dans le texte du BO, en référence à la note de service n°2002-278 du 12 décembre

2002 : « Toute absence injustifiée d’un candidat scolaire le jour fixé pour l’évaluation des capacités

expérimentales entraîne l’attribution de la note « zéro » pour cette partie de l’épreuve ».

Est également suggérée l’idée que l’organisation de l’épreuve dans un établissement autre que celui

fréquenté par le candidat donnerait un caractère plus officiel à cette épreuve. Le rapport entre l’intérêt

représenté par un tel choix d’un côté, et les difficultés d’organisation qu’il entraîne de l’autre, sans compter la

mauvaise connaissance du matériel par les élèves, semble peu à l’avantage d’une telle procédure.

Enfin, peu de remarques concernant les modalités de passage de l’épreuve. Seules deux équipes estiment

la durée de quarante cinq minutes trop courte (« en particulier pour les sujets ExAO », mais le principe d’une

durée égale pour tous les sujets s’impose, tant pour des questions d’équité que de simple organisation).

« Les élèves ont du mal à s’approprier le protocole dans le temps imparti » note-t-on dans un autre retour.

Remarques concernant les conditions de préparation

Formation des élèves :

Le souhait de disposer de séances de deux heures de TP par semaine comme en sciences physiques

est très souvent exprimé : « Avec 1h30 de TP par semaine, il est impossible de traiter tous les types

d’exercices proposés au baccalauréat et de réaliser des tests d’évaluation pour préparer les élèves à

l’épreuve »

« Ne serait-il pas nécessaire de réfléchir à la place de ces TP dans nos situations d’apprentissage

(risques de TP recettes) ? » peut-on lire ailleurs. Nous avons bien insisté sur le fait que les sujets présents

dans la banque ne sont en aucun cas des « TP », mais bien des sujets d’évaluation, construits suivant une

logique propre. Il ne s’agit donc nullement de les utiliser en classe, ce serait en effet le retour des fiches TP

recettes, mais bien de les considérer comme des outils destinés à évaluer des compétences particulières.

Dates et mode de connaissance des sujets

La date à laquelle est connue la liste des vingt-cinq sujets retenus est jugée trop tardive par un certain

nombre d’équipes. Le souhait le plus généralement exprimé est celui de pouvoir en bénéficier avant les

vacances de printemps, « afin de préparer au mieux l’épreuve, en particulier au niveau matériel ». Plus rares

sont les équipes qui demandent que la liste soit publiée dès la rentrée de septembre. D’autres s’inquiètent

au contraire de la possibilité pour les élèves de connaître trop à l’avance les sujets retenus.

La solution adoptée, et qui restera valable cette année, est celle d’une connaissance des sujets de la

banque suffisamment tôt (mais il faut tout de même du temps au groupe pour prendre en compte les

remontées et apporter des modifications éventuelles en termes de contenu de la banque). Celle-ci devrait

donc être connue cette année fin février – début mars. Elle sera mise en ligne. En revanche, la

connaissance des vingt cinq sujets retenus restera la plus tardive possible, pour éviter les tentations de

« bachotage », qui vont à l’encontre de l’esprit même de l’épreuve.

L’utilisation d’Internet est critiquée par certains collègues, qui lui reprochent son manque de confidentialité :

« L’égalité des chances passe par la confidentialité des sujets donnés, qui ne doivent pas être diffusés sur

Internet ».

Cet argument tient peu devant la nature de ce qui est évalué. D’une part, les sujets couvrent l’ensemble du

programme, et surtout, ils sont destinés à évaluer … des compétences expérimentales. Bref, c’est

l’ensemble de ce que l’élève a appris « à faire » dans l’année qui est concerné par ces sujets. Il y a au

contraire le plus grand intérêt à ce qu’ils soient connus de tous, de manière à ce que les élèves sachent bien

en quoi consiste cette épreuve. En revanche, nous devrons veiller cette année à ce que les fiches

d’évaluation, destinées au professeurs, et qui ont un caractère professionnel, restent elles bien

confidentielles.

3

Un argument présenté en faveur d’une connaissance très précoce, dès septembre, des vingt cinq sujets

sélectionnés, est celui de la nécessité de connaître le matériel nécessaire, afin éventuellement de l’acquérir,

et de pouvoir l’utiliser en cours d’année : « Nous souhaiterions disposer au début d’année de la liste précise

du matériel nécessaire à la réalisation des TP : exemple, nous ne disposions pas du logiciel sismolog, par

ailleurs il nous a été impossible de réaliser le TP « Recherche de l’antigène de la B-lactoglobuline » car le

matériel ne correspondait pas exactement à celui dont nous pouvions disposer chez Sordalab ».

Outre qu’elle se heurte à une impossibilité technique, liée aux délais de travail du groupe, cette proposition

traduit une mauvaise perception de ce que représente la liste des vingt cinq sujets. Il ne s’agit nullement

d’une image de ce qu’auraient dû être dans l’année, à l’optimal, les différentes séances de travaux pratiques

organisées, avec les matériels adéquats retenus par l’institution. Il est fait simplement le pari, raisonnable,

que parmi les 25 sujets, il y en a bien un nombre significatif correspondant à des matériels utilisés dans

chaque établissement.

Pour cette année, et pour éviter un sentiment de « frustration » palpable dans certains retours, consigne a

cependant été donnée de privilégier dans les sujets des formulations qui favorisent le recours à des

matériels alternatifs. Cette question est également traitée un peu plus loin, concernant la diversité des

sujets.

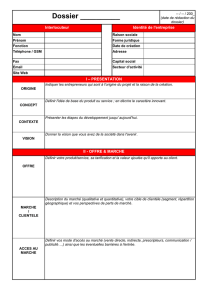

Concernant la conception des sujets

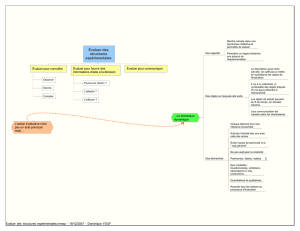

Equilibre entre gestes techniques et démarche :

Les remarques les plus nombreuses concernent la question de la part accordée dans la notation aux gestes

techniques et à des éléments de démarche qui donnent du sens à ces gestes techniques. De ce point de

vue les réflexions des équipes sont aussi diverses que tranchées. Si certaines regrettent que : « L’évaluation

porte essentiellement sur la capacité à expérimenter, mais pas à réfléchir sur leur expérience », d’autres font

le constat exactement opposé : « Les points apportés à l’exploitation sont trop importants par rapport à la

manipulation elle-même ».

Les règles retenues sont les suivantes : le choix a été fait de ne pas se cantonner à la simple évaluation

d’habiletés techniques, mais dévaluer également l’intégration de « l’intelligence du geste » dans une

démarche. C’est un choix difficile, mais qui répond bien aux exigences de notre enseignement de SVT. Il y a

donc une part de raisonnement et de réflexion dans les critères de notation, part qui doit rester ancrée sur la

manipulation effectuée : réflexion sur la pertinence du protocole proposé, mise en relation des résultats,

analyse critique des conditions expérimentales … Mais cette part ne saurait prendre une place trop

importante. L’essentiel de ce qui doit être évalué dans cette épreuve doit bien être ce qui ne peut pas être

évalué par ailleurs à l’écrit. Ainsi, la place qui est accordée dans les sujets, le plus souvent, de façon

explicite, à des éléments de démarche, de l’ordre de quatre à cinq points, paraît constituer un compromis

acceptable entre deux exigences fondées.

Cette règle étant établie, se pose malgré tout la question des écarts qui peuvent exister entre les sujets:

« Les parts relatives de la technique et des connaissances sont très variables d’un sujet à l’autre. Pour

certains sujets, notamment de microscopie, il importe d’avoir révisé les différents schémas et dessins et

leurs légendes ». Le groupe de travail cherche à avancer sur cette question, et il est assez généralement

admis que des progrès de ce point de vue ont été réalisés entre les sujets de la banque 2003 et ceux de la

banque 2004. Grâce aux apports de chacun, ce travail se poursuivra, sans qu’il soit possible d’imaginer qu’il

satisfera tout le monde. Mais le resserrement des écarts de notes entre les différents sujets observé lors de

la dernière session semble confirmer les avancées réalisées (sur l’académie de Rennes, l’amplitude des

moyennes est passée de 4,4 à 2,9 sur 20 d’une session à la suivante ; au niveau national, cette amplitude

est de l’ordre de 2 points sur 20).

Enfin, l’affirmation relevée dans un retour, selon laquelle « Il subsiste encore des disparités entre les sujets,

certains ne nécessitant aucune manipulation ou observation », fait sans doute référence aux épreuves

utilisant l’outil informatique, question traitée un peu plus loin..

Variété des sujets

Comme cela a été évoqué plus haut, un certain nombre de remarques concernant « un manque de variété

dans les sujets proposés » s’expliquent par la philosophie même de « la liste des 25 ». Une équipe regrette

ainsi que « Deux TP portent sur le test Elisa, aucune sur celui d’ d’Ouchterlony) ». Une autre que « l’on

trouve quatre sujets sur la subduction, et trois sur le passage crétacé tertiaire, souvent avec des matériels

identiques ». Par ces propositions, il s’agit simplement de permettre aux établissements, sur un thème

donné, de choisir le sujet qui, dans sa conception, ou dans les matériels proposés, correspond le mieux aux

pratiques mises en œuvre en cours d’année. Elles ne doivent nullement être considérées comme l’indication

4

de ce qu’il est pertinent ou non de proposer aux élèves en classe. Ainsi, en immunologie, rien n’interdit de

penser qu’il puisse y avoir, une prochaine année, un ou plusieurs sujets portant sur Ouchterlony … et aucun

test Elisa !

« Nous avons été très surpris de ne pas trouver dans la liste des 25 sujets retenus des sujets utilisant

Phylogène (logiciel gratuit contrairement à sismolog), RASMOL ou le microscope polarisant très utilisé en

première S et terminale S ». Cette réflexion, émanant d’un autre établissement, si on comprend bien la

« déception » ressentie par l’équipe, habituée à utiliser, de façon d’ailleurs très efficace et pertinente, des

matériels intéressants, appelle cependant la même réponse. Il ne s’agit pas, à travers les sujets retenus, de

privilégier tel matériel plutôt que tel autre, d’indiquer des manipulations qui seraient prioritaires par rapport à

d’autres, mais de faire de véritables choix d’évaluation qui varieront au fil des années.

Enfin, il est nécessaire de dire un mot face à une autre déception s’exprimant dans quelques retours :

« Nous sommes déçus face au manque de prise en compte des remarques que nous avons faites les

années précédentes ». Il faut avoir conscience de l’ampleur du travail réalisé par le groupe national. Les

observations prises en compte ont surtout été celles remontant de façon massive et convergente. Cela ne

doit surtout pas conduire les équipes à renoncer à faire connaître leurs points de vue et leurs propositions.

Mais il faut savoir que celle-ci ne sont pas toujours partagées, et qu’elles sont même parfois contradictoires

avec les propositions faites par d’autres

Critères de notation :

Un malaise autour de la notation est parfois perceptible, ou nettement exprimé : « Dans beaucoup de sujets,

même si l’élève faisait de grosses erreurs scientifiques, il peut obtenir une note importante »

Ces réflexions posent la question d’une évaluation qui va sans doute à l ‘encontre de nos habitudes

consistant à évaluer « globalement » le niveau des élèves. Ici, on entre volontairement, comme le font

d’ailleurs d’autres disciplines dans des domaines très différents, dans la pratique d’évaluation de

compétences ciblées. Rien d’étonnant dans ces conditions, et c’est même plutôt rassurant sur la validité

d’une telle épreuve, comme le notent d’ailleurs avec satisfaction plusieurs équipes, qu’il n’y ait pas

coïncidence entre les résultats habituellement observés à l’écrit et ceux obtenus ici. C’est bien qu’on évalue

« autre chose », ce qui correspondant d’ailleurs bien aux constatations fréquemment faites en séances de

travaux pratiques : comme le notent en effet régulièrement les enseignants, et comme le révélaient les

séances de « sciences expérimentales », ce ne sont pas toujours les « meilleurs » élèves qui réussissent le

mieux les manipulations.

Face à cette situation, les solutions parfois préconisées conduiraient purement et simplement à minimiser

l’importance de ces compétences dans la note finale du baccalauréat. C’est le cas de la proposition

suivante, relevée dans les retours : « La corrélation entre la note obtenue et le niveau des candidats tel qu’il

a été identifié par le professeur en cours d’année est loin d’être évidente. Plus simplement, nombre de

candidats très faibles ont obtenu d’excellentes notes, et, hélas, inversement. Un rééquilibrage entre les

quatre points généralement accordés pour l’explication des résultats et les seize points accordés pour

« l’accomplissement des gestes » pourrait atténuer cette anomalie ».

Sur la question de savoir si l’épreuve rend bien compte des compétences expérimentales acquises, un

témoignage apporte une réponse, naturellement partielle. Dans cet établissement, sur un petit effectif il est

vrai, « la corrélation entre les résultats obtenus à l’épreuve avec ceux d’une évaluation sommative réalisée

en cours d’année, des notes de TP, et d’une estimation de l’efficacité pendant les séances » apparaît très

bonne dans l’ensemble.

La question de la précision des barèmes, et de son influence sur l’équité de traitement des candidats en

fonction des différents correcteurs, est également posée un certain nombre de fois.

« Il serait judicieux de préciser davantage les niveaux d’exigences concernant les légendes et d’une façon

générale comment doit être évaluée une erreur flagrante dans les connaissances conduisant à une réponse

totalement erronée »

« Les attitudes face à l’élève qui s’égare totalement (ex : élève qui désigne le testicule normal comme étant

celui de l’individu stérile, ou qui demande de l’aide, ne sont pas les mêmes selon les enseignants ».

« Il est nécessaire de beaucoup mieux préciser les niveaux d’exigence correspondant aux différents critères

d’évaluation, eux même à mieux détailler ».

Les fiches d’évaluation doivent en effet être présentées de telle façon qu’il n’y ait pas d’ambiguïtés quant aux

attentes du sujet. Cela n’empêche nullement les correcteurs, à l’interne de l’établissement, d’harmoniser, en

amont de l’épreuve, leurs pratiques d’évaluation, et d’arrêter des positions communes, pendant l’épreuve,

5

face à un certain nombre de difficultés rencontrées. Pour ce qui est de l’harmonisation entre établissements,

la question se posera si des écarts inexplicables de notation sont observés. Cela n’a pas été le cas lors des

deux précédentes sessions. Cette question relève naturellement de la responsabilité de l’inspection.

Il est à noter que le « manque de détail des barèmes » a amené quelques rares équipes à détailler les fiches

d’évaluation au demi point près, prenant exemple sur un document du même type en chimie. Il faut avoir

conscience des effets qu’un tel « saucissonnage » peut avoir sur la note finale, avec une tendance au

resserrement des notes autour de la moyenne. D’autre part, il est impératif de veiller à ne pas pénaliser des

élèves ne répondant pas à des attentes qui n’auraient pas été clairement explicitées..

La question des évaluateurs :

« La plupart des collègues considère qu’il est indispensable que les élèves soient évalués par un autre

professeur que le leur »

La règle de ce point de vue est très claire : ne pas faire évaluer les élèves par leur professeur de l’année

scolaire est une consigne impérative. Ce qui peut obliger, en particulier pour les petits établissements, à des

échanges ponctuels entre deux lycées proches.

Pour le reste, l’anonymat dans ce type d’épreuve ne constitue nullement une obligation, et le fait d’avoir

connu les élèves au cours de leur scolarité ne présente pas d’inconvénient clairement identifié, même si la

connaissance des élèves apparaît mal vécue dans certains retours: « Sur 73 élèves de terminale, j’en

connaissais 64, les ayant eu en première S ou les ayant en terminale S (obligatoire ou spécialité) », ou,

ailleurs : « L’anonymat est le point qui nous pose le plus de soucis. L’idéal serait d’évaluer les élèves d’un

autre établissement ».

« Le manque de recul des examinateurs qui n’enseignent pas en terminale », cité par une équipe, ne devrait

pas non plus constituer un frein .

Place de l’informatique :

Pour certains, « l’outil informatique est trop privilégié ». Pour d’autres, il y a une grande disparité entre « des

sujets testant de véritables capacités expérimentales (ceux de spécialité en particulier) à opposer à ceux ne

testant pas de capacités expérimentales : logiciels sismolog, anagène ».

Les retours montrent que les professeurs sont très divisés sur cette question.

Le choix qui a été arrêté repose sur deux éléments : d’une part l’outil informatique est entré de façon

irréversible dans nos laboratoires de SVT et son utilisation est devenue courante lors des activités

pratiques ; d’autre part, la maîtrise de cet outil pour des usages propres à la discipline, qui fait l’objet

d’apprentissages en SVT, en faisant à la fois un outil et un objectif de notre enseignement, ne peut être

évalué à l’écrit. C’est ce qui a conduit à intégrer ces compétences particulières aux compétences

expérimentales, même si des discussions restent légitimes autour de cette question.

Et pour finir, quelques remarques sur les sujets de sciences de la Terre :

Des remarques portent sur la place de la géologie dans la liste des vingt cinq sujets retenus l’an dernier :

« Les sujets de sciences de la Terre impliquaient soit la maîtrise de sismolog, soit celle de Excel. Il est

étonnant qu’il n’y ait pas eu d’étude de roches. », ou, ailleurs : « Nous regrettons la disparition de TP sur la

subduction faisant appel à l’observation de lames minces au profit de TP informatiques ».

Là encore les sujets retenus l’an dernier ne fixent pas un cadre pour la suite. Il est effectivement important

que l’exploitation « d’objets géologiques » au sens large fasse partie des compétences susceptibles d’être

évaluées.

Sans rentrer en contradiction avec les limites énoncées dans les documents d’accompagnement,

concernant en particulier l’identification de minéraux, l’utilisation de lames minces et des comparaisons avec

des documents photographiques ou des schémas restent totalement pertinentes … et évaluables.

Janvier 2005

1

/

5

100%