Entropie et Perplexité : Mesurer la Diversité du Langage en IA

Telechargé par

Romaric Ulrich Zongo

Question de d´epart

®Comment mesurer la “qualit´e” d’un mod`ele de langage ?

Un mod`ele de langage donne une probabilit´e `a chaque

mot suivant :

P(wt|contexte).

Mais comment savoir s’il est bon ?

Est-il trop incertain ?

Est-il trop confiant sur de mauvaises r´eponses ?

R´eponse math´ematique :

l’entropie : incertitude moyenne ;

la perplexit´e : nombre “effectif” de choix possibles.

Dr. Clotilde Djuikem 2 / 13

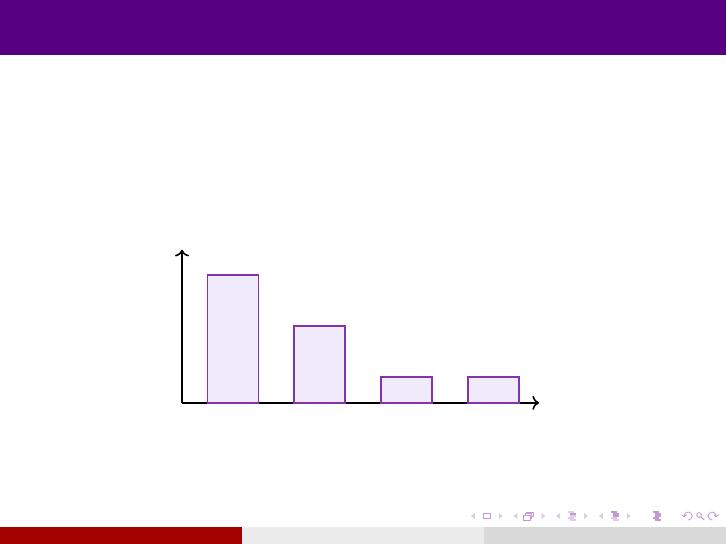

1. Distribution sur les mots

Pour un contexte donn´e (ex : “Le chat mange . . .”), un

mod`ele peut donner par exemple :

P(des) = 0,5,P(une) = 0,3,P(rapidement) = 0,1,P(voiture) = 0,1.

mots

probabilit´e

des une rapidement voiture

Question : comment r´esumer cette distribution par un seul nombre ?

Dr. Clotilde Djuikem 3 / 13

2. Entropie de Shannon (d´efinition)

Pour un mod`ele de langage Pet une phrase w1,...,wT:

H=−1

T

T

X

t=1

log2P(wt|w<t).

Hse mesure en bits par mot.

Grande entropie H: le mod`ele est souvent incertain.

Petite entropie H: il est plutˆot confiant.

Intuition : c’est le nombre moyen de bits n´ecessaires

pour coder un mot si on suit le mod`ele P.

Dr. Clotilde Djuikem 4 / 13

3. Exemple num´erique simple

Supposons que pour un contexte donn´e :

P(des) = 0,5,P(une) = 0,25,P(rapidement) = 0,15,P(voiture) = 0,10.

L’entropie locale vaut :

H=−0,5 log20,5+0,25 log20,25+0,15 log20,15+0,10 log20,10.

On trouve num´eriquement (approx) :

H≈1,74 bits.

Lecture : en moyenne, il faut ≈1,74 bits pour coder le

mot suivant selon ce mod`ele.

Dr. Clotilde Djuikem 5 / 13

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

1

/

13

100%