HAL Id: tel-01100255

https://tel.archives-ouvertes.fr/tel-01100255

Submitted on 6 Jan 2015

HAL is a multi-disciplinary open access

archive for the deposit and dissemination of sci-

entic research documents, whether they are pub-

lished or not. The documents may come from

teaching and research institutions in France or

abroad, or from public or private research centers.

L’archive ouverte pluridisciplinaire HAL, est

destinée au dépôt et à la diusion de documents

scientiques de niveau recherche, publiés ou non,

émanant des établissements d’enseignement et de

recherche français ou étrangers, des laboratoires

publics ou privés.

Distributed under a Creative Commons Attribution - NoDerivatives| 4.0 International

License

Diusion de l’information dans les médias sociaux :

modélisation et analyse

Adrien Guille

To cite this version:

Adrien Guille. Diusion de l’information dans les médias sociaux : modélisation et analyse. Informa-

tique [cs]. Université Lumière Lyon 2, 2014. Français. �tel-01100255�

Thèse présentée pour obtenir le grade de

Docteur de l’Université Lumière Lyon 2

École Doctorale Informatique et Mathématiques (ED 512)

Laboratoire ERIC (EA 3083)

Discipline : Informatique

Diffusion de l’information dans les médias sociaux

Modélisation et analyse

Par : Adrien Guille

Présentée et soutenue publiquement le 25 novembre 2014, devant un jury composé de :

Pascal Poncelet,Professeur des Universités, Université Montpellier 2 Rapporteur

Emmanuel Viennet,Professeur des Universités, Université Paris 13 Rapporteur

Vincent Labatut,Maître de Conférences, Université d’Avignon et des Pays du Vaucluse Examinateur

Christine Largeron,Professeur des Universités, Université Jean Monnet Saint-Etienne Examinatrice

Cécile Favre,Maître de Conférences, Université Lumière Lyon 2 Co-directrice

Djamel Zighed,Professeur des Universités, Université Lumière Lyon 2 Directeur

Abstract

Social media have greatly modified the way we produce, diffuse and consume

information, and have become powerful information vectors. The goal of this thesis

is to help in the understanding of the information diffusion phenomenon in social

media by providing means of modeling and analysis.

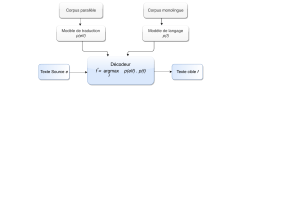

First, we propose MABED (Mention-Anomaly-Based Event Detection), a statistical

method for automatically detecting events that most interest social media users from

the stream of messages they publish. In contrast with existing methods, it doesn’t

only focus on the textual content of messages but also leverages the frequency of

social interactions that occur between users. MABED also differs from the literature in

that it dynamically estimates the period of time during which each event is discussed

rather than assuming a predefined fixed duration for all events. Secondly, we propose

T-BASIC (Time-Based ASynchronous Independent Cascades), a probabilistic model

based on the network structure underlying social media for predicting information

diffusion, more specifically the evolution of the number of users that relay a given

piece of information through time. In contrast with similar models that are also based

on the network structure, the probability that a piece of information propagate from

one user to another isn’t fixed but depends on time. We also describe a procedure

for inferring the latent parameters of that model, which we formulate as functions of

observable characteristics of social media users. Thirdly, we propose SONDY (SOcial

Network DYnamics), a free and extensible software that implements state-of-the-art

methods for mining data generated by social media, i.e. the messages published by

users and the structure of the social network that interconnects them. As opposed

to existing academic tools that either focus on analyzing messages or analyzing the

network, SONDY permits the joint analysis of these two types of data through the

analysis of influence with respect to each detected event.

The experiments, conducted on data collected on Twitter, demonstrate the rele-

vance of our proposals and shed light on some properties that give us a better un-

derstanding of the mechanisms underlying information diffusion. First, we compare

3

the performance of MABED against those of methods from the literature and find that

taking into account the frequency of social interactions between users leads to more

accurate event detection and improved robustness in presence of noisy content. We

also show that MABED helps with the interpretation of detected events by providing

clear textual descriptions and precise temporal descriptions. Secondly, we demons-

trate the relevancy of the procedure we propose for estimating the pairwise diffusion

probabilities on which T-BASIC relies. For that, we illustrate the predictive power of

users’ characteristics, and compare the performance of the method we propose to es-

timate the diffusion probabilities against those of state-of-the-art methods. We show

the importance of having non-constant diffusion probabilities, which allows incorpo-

rating the variation of users’ level of receptivity through time into T-BASIC. We also

study how – and in which proportion – the social, topical and temporal characteristics

of users impact information diffusion. Thirdly, we illustrate with various scenarios the

usefulness of SONDY, both for non-experts – thanks to its advanced user interface and

adapted visualizations – and for researchers – thanks to its application programming

interface.

Keywords. Social media data mining ; Event detection and tracking ; Modeling and

predicting information diffusion ; Scientific software development.

4

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

145

145

146

146

147

147

148

148

149

149

150

150

151

151

152

152

153

153

154

154

155

155

156

156

157

157

158

158

159

159

160

160

161

161

162

162

163

163

164

164

165

165

166

166

167

167

168

168

169

169

170

170

171

171

172

172

173

173

174

174

175

175

176

176

177

177

178

178

179

179

180

180

181

181

182

182

183

183

184

184

185

185

186

186

187

187

188

188

189

189

190

190

1

/

190

100%