Conflits et persistance dans l'erreur : HDR pluridisciplinaire

Telechargé par

guillaume.andeol

See discussions, stats, and author profiles for this publication at: https://www.researchgate.net/publication/269895411

Conflit et persistance dans l'erreur : une approche pluridisciplinaire (HDR)

Book · June 2012

CITATIONS

4

READS

1,130

1 author:

Some of the authors of this publication are also working on these related projects:

MAIA - Modélisation de l'Attention pour une Interaction Adaptative View project

Human-Robotic Performance View project

Frédéric Dehais

Institut Supérieur de l'Aéronautique et de l'Espace (ISAE)

160 PUBLICATIONS2,085 CITATIONS

SEE PROFILE

All content following this page was uploaded by Frédéric Dehais on 23 December 2014.

The user has requested enhancement of the downloaded file.

HABILITATION A DIRIGER LES RECHERCHES

Université Paul Sabatier

présentée par

Frédéric DEHAIS

Enseignant-chercheur à l’ISAE - Formation Supaéro

Conflits et persistance dans l’erreur :

une approche pluridisciplinaire.

Table des matières

Introduction 3

1 Conflits 5

1.1 Préambule : de la nécessité du conflit . . . . . . . . . . . . . . . . . . . . . . . . . 5

1.1.1 Les limites du concept d’erreur humaine . . . . . . . . . . . . . . . . . . . . 5

1.1.2 Le conflit : une approche complémentaire à l’étude de l’erreur humaine . . . 6

1.2 Vers une définition du conflit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

1.2.1 Conflit en psychologie sociale, intelligence artificielle distribuée (IAD), en neu-

rosciencesetergonomie ............................ 6

1.2.2 Notion d’incohérence et d’engagement dans un but . . . . . . . . . . . . . . 7

1.3 Modélisation des conflits : le cas des conflits entre l’opérateur et les systèmes auto-

matiques......................................... 8

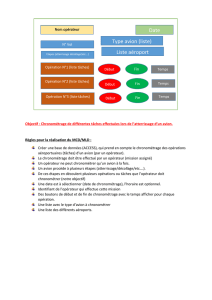

1.3.1 Le cas du pilote automatique d’avion de transport . . . . . . . . . . . . . . 8

1.3.2 La détection du conflit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

1.3.3 Mise en oeuvre dans le simulateur de l’Isae . . . . . . . . . . . . . . . . . . 10

1.4 Conclusion........................................ 14

2 Vers une résolution du conflit 15

2.1 Préambule : le conflit, un précurseur de la dégradation de la performance . . . . . . 15

2.2 Approche expérimentale du conflit . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

2.2.1 Expérimentation 1 : conflit dans les interactions opérateur - robot . . . . . . 16

2.2.2 Définition de contre-mesures cognitives . . . . . . . . . . . . . . . . . . . . 20

2.2.3 Expérimentation 2 : évaluation des effets des contre-mesures cognitives . . . 20

2.3 Adapter l’interaction pour résoudre le conflit . . . . . . . . . . . . . . . . . . . . . . 23

2.3.1 Principes .................................... 24

2.3.2 Inférence de la “tunnélisation attentionnelle” . . . . . . . . . . . . . . . . . . 25

2.3.3 Modéliser la dynamique de l’autorité opérateur-automate . . . . . . . . . . . 28

2.4 Conclusion........................................ 32

3 Aspects neuroergonomiques du conflit

et de la persistance dans l’erreur 35

3.1 Préambule : le continuum cognitif . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

3.2 Fonctions exécutives et persistance dans la décision d’atterrir en aviation légère . . . 36

3.2.1 Apport de la neuropsychologie : les batteries de test . . . . . . . . . . . . . 37

3.2.2 Expérimentation ................................ 37

3.3 Etude neuroéconomique du conflit lors de la prise de décision à l’atterrissage . . . . 39

3.3.1 Le conflit entre sécurité et désir d’atterrir . . . . . . . . . . . . . . . . . . . 39

3.3.2 Apport des neurosciences : . . . . . . . . . . . . . . . . . . . . . . . . . . 40

1

3.3.3 Expérimentation ................................ 40

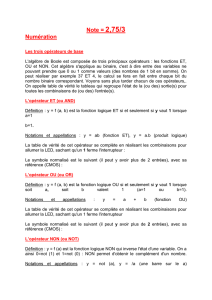

3.4 Le conflit visuo-auditif ou l’insensibilité des pilotes aux alarmes auditives : . . . . . . 44

3.4.1 L’apport des neurosciences pour la compréhension des conflits de bas niveau 44

3.4.2 Expérimentation ................................ 45

3.5 Conclusion........................................ 49

4 Conclusion et perspectives 51

4.1 Perspective 1 : Neuroergonomie . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52

4.2 Perspective 2 : Experimenter de nouvelles contre-mesures cognitives . . . . . . . . . 53

4.3 Perspective 3 : Modélisation de l’attention . . . . . . . . . . . . . . . . . . . . . . . 54

4.3.1 Détection en temps réel de la “tunnélisation de l’attention” . . . . . . . . . . 54

4.3.2 Vers un modèle neuropsychologiquement plausible de l’attention visuelle et

auditive ..................................... 55

4.4 Perspective 4 : Initiative mixte . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57

4.4.1 Application à la planification mixte de trajectoire . . . . . . . . . . . . . . . 57

4.4.2 Application à la planification de mission . . . . . . . . . . . . . . . . . . . . 59

4.4.3 Vers une interface à initiative mixte . . . . . . . . . . . . . . . . . . . . . . 61

4.5 Synthèse des perspectives . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

Bibliographie 63

2

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

1

/

81

100%