Etiquetage grammatical et analyse syntaxique par programmation

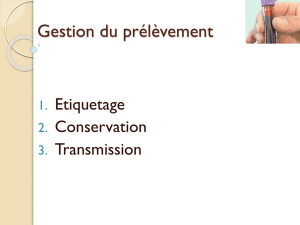

Etiquetage Analyse

Etiquetage grammatical

But

Associer à une séquence w=w1...wkde mots, une séquence t

=t1...tkd’étiquettes appartenant à un jeu d’étiquettes J.

Point de vue probabiliste

Trouver la séquence la séquence d’étiquettes ˆ

t qui maximise

P(t|w)parmi l’ensemble des séquences d’étiquettes possibles.

ˆ

t =argmaxtP(t|w) = argmaxtP(w|t).P(t)

Etiquetage Analyse

Modèle de Markov caché d’ordre N

Principe

◮Symbole visible : mot

◮Symbole caché à découvrir : étiquette

◮Hypothèses d’indépendance

Hypothèses de Markov pour le calcul de P(w|t).P(t)

◮P(w|t)? un symbole observé (mot) ne dépend que du

symbole caché associé (étiquette)

◮P(t)? un symbole caché (étiquette) ne dépend que de ses

Nprécédents

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

1

/

24

100%