Chapitre_3

23

Chapitre 3

Processus aléatoires

1. Introduction

Le mot « signal » désigne l’évolution temporelle d’une grandeur physique

mesurable (courant, tension, force, température, pression, etc.). Ces signaux

physiques sont modélisés par des fonctions mathématiques

x

dépendant d’une

variable représentant le temps

t

. En pratique un signal est issu d’une mesure par

un capteur. Un signal est dit déterministe si son évolution peut être prédite en

utilisant un modèle mathématique. C’est le cas de la tension électrique aux

bornes d’une alimentation qui peut s’écrire

)2cos()( 0tfAtx

. Si

A

et f0 sont

connus, on peut déterminer la valeur de l’amplitude à n’importe quel instant. Il

n’en est plus de même pour un signal tel que celui observé à la sortie d’un

microphone. Il semble que tout effort pour écrire l’équation d’un tel signal, même

avec un très grand nombre de paramètres, soit voué à l’échec. Par contre on

imagine assez bien que, faute de pouvoir donner la valeur du signal à un instant t,

il soit possible de préciser une distribution de valeurs possibles. D’où l’idée

d’utiliser des variables aléatoires pour décrire le phénomène à tout instant [4,5].

2. Définition

Un processus aléatoire (ou stochastique) est une famille de fonction

)(tX

,

réelles ou complexes, définies dans un espace de probabilité, c’est-à-dire

dépendant de deux variables, l’une est le temps

t

, l’autre est la variable

définissant le hasard. Selon que les variables sont continues ou discrètes, on

parle de processus aléatoires continus ou discrets.

2.1. Signaux aléatoires

Pour une réalisation

i

donnée, le processus aléatoire

),(

tX

se réduit à une

fonction

),( i

tx

que l’on notera simplement

)(txi

, c’est un signal aléatoire. Par

convention, un signal aléatoire

)(tx

est considéré comme un signal à puissance

moyenne finie, dont la puissance est calculée par l’équation :

2/

2/

2

)(

1

lim T

T

T

xdttx

T

P

(1.1)

A partir de

)(tx

, on peut définir la moyenne temporelle du signal :

2/

2/

)(

1

lim T

T

Tdttx

T

x

(1.2)

24

2.2. Variables aléatoires

A chaque instant

i

t

, le processus aléatoire

),(

tX

se réduit à une variable

aléatoire

),(

i

tX

notée

)( i

tX

ou simplement

i

X

, dont le comportement nécessite la

connaissance de sa fonction de répartition :

)(),()( xXprobtxFxF iiXXi

(1.3)

ou de sa densité de probabilité :

dx

xdF

txpxp i

i

X

iXX )(

),()(

(1.4)

Pour évaluer la moyenne

X

de la variable aléatoire

X

, on peut calculer la moyenne

des

N

épreuves :

N

nn

NX

N

X1

1

lim

(1.5)

Si l’on connait la loi de probabilité de

X

, l’espérance mathématique est donnée

par :

dxxxpXE X)(

(1.6)

2.3. Vecteurs aléatoires

Soient les variables aléatoires

k

XXX ,,, 21

associes aux instants

k

ttt ,,, 21

. Ces

variables aléatoires forment un vecteur aléatoire

T

k

XXX ,,, 21

. Ce vecteur est

caractérisé par sa fonction de répartition :

),,,(),,,( 221121 kkkX xXxXxXprobxxxF

(1.7)

3. Processus aléatoire

Un processus aléatoire

),(

tX

est une famille de fonctions

)(tX

, réelles ou

complexes, définies dans un espace de probabilité, c’est-à-dire dépendant de

deux variables, l’une est le temps

t

, l’autre est la variable

définissant le hasard

[4,5].

25

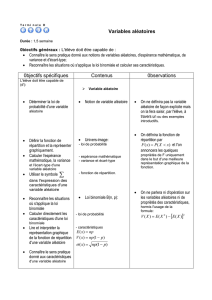

Figure.1 Processus aléatoire

-

),(

tX

est une variable aléatoire si

t

est fixe,

est variable.

-

),(

tX

est un signal aléatoire (réalisation) si

t

est variable,

est fixe.

-

),(

tX

est un nombre si

t

est fixe,

est fixe.

-

),(

tX

est processus aléatoire si

t

est variable,

est variable.

Selon que les variables

t

et

sont continues ou discrètes, on parle de processus

aléatoires continus ou discrets comme suit :

- si

t

et

sont continues alors

),(

tX

est un processus aléatoire continu

(continuous random process).

- si

t

est continu et

est discret alors

),(

tX

est un processus aléatoire

discret (discrete random process).

- si

t

est discret et

est continu alors

),(

tX

est une séquence aléatoire

continue (continuous random sequence)

- si

t

est discret et

est discret alors

),(

tX

est une séquence aléatoire

discrète (discrete random sequence).

3.1. Statistiques d’un processus aléatoire

L’équation (1.7) caractérise les statiques d’ordre

k

du processus aléatoire

),(

tX

. De façon générale, on s’intéresse à des statistiques d’ordre 1 pour une

variable, et les statistiques d’ordre 2 pour un vecteur de deux variables

aléatoires.

3.1.1. Statistiques d’ordre 1

Soit

i

X

une variable aléatoire du processus aléatoire

),(

tX

à l’instant

i

t

. Sa

fonction de répartition est notée

)(),( xXprobtxF iiX

et sa densité de

probabilité

dxxdFtxp i

XiX /)(),(

.

On peut définir les différents moments statistiques :

Moment d’ordre 1 (moyenne) :

26

dxxxpXE i

Xi )(

(1.8)

Moment d’ordre

n

dxxpxXE i

X

nn

i)(

(1.9)

Moment centré de degré ou d’ordre

n

dxxpXExXEXE i

X

n

i

n

ii )(])[(])[(

(1.10)

Moment centré d’ordre 2

Ce moment s’appelle la variance. Elle est définie comme :

dxxpXExXEXE i

Xiii )(])[(])[( 222

(1.11)

La variance peut être aussi s’exprimée sous la forme :

222 ][ i

Xi mXE

(1.12)

La variance est une mesure de la dispersion de la variable aléatoire autour de

sa moyenne. Sa racine carrée est appelée écart-type (standard déviation).

3.1.2. Statistiques d’ordre 2

Soient les deux variables aléatoires

)( 11 tXX

,

)( 22 tXX

et la fonction de

répartition :

),(),( 221121 xXxXprobxxFX

(1.13)

et la densité de probabilité :

21

21

2

21 ),(

),( xx xxF

xxp X

X

(1.14)

On peut alors définir les différents moments du vecteur aléatoire

T

XX ],[ 21

par

][ 21 nm XXE

, en particulier, pour comparer les variables aléatoires, on

utilise la fonction d’autocorrélation statistique :

2121212121 ),(][),( dxdxxxpxxXXEttr Xx

(1.15)

27

Et la fonction d’autocovariance, qui n’est autre que la fonction d’autocorrélation

des variables centrées :

2121212121 ),())(()])([(),( 2121 dxdxxxpxxmXmXEttc XXXXXx

(1.16)

En développant cette expression, on peut aboutir à :

21

),(),( 2121 XXxx mmttrttc

(1.17)

Remarque : Si

21 tt

, on aura .

3.2. Stationnarité et ergodicité

3.2.1. Processus stationnaire au sens strict

Un processus aléatoire est dit stationnaire au sens strict, si toutes ses

propriétés statistiques sont invariantes à un changement d’origine du temps.

3.2.2. Processus stationnaire au sens large

Un processus aléatoire est dit stationnaire au sens large, si toutes ses

propriétés statistiques d’ordre 1 et 2 sont invariantes à un changement d’origine

du temps.

Pour un processus aléatoire stationnaire au sens strict, on a :

jixpxpxp XXX ji ,),()()(

(1.18)

Pour un processus aléatoire stationnaire au sens large, on a :

Xi XEXE

(1.19)

222 Xi XEXE

(1.20)

),(),( 21

xx rttr

),(),( 21

xx cttc

12 tt

(1.21)

3.2.3. Processus ergodique

Un processus aléatoire est dit ergodique (ergodic) si les valeurs moyennes

statistiques (d’ensemble sur ζ) sont égales aux valeurs moyennes temporelles

(sur une seule réalisation). La conséquence de cette hypothèse est très

importante en pratique. Elle permet de remplacer les calculs de moments

statistiques (qui supposent connues les densités de probabilité ou les fonctions

de répartition) par les moyennes temporelles sur une seule réalisation

(observation). En pratique, faire une estimation de la moyenne temporelle sur une

fenêtre de taille infinie est impossible. Il faut se contenter d’une approximation

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%