’ M

MINISTERE DE L’ENSEIGNEMENT SUPERIEUR ET DE LA RECHERCHE

SCIENTIFIQUE

MINISTÈRE DE L’ENSEIGNEMENT SUPÉRIEUR

ET DE LA RECHERCHE SCIENTIFIQUE

UNIVERSITÉ HADJ LAKHDAR « BATNA »

FACULTÉ DE TECHNOLOGIE

DÉPARTEMENT DE GÉNIE INDUSTRIEL

MEMOIRE DE MAGISTER

PRESENTE AU

Laboratoire d’automatique et Productique

En vue de l’obtention de diplôme de

MAGISTER

Spécialité : Génie Industriel et Productique

Par

AMAR HABOUSSI

Ingénieur d’état en Informatique

Thème

Directrice de Thèse : Dr. L. Hayet MOUSS

Devant le JURY :

Nadia Mouss MC-A Université de Batna Présidente

Hayet Mouss MC-A Université de Batna Rapporteur

Okba Kazar Prof Université de Biskra Examinateur

Hamoudi Kalla MC-A Université de Batna Examinateur

Rafik Mahdaoui MAT-A Université de Khenchela Co-Encadreur

Année Universitaire : 2011-2012

Systèmes Immunitaires Artificiels

pour le diagnostic des systèmes complexes

Au nom de Dieu le Clément, le Tout Miséricordieux

Nous remercions tout d'abord Dieu de nous avoir offert tout ce que

nous possédons.

Nous tenons à remercier vivement Pr. L.H.MOUSS et Mr.

R.Mahdaoui pour avoir acceptés de diriger et suivre la réalisation de notre

mémoire, pour leurs conseils et remarques qui nous été d'un grand apport.

Nous remercions également les membres de jury pour avoir accepter

de juger et critiquer ce travail, ainsi que tout ceux qu’ont honore de leur

présence.

Nous remercions aussi l'ensemble des enseignants au département

génie industriel.

AMAR HABOUSSI

A ma famille que j

’

aime…

A touts mes amies…

SOMMAIRE

INTRODUCTION GENERALE

DIAGNOSTIC PAR RECONNAISSANCE DE FORME

I.1 Introduction

7

I.2 Supervision Des Systèmes

7

I.3 Systèmes Complexes

8

I.3.1 Notion de système et système complexe

8

I.3.2 Les type de systèmes

12

I.3.2.1 les systèmes continus

12

I.3.2.2 Les systèmes a évènements discrets

12

I.3.2.3 Les systèmes dynamiques hybrides

12

I.4 Surveillance Industrielle

13

I.4.1 Module d'acquisition de données

14

I.4.2 Module de perception

16

I.4.3 Module de détection de défauts

17

I.4.4 Module de localisation de défauts

17

I.4.5 Module d’identification de défauts

17

I.4.6 Module de pronostic

18

I.4.7 Module d'analyse de conséquences

18

I.4.8 Module de planification des actions

18

I.5 Le Diagnostic Industriel

19

I.5.1 Organisation générale d’un système de surveillance

19

I.5.2 Les Stratégies Du Diagnostic Industriel

21

I.5.2.1 Stratégies Orientées Bon Fonctionnement

22

I.5.2.2 Stratégie Orientée Mauvais Fonctionnement

22

I.6 Les différentes méthodes de diagnostic

23

I.6.1 Choix de la méthode de diagnostic

23

I.6.2 Le Diagnostic à base de modèles

24

I.6.2.1 Redondance Analytique

25

I.6.2.2 Estimation Paramétrique

25

I.6.2.3 Observateur

26

I.6.2.4 Filtre

26

I.6.2.5 Espace De Parité

26

I.6.3. Les Méthodes sans modèles (directes)

27

I.6.3.1 Redondance Matérielle

27

I.6.3.2 Seuillage

28

I.6.3.3 Traitement Statistique

28

I.6.3.4 Modèles de connaissance

28

I.6.3.4.1 Les Systèmes Experts

28

I.6.3.4.2 Le Raisonnement a partir de cas

28

I.6.3.5 La Reconnaissance De Formes

29

I.7Conclusion

30

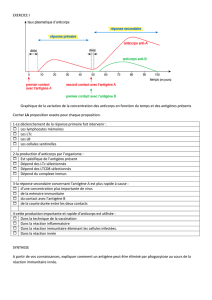

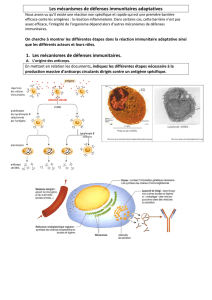

LES SYSTEMES IMMUNITAIRES NATURELS

II.1 Introduction

32

II.2 Systèmes immunitaires naturels

32

II.2.1 Historique

33

II.2.2 Concepts immunologiques

33

II.2.2.1 Organes immunitaires

33

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

1

/

140

100%