Les caprices des marchés financiers : régularités et

84

Tout le monde a suivi, au moins

une fois dans sa vie, par

hasard ou par nécessité, avec

angoisse ou avec curiosité, la chro-

nique du cours de la bourse, du dol-

lar ou du pétrole. A la vérité, ces

chroniques se ressemblent toutes, et

c’est la première surprise : sans uni-

tés sur les axes qui permettent de

reconnaître les dates ou la valeur des

cours, ou de connaître les échelles

temporelles et les échelles de varia-

tion, il est difficile de distinguer une

action d’une devise, une matière pre-

mière d’une obligation. L’apparence

visuelle (la « texture ») de ces gra-

phiques et, de façon plus quantita-

tive, les propriétés statistiques des

fluctuations des cours financiers

(que nous détaillerons plus loin,

encadré 1) sont étonnamment

stables, à la fois dans l’espace et

dans le temps : les marchés du XVIIIe

siècle se comportent qualitativement

comme ceux du XXesiècle ; ceux de

Tokyo comme ceux de New-York

semblent être la trace de comporte-

ments humains récurrents, univer-

sels et, par là même, éventuellement

modélisables.

La modélisation quantitative des

comportements humains paraît en-

core saugrenue à certains physiciens,

qui semblent opposer la matière

inerte, docile, sans états d’âme et se

prêtant à une expérimentation repro-

ductible aux êtres humains, fonda-

mentalement imprédictibles car

doués de libre arbitre, et de plus

capables de modifier leur comporte-

ment en réaction même à une théorie

les concernant. Pourtant, les sciences

économiques et sociales ont montré

depuis longtemps que ces comporte-

ments pouvaient être modélisés.

Dans le cas de l’économie, et en par-

ticulier des marchés financiers, une

modélisation quantitative mathémati-

sée, inspirée de la physique, a été

introduite au début du siècle. Cela a

été possible en premier lieu, parce

que les sciences physiques ont petit à

petit abordé l’étude de situations de

plus en plus complexes, chaotiques,

imprévisibles, comme la répartition

des vitesses dans un écoulement tur-

bulent, en modifiant progressivement

la notion même de prédiction et en

inventant de nouveaux outils de des-

cription statistique. Ainsi, au lieu de

chercher à prévoir la position d’une

particule au cours du temps, la phy-

sique du XXesiècle se contente sou-

vent de savoir avec quelle probabilité

la particule sera ici ou là au cours du

temps. C’est à ce courant général

(promu par Boltzmann, Einstein et

Langevin), que participe Bachelier

lorsqu’il propose dans sa thèse, en

1900, une « Théorie de la spécula-

tion » où il jette, cinq ans avant Ein-

stein, les bases de la théorie du mou-

vement brownien. Il y développe la

première théorie scientifique des

marchés financiers qui, après une tra-

versée du désert de plus d’un demi-

siècle, a profondément influencé le

développement des mathématiques

financières au cours des 30 dernières

années.

Le cadre de description statistique

s’accommode fort bien du libre

arbitre (réel ou supposé) des êtres

humains. Si dans une situation don-

née, chacun est libre d’agir comme il

le souhaite, pour des raisons en

général complexes et difficiles à cer-

ner complètement, les comporte-

ments collectifs de populations,

observés dans leur globalité ano-

nyme, acquièrent une régularité telle

que l’on peut espérer y trouver des

lois, des causes, des invariants –

comme pour les phénomènes

concernant la matière inerte. Pre-

nons par exemple le mouvement

erratique d’une particule brow-

nienne : il est dû aux chocs inces-

sants des molécules d’eau qui l’en-

tourent. On pourrait donc tenter une

description historique, anecdotique,

du mouvement en attribuant chaque

déflection à une répartition particu-

lière des molécules d’eau. Cette des-

cription détaillée est bien entendu

impossible et, au demeurant, peu

Systèmes dynamiques

Les caprices

des marchés financiers :

régularités et turbulences

Les marchés financiers offrent une masse extraordinaire de données quantitatives sur un

aspect particulier de l’activité humaine. Les séries temporelles de prix révèlent des

propriétés statistiques très spécifiques, qui rappellent par certains côtés la statistique des

champs turbulents. L’analyse de ces séries temporelles a-t-elle des choses à nous apprendre

sur les comportements humains ? Comment utiliser ces résultats pour une meilleure ges-

tion des risques financiers ? Les physiciens ont-ils leur place dans ce débat ? Le texte qui

suit fait le point sur dix ans de « Phynance » statistique.

– Service de physique de l’état condensé,

URA 2464 CNRS, CEA Saclay, Orme des

Merisiers, 91191 Gif-sur-Yvette cedex.

– Science & Finance, 109-111 rue Victor

Hugo, 92532 Levallois, www.science-

finance.com

85

Systèmes dynamiques

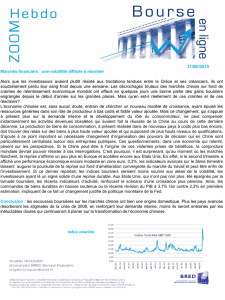

Encadré 1

QUELQUES ASPECTS STATISTIQUES

DES FLUCTUATIONS DES COURS

Si l’on appelle xle prix d’un actif financier (action, devise,

obligation, etc.), les variations relatives de prix

v=δlog x≈δx/xd’une minute à l’autre, d’une heure à

l’autre, d’un jour à l’autre, etc., possèdent des caractéris-

tiques statistiques relativement universelles, indépendantes du

marché considéré et de l’époque étudiée. Par exemple, la loi

P(v) de la variable aléatoire va des queues épaisses, que de

nombreuses études récentes, en particulier du groupe de

Stanley à Boston, sur des données haute-fréquence (concernant

surtout les actions) ont permis de caractériser plus finement.

Il s’agit de queues « de Pareto » P(v) ≈1/|v|1+µavec un

exposant µdans une gamme de 3à5. (Pour les actions

individuelles, la loi est relativement symétrique entre hausses

et baisses.) Ces queues décrivent les mouvements violents des

cours, qui peuvent varier en une heure de 1%mais parfois de

10% ou même de 100%. Si µ=3, la probabilité d’une chute

de 100% est un million de fois plus faible que celle d’une

chute de 1%. Ces variations extrêmes reflètent sans doute un

phénomène collectif dont il faudrait comprendre en détail la

nature et le mécanisme (encadré 3).

Plus l’échelle de temps sur laquelle on mesure vest grande,

plus ces queues ont tendance à disparaître, pour laisser

progressivement place à une loi gaussienne. Mais même à

l’échelle du mois, les effets non gaussiens restent notables.

Nous avons montré que cette lente disparition des queues est

reliée au phénomène d’intermittence de la volatilité, qui est le

terme consacré en finance pour parler de l’écart-type de v.

On peut en effet écrire vsous la forme du produit d’une variable

aléatoire (de variance unité) , positive ou négative, qui décrit la

direction du marché, et dont le temps de corrélation est très

faible (quelques dizaines de minutes), et d’une variable σqui

donne l’amplitude de ces fluctuations, la « température

locale » du marché : v=×σ. La fonction de corrélation

temporelle des σse comporte comme une loi de puissance

avec un exposant très faible. La figure ci-contre montre la

fonction de corrélation σ2(t+τ)σ2(t), qui décroît comme

une loi de puissance de τ, avec un exposant 0,22 pour les

actions américaines.

La faiblesse de cet exposant reflète le fait que les périodes de

forte volatilité, ou de calme relatif, durent un jour, une

semaine, ou même parfois plusieurs mois (pendant la guerre

du Golfe par exemple). Un modèle particulièrement riche et

intéressant, qui reproduit ce comportement intermittent de la

volatilité, est le modèle multifractal de Bacry-Muzy-Delour.

Ils postulent en effet que :

•est une variable gaussienne centrée réduite sans corrélations

temporelles, et

•logσest aussi une variable gaussienne, mais dont la fonction

de corrélation décroît très lentement (logarithmiquement)

avec le temps.

On peut, dans ce modèle, calculer exactement tous les

moments de l’accroissement du logarithme du prix entre deux

instants séparés par un intervalle τ. On trouve :

(log x(t+τ)−log x(t))2p=Apτζpζp=p[1 −λ2(p−1)],

0 20 40 60 80 100

τ (jours)

0.20

0.22

0.24

0.26

0.28

0.30

0.32

0.34

<[σ2(t+τ)−σ2(t)]2>

Beaucoup d’autres caractéristiques statistiques peuvent être

explorées, par exemple l’effet dit « leverage » qui concerne les

indices boursiers (CAC40, Dow Jones, etc.), qui est une

corrélation (négative) forte entre variations passées du prix et

volatilité future, sur une échelle temporelle d’une dizaine de

jours. Cet effet est relativement faible et difficile à mesurer ;

nous avons, avec Andrew Matacz et Marc Potters, quantifié et

modélisé cet effet en utilisant simultanément plusieurs sources

de données. Les effets multivariés, c’est-à-dire les corrélations

qui existent entre différentes actions (en particulier en période

de forte volatilité), ou entre obligations de différentes

échéances, mériteraient aussi une discussion plus approfondie.

Dans le premier cas, nous avons suggéré qu’une partie

importante du spectre des valeurs propres de la matrice de

corrélation se comprend grâce à la théorie des matrices

aléatoires de Wigner et Dyson. Cette théorie, inventée pour

comprendre le spectre énergétique des noyaux nucléaires,

montre que les valeurs propres d’une matrice aléatoire ont

des propriétés universelles. Dans le second cas, nous avons

souligné l’existence d’une analogie entre la courbe des taux

– qui décrit à un instant donné l’ensemble des taux d’intérêt

correspondant à des emprunts de durées différentes (un jour,

un mois, un an, dix ans...) – et les vibrations d’une corde

élastique soumise à un bruit aléatoire. Dans les deux cas, les

outils de la physique statistique offrent de nouvelles perspectives

et suggèrent une analyse originale des données financières.

Fonction de corrélation temporelle du carré de la volatilité en fonction

de l’intervalle de temps τ. Les données correspondent à une moyenne

sur les 500 actions américaines les plus liquides. La courbe en poin-

tillés est un ajustement en loi de puissance, avec un exposant ν=0,22.

Le modèle de Bacry-Muzy-Delour prédit un comportement en loi de

puissance de cette fonction de corrélation, avec ν=4λ2.

où λ2mesure les fluctuations de la volatilité et Apune

constante numérique. Un comportement non linéaire de

l’exposant ζpavec p(à comparer au mouvement brownien

pour lequel ζp≡p) est appelé multifractal et caractérise

aussi les fluctuations d’un champ de vitesses turbulent. Ce

modèle fait apparaître quantitativement les analogies entre

turbulence et marchés financiers.

86

instructive. La description probabi-

liste, proposée par Einstein et Lange-

vin, permet de dégager les lois uni-

verselles du mouvement brownien,

qui décrivent de manière extrême-

ment précise le comportement d’une

assemblée de ces particules, au détri-

ment de leurs histoires individuelles.

Ces particules, soumises à leur

propre poids, ont une probabilité

légèrement plus grande de se dépla-

cer vers le bas que vers le haut : l’ob-

servation de l’une d’entre elles ne

révèle que très difficilement cette

tendance à la descente, qui apparaît

cependant clairement au niveau col-

lectif. De la même façon, le compor-

tement des intervenants sur les mar-

chés financiers résulte de motivations

qui leur sont propres, mélanges d’ar-

guments rationnels, de mimétisme et

de pulsions émotionnelles, de

besoins immédiats ou de décisions à

long terme, de savants calculs ou

d’erreurs d’appréciation. Dans leur

globalité cependant, ces comporte-

ments individuels semblent engendrer

une régularité qui les dépasse. Bache-

lier écrivait ainsi que le marché, à

son insu, obéit à une loi qui le

dépasse, la loi de la probabilité. La

recherche des détails de cette loi est

depuis quelques années un domaine

très actif dans lequel sont impliqués

économistes, mathématiciens et phy-

siciens. Cette recherche est motivée,

entre autres, par la nécessité pour les

établissement financiers de contrôler

les risques inhérents à leur activité

spéculative, nécessité qui est appa-

rue, curieusement, plus tardivement

que dans d’autres domaines d’activi-

tés industrielles. Pourtant, les consé-

quences d’un krach boursier comme

celui de 1929 sont sous bien des

aspects comparables dans leur cor-

tège de malheurs à celles d’un acci-

dent nucléaire ou d’un tremblement

de terre. Le contrôle des risques s’est

imposé au début des années 90,

après le krach retentissant de 1987,

Encadré 2

LES OPTIONS ET LA FORMULE DE BLACK-SCHOLES

Une option est une sorte d’assurance contre les fluctuations

des marchés financiers. Par exemple, on peut vouloir assurer

son portefeuille boursier contre un effondrement des cours, et

ainsi acheter une « option » qui fournit la garantie d’un prix

de rachat minimum de ses actions. De nombreux produits de

ce type sont en fait, de façon parfois cachée, déjà disponibles

pour le grand public, et portent le nom d’investissements à

capital garanti. Dans ce cas, la valeur minimale garantie est

le capital initial. On peut aussi vouloir s’assurer contre une

hausse, par exemple une entreprise française devant payer des

factures en dollar peut vouloir se prémunir contre une

appréciation future de cette devise. Quel est le montant

raisonnable de la prime d’assurance à laquelle doit consentir

l’acheteur de l’option ? Le vendeur d’option peut-il suivre une

stratégie optimale d’achat et de vente du « sous-jacent »

(c’est-à-dire l’objet sur lequel porte l’option) de façon à

minimiser son risque ? Il est clair que la réponse à ces deux

questions nécessite une description de la dynamique du sous-

jacent, un modèle probabiliste de son évolution future. Black

et Scholes, en 1973, proposent une solution complète du

problème en reprenant le modèle de Bachelier, un peu modifié :

ils supposent que le logarithme du prix, plutôt que le prix lui-

même, effectue un mouvement brownien. On observe en effet à

long terme une croissance exponentielle du prix des actifs fin-

anciers, même si à court terme les deux modèles sont très

similaires. Autrement dit, Black et Scholes écrivent, en repre-

nant les notations de l’encadré 1 :

v=σ +m,

où σest la « volatilité », une variable aléatoire centrée de

variance unité et mla rentabilité moyenne.

La formule qu’ils obtiennent exprime la valeur de l’option

comme la moyenne du profit potentiel de l’acheteur, ce qui

paraît raisonnable. Cette moyenne est d’autant plus grande

que la volatilité σdu sous-jacent, sa propension à fluctuer, est

grande : les marchés d’options sont ainsi des marchés où

s’échangent des anticipations de volatilité future. Cependant,

la moyenne du profit potentiel est prise non pas avec la

« vraie » probabilité du mouvement brownien, mais avec une

probabilité « décalée », obtenue en retranchant la rentabilité

moyenne du sous-jacent, c’est-à-dire en imposant m=0.

Autrement dit, et assez curieusement, le prix de l’option ne

dépend pas de la tendance moyenne à la hausse ou à la baisse

du sous-jacent ! Ce décalage provient de la stratégie de

couverture que suit le vendeur d’options, qui corrige son bilan

financier de manière à compenser exactement l’effet de la ten-

dance moyenne. Black et Scholes trouvent d’ailleurs que la

stratégie optimale est parfaite, dans le sens où le vendeur ne

prend aucun risque ! Ce résultat est intimement lié à la nature

supposée gaussienne des fluctuations, et à la limite (irréaliste)

du temps continu, où la fréquence des transactions tend vers

l’infini. En présence des effets non gaussiens décrits dans

l’encadré 1 (queues de distributions, volatilité stochastique),

la possibilité de trouver une stratégie parfaite disparaît, et il

subsiste un risque résiduel, dont nous avons montré qu’il est

en pratique très important. Le prix lui-même subit des modifi-

cations, que les opérateurs du marché implémentent en injec-

tant dans la formule de Black et Scholes non pas la vraie

volatilité σmais une volatilité effective qui varie en fonction

de l’échéance de l’option et du « prix d’exercice » (le seuil à

la hausse ou à la baisse qui définit l’option). Tracée en fonc-

tion du prix d’exercice, cette volatilité a souvent une forme

parabolique ; on parle alors, dans les salles de marché, de

« smile » de volatilité. Nous avons montré que la forme

précise de ce smile peut être reproduite en prenant en compte

de manière quantitative les effets non gaussiens décrits dans

l’encadré 1, en particulier les corrélations à longue portée de

la volatilité.

dont l’occurrence mettait gravement

en défaut le modèle de Bachelier (très

légèrement amendé) utilisé alors. Le

développement exponentiel des mar-

chés dits dérivés, comme les marchés

d’options (encadré 2), où les effets de

levier peuvent amplifier à l’extrême

les mouvements de hausse ou de

baisse, a rendu inévitable une réfle-

xion approfondie sur le risque finan-

cier, son origine et sa calibration, afin

de construire des instruments effi-

caces de mesure de la « sismicité »

des marchés financiers.

A cette motivation instrumentale

s’ajoute une motivation intellec-

tuelle, qui est celle du développement

d’une modélisation statistique quan-

titative des comportements humains

dont nous avons parlé plus haut. Les

marchés financiers, bien que (ou

peut-être parce que) réducteurs, sont

pour cela un magnifique terrain d’ex-

périmentation, car ils constituent sans

doute la source la plus abondante de

données qui documentent de manière

quantitative une activité humaine : on

dispose des variations de prix de

dizaines de milliers d’instruments

financiers, parfois au cours de plu-

sieurs siècles, comme pour le blé.

Que nous apprennent ces mouve-

ments erratiques de hausse et de

baisse sur les comportements des

individus qui en sont la cause mais

dont les conséquences collectives les

dépassent ? D’autres activités humai-

nes sont de ce point de vue compa-

rables, comme le trafic routier et ses

fluctuations géantes, ou le réseau des

connexions sur Internet. Même si la

masse de données disponibles n’est

pas (encore) comparable à celle des

marchés financiers, le développe-

ment de modèles de comportements

de con-ducteurs issus de la physique

statistique a connu un essor considé-

rable ces dernières années : le réseau

autoroutier allemand est entièrement

géré par un modèle de ce type ! Il y a

donc fort à parier que les outils et les

concepts développés pour com-

prendre la statistique des marchés

financiers auront une portée beau-

coup plus vaste.

Revenons sur le modèle de Bache-

lier et sur ses limitations. Bachelier

87

Systèmes dynamiques

1900 1920 1940 1960 1980 2000

1.5

2.5

3.5

4.5

Indice DowJones

1900 1920 1940 1960 1980 2000

1

0

1

2

3

Mouvement de Bachelier

Figure 1 - Deux chroniques de prix, l’une réelle (figure du haut), l’autre synthétique (figure du bas). La

chronique réelle correspond à l’indice Dow-Jones pendant le XXesiècle, en coordonnées semi-logarith-

miques. Les flèches indiquent deux grands krachs : 1929 et 1987. La chronique artificielle est obtenue

en suivant la prescription de Bachelier : chaque mouvement est une variable aléatoire gaussienne, tota-

lement indépendante du passé, mais de valeur moyenne non nulle, afin de reproduire l’effet de crois-

sance séculaire de l’économie qui apparaît sur la chronique réelle.

1900 1920 1940 1960 1980 2000

40

20

0

20

40

Indice DowJones

1900 1920 1940 1960 1980 2000

1000.0

500.0

0.0

500.0

1000.0

Mouvement de Bachelier

Figure 2 - Autre représentation des données de la figure 1 : au lieu du prix, on trace ici la variation

relative journalière des prix en fonction du temps, pour le Dow-Jones (en %) et pour le mouvement de

Bachelier (unités arbitraires). On discerne clairement, dans les données réelles, les variations intermit-

tentes de volatilité.

88

fait une hypothèse minimale : si le

prix reflète un équilibre entre ache-

teurs (qui pensent que le cours va

monter) et vendeurs (qui pensent

qu’il va descendre), ce prix est tel

que l’espérance (c’est-à-dire la

valeur moyenne attendue) du prix de

demain est égale au prix actuel.

Bachelier écrit : Les opinions

contradictoires relatives à ces varia-

tions se partagent si bien qu’au

même instant les acheteurs croient à

la hausse et les vendeurs à la baisse,

et, plus loin : Il semble que le mar-

ché ne doit croire à un instant donné

ni à la hausse ni à la baisse puisque,

pour chaque cours coté, il y a autant

d’acheteurs que de vendeurs. Autre-

ment dit, l’accroissement de prix

entre aujourd’hui et demain est une

variable aléatoire imprédictible. Le

prix est donc la somme de ces

accroissements aléatoires. Or, la

somme d’un grand nombre de

variables aléatoires est, moyennant

des hypothèses peu restrictives, une

variable aléatoire dite gaussienne,

c’est-à-dire dont la distribution est

donnée par la loi normale de

Laplace-Gauss, et dont l’écart-type

croît comme la racine carrée du

temps qui s’écoule. Le processus

statistique ainsi construit est celui du

mouvement brownien. L’objet obtenu

est universel, dans le sens où il ne

dépend pas de la distribution particu-

lière des accroissements élémen-

taires. Un exemple d’une chronique

fictive, engendrée numériquement à

partir de la prescription de Bachelier,

est donné en figure 1, et comparé

avec la chronique de l’indice Dow-

Jones de la bourse de New-York

depuis le début du siècle. Au premier

coup d’œil, les caractéristiques gros-

sières de ces deux graphiques se res-

semblent et notamment, de manière

surprenante, avec l’apparition sur la

chronique simulée de périodes rela-

tivement longues où le prix fictif

semble être sur une tendance haus-

sière ou sur une tendance baissière.

Ces « tendances » ne correspondent

évidemment à aucune explication

économique rationnelle, et à aucune

possibilité de prévision. Elles ne

sont que le reflet du hasard, qui

prend cependant, dans le cas du

mouvement brownien, une forme

très particulière : en effet, les hausses

peuvent durer si longtemps que la

durée moyenne d’une période faste

(ou défavorable) est infinie !

Une différence majeure apparaît

cependant lorsque l’on observe les

deux graphes de la figure 1 plus

attentivement : plusieurs disconti-

nuités apparaissent clairement sur le

cours réel, correspondant aux grands

krachs du siècle (celui de 1929 par

exemple et la grande dépression qui

en a résulté, ou celui de 1987). Le

processus de Bachelier, quant à lui,

est continu ; aucune grande variation

n’est observée. Cela est une pro-

priété de la loi normale de Laplace-

Gauss, qui décroît si vite lorsque

l’on s’écarte du centre que les évé-

nements extrêmes ont une probabi-

lité quasi nulle de se produire. Dans

le monde de Bachelier, le krach de

1987 n’aurait jamais dû se produire,

même si la bourse avait existé depuis

le début de l’univers. La reconstruc-

tion empirique de la loi de distribu-

tion des variations de prix fait appa-

raître une queue dite de Pareto

(encadré 1), c’est-à-dire une lente

décroissance en loi de puissance de

la probabilité des extrêmes. Cette

loi, observée par Pareto à la fin du

XIXesiècle sur la répartition des for-

tunes ou des revenus, est apparue

depuis dans de nombreux contextes :

fluctuations financières, amplitudes

des tremblements de terre, taille des

mégapoles, recettes d’exploitation

des films... Une autre représentation

permet de comprendre la différence

profonde entre le modèle de Bache-

lier et la réalité des marchés : au lieu

de tracer le prix au cours du temps,

on peut tracer les variations journa-

lières des prix, à la fois pour l’indice

Dow-Jones et pour l’histoire fictive

de Bachelier (figure 2). On observe

dans le cas réel non seulement des

« pics » d’amplitude correspondant

à de fortes hausses ou de fortes

baisses, mais aussi une tendance à

l’agrégation de ces pics dans le

temps. Autrement dit, il apparaît

clairement des périodes troublées,

d’agitation intense, entrelacées par

des périodes plus calmes, de faible

activité : l’évolution des marchés se

fait par bouffées intermittentes de

volatilité. De telles structures n’ap-

paraissent pas dans le diagramme

sans relief du mouvement de Bache-

lier, qui correspond à une dynamique

modérée, sans à-coups, un hasard

sans surprises. Il est intéressant de

souligner les similarités frappantes

entre la texture statistique des fluc-

tuations financières et celle du

champ de vitesse d’un écoulement

turbulent. Comme pour les marchés,

un écoulement turbulent (par

exemple celui produit dans la grande

soufflerie de Modane) est intermit-

tent : il se structure en régions

« laminaires » (où l’écoulement est

relativement régulier et où la dissi-

pation d’énergie est faible) entrecou-

pées par des régions fortement dissi-

patives. Ainsi, toutes les méthodes

récentes d’analyse de signaux chao-

tiques (comme la transformée en

ondelettes) qui ont permis des pro-

grès considérables dans la compré-

hension de la turbulence hydrodyna-

mique et le développement de

modèles statistiques nouveaux, trou-

vent une application naturelle dans

l’étude des fluctuations financières

(encadré 1).

Lente décroissance de la probabi-

lité des variations extrêmes, persis-

tance des périodes de forte volati-

lité ; au-delà de cette description

qualitative, on peut définir des

mesures quantitatives de ces effets,

et comparer les résultats obtenus

pour différents marchés et diffé-

rentes époques pour conclure à cette

grande universalité mentionnée en

introduction (encadré 1). Celle-ci

suggère un mécanisme élémentaire

commun, peut-être relié à certains

invariants fondamentaux de la psy-

chologie humaine : appât du gain et

peur de perdre, manque d’informa-

tions, esprit grégaire et mimétisme,

apprentissage par essai et erreur...

notions qu’il faut tenter de quantifier

précisément. Plusieurs modèles,

pour lesquels l’un ou l’autre de ces

6

6

7

7

1

/

7

100%