Chapitre I : Les processus d`acquisition Pavlov et le

Chapitre I : Les processus d’acquisition

I. Pavlov et le conditionnement classique (répondant, de type i)

Pavlov est un physiologiste qui travaillait sur la digestion (prix Nobel de physio).

Nourriture - > salivation

SI RI

Cloche + nourriture -> salivation

SN SI

Cloche -> salivation

SC RC

Extinction : disparition de la RC suite au retrait du si. Il est nécessaire d’associer SI+ SC pour que la

RC soit maintenue. Le si est appelé stimulus renforçateur classique.

Généralisation : processus par lequel les attributs d’un élément sont étendus à d’autres éléments. Il

y a généralisation du stimulus et généralisation de la réponse.

S1

S2 => r

S => r1

r2

Discrimination: inverse. Deux stimuli proches entrainent deux réponses très différentes ou deux

stimuli très différents entrainent deux réponses proches.

Lorsqu’ils sont mal mis en place, ces deux processus peuvent entrainer l’apparition de troubles

appelés névrose expérimentale. Si on associe un carré à de la nourriture et un rond à un choc

électrique, et que l’on présente une forme intermédiaire entre le carré et le rond, il y aura une

réaction névrotique.

Conditionnement de 2ème et 3ème ordre

Frolov : après un premier conditionnement, on associe un sn au SC (par exemple un carré noir à la

cloche) qui finira par entrainer la RC sans qu’il ne soit jamais directement associé au SI.

Ce mécanisme permet d’expliquer certaines phobies ou l’apprentissage de l’écriture (langage =

conditionnement de 1er ordre, écriture conditionnement de 2eme ordre).

Miller et Konorski : ils conditionnent en utilisant des stimuli proprioceptifs. Ex : flexion de la patte

du chien + nourriture => salivation. Au bout d’un moment, le chien fléchit la patte spontanément.

II. Conditionnement de 2ème type (skinérien, instrumental, opérant).

Skinner est l’héritier de Watson et Thorndike.

Dans le manifeste behavioriste, Watson définit le comportement comme l’objet d’étude de la

psychologie. Il faut donc supprimer l’introspection et voir la psychologie comme une branche

objective et expérimentale des sciences de la nature. C’est une psychologie des observables,

quantifiable, qui permet un accord inter-observateur. On peut prédire et contrôler les

comportements de la vie quotidienne.

Thorndike travaille sur la capacité d’adaptation des chats et écrit que tout comportement est

fonction de ses conséquences, c’est la loi de l’effet. Si la conséquence est positive, le comportement

est reproduit. Si elle est négative, le comportement disparait. La cause du comportement est alors

sa conséquence. Pour lui l’objet d’étude de la psychologie est la fréquence d’apparition d’un

comportement en fonction de ses conséquences. La fréquence d’apparition permet de bien

opérationnaliser le comportement, en permettant de bien voir les changements.

Thorndike s’intéresse à des petites unités comportementales qu’il appelle des opérants (= unité

minimale de comportement dont on peut étudier les modifications).

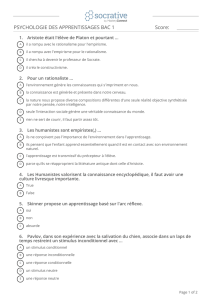

Augmente la fréquence du

comportement

Diminue la fréquence du

comportement

Présenter un stimulus

Renforcement positif

Punition positive

Evitement passif

Retirer un stimulus

Renforcement négatif

Punition négative

Ajourner un stimulus

Renforcement négatif

Evitement actif

Punition négative

Aucune conséquence

Comportement superstitieux

Extinction

Une procédure qui fait augmenter la fréquence d’apparition du comportement est un

renforcement.

Une procédure dans laquelle est présenté un stimulus est positive, une procédure dans laquelle un

stimulus est ajourné ou retiré est négative.

Une stimulation est appétitive si sa présentation augmente la fréquence d’apparition du

comportement ou son retrait la diminue.

Une stimulation est aversive si sa présentation diminue la fréquence d’apparition du

comportement ou si son retrait l’augmente.

L’agent renforçateur est le facteur à l’origine du renforcement, c’est la présentation d’un stimulus

appétitif ou le retrait d’un stimulus aversif.

L’agent punitif ou punisseur fait référence à la présentation d’une stimulation aversive ou au

retrait d’une stimulation appétitive.

Ce sont des agents modulateurs.

Extinction : procédure qui entraine la diminution de la fréquence d’apparition d’un comportement

suite à l’absence de présentation de l’agent renforçateur.

Comportement superstitieux : comportement dont la fréquence d’apparition augmente alors qu’il

n’est suivi d’aucune conséquence.

Catania (1997)

Les procédures de renforcement et de punition sont symétriques.

Pour Skinner la punition était peu efficace car temporaire. Or le renforcement est temporaire

aussi. Pour supprimer un comportement, il faut le punir mais aussi supprimer l’agent renforçateur

qui en était la cause. Pour supprimer un comportement, on peu aussi renforcer le comportement

antagoniste. La punition est utilisée pour faire cesser le comportement rapidement.

Burkhand (1978)

Ils quantifient le temps que passent des enfants sur 3 jeux différents. Ils font deux groupes et

tentent de faire changer les habitudes des enfants en les punissant pour un groupe, en les

renforçant pour l’autre.

Les effets sont les mêmes pour les deux groupes, seulement les sentiments associés aux procédures

sont très différents.

Herman, Azrin (1964)

Appui sur un levier peu soit donner des cigarettes, soit envoyer un son aversif.

Stimulus primaire : stimulus soit essentiel à la survie de l’organisme, soit de nature à provoquer des

lésions sur celui-ci. C’est un si, mais tout si n’est pas forcément primaire.

Ex : eau, nourriture, abri, choc électrique...

Stimulus secondaire : ce sont tous les autres stimuli. Ils acquièrent leur pouvoir par association à

un stimulus primaire ou à un autre stimulus secondaire. Ils n’amènent pas rapidement à un état de

satiété. Ils doivent être distribués rapidement après le comportement.

Stimulus secondaire généralisé : ex l’argent. Il est stockable et interchangeable.

Les stimuli secondaires acquièrent leurs pouvoirs par association par conditionnement classique à

un stimulus primaire.

Stimulus discriminatif : stimulus en présence duquel le comportement émis a une forte probabilité

d’être modulé par ses conséquences. Il sélectionne le bon comportement au bon moment. Le

comportement d’évitement nécessite un stimulus discriminatif.

Stimulus discriminatif + comportement + conséquence = contingence à 3 termes de Skinner.

Ici aussi, c’est un conditionnement classique qui confère son pouvoir au stimulus discriminatif.

Ex : téléphone qui sonne => je décroche

Le feu est rouge => je m’arrête

III. Les chaînes de comportement

Modeler c’est renforcer des approximations de la réponse. Pour modeler, on expose l’organisme au

stimulus appétitif primaire. Ensuite on lui présente quand il émet un comportement général, puis

un comportement plus précis, puis un autre encore plus précis… le stimulus renforce le

comportement précèdent et sélectionne le comportement suivant, il est donc stimulus secondaire

du 1er comportement et stimulus discriminatif du second.

On distingue deux méthodes pour instaurer une chaine de comportement :

- Une méthode régressive, pour les organismes simples ou ne possédant pas le langage : on

fait acquérir les unités comportementales les plus proches du stimulus primaire en 1er.

IV. les programmes de renforcement

Un programme de renforcement renvoie à la façon dont les agents renforçateurs sont présentés au

sujet.

Programmes

Fixe

Variable

Raison (rapport)

Rf

Rv

Intervalle

If

Iv

1. Les programmes de raison

Déf : programme dans lequel l’arrivée de l’agent renforçateur est déterminée par le nombre de

réponses produites par le sujet. Les programmes de raison peuvent être :

- Fixe = l’agent renforçateur arrive toutes les x secondes.

- Variable = l’agent renforçateur arrive toutes les n réponses. Ex : un démarcheur à domicile

parvient à vendre au n°1, mais pas au n°6 / joueur sur machines à sous.

Plus le programme de raison est élevé, plus le temps de réponse est élevé.

2. Les programmes d’intervalle

Déf : le temps s’écoule entre deux agents renforçateurs, et module le comportement. Les

programmes d’intervalle peuvent être :

- Fixe = l’agent renforçateur est distribué systématiquement tous les jours, semaines, mois…

toutes les x unités de temps. Ex : chez les étudiants, les comportements changent à l’approche

des examens.

- Variable = l’intervalle de l’arrivée successive entre deux agents renforçateurs n’est pas

prédictible. Ex : les interrogations surprises (il faut qu’elles soient régulières quand même).

Dans le programme d’iv, plus l’intervalle est élevé, moins le taux de réponse est élevé.

Ces programmes sont importants car ils vont, en plus de fournir une allure générale, induire des

résistances à l’extinction

. Voici deux règles les concernant :

- Les programmes fixes s’étayent plus rapidement que les programmes variables. Ex : il faut faire

plusieurs essais afin de s’assurer qu’une ampoule est belle et bien grillée dans un immeuble

vétuste où les dysfonctionnements sont courants, tandis que chez nous, on comprendra tout de

suite que cette ampoule est grillée.

- A l’intérieur même d’un programme, plus la raison (ou l’intervalle) est élevée, plus l’extinction

sera longue.

Rq : on peut donc arriver à faire produire des comportements très stables sans avoir recours à

beaucoup d’AR.

3. Le programme DRL (débit de réponse lent) – differential low rate of response

L’agent renforçateur n’est délivré que si l’organisme s’abstient de répondre pendant une unité de

temps x.

6

6

7

7

8

8

9

9

10

10

11

11

1

/

11

100%