Un exemple: l`algorithme du Perceptron pour la - Fun-Mooc

Un exemple: l’algorithme du

Perceptron pour la

classification

Classification

Séparateurs affines

Le Perceptron

mono-couche

Stéphan Clémençon

Classification binaire

I(X,Y)couple de v.a. de distribution Pinconnue

IY∈ {−1,+1}est une étiquette binaire

IX∈Rdmodélise une observation permettant de prédire Y

Objectif

Construire g:Rd→Rde façon à minimiser l’erreur de

classification

L(g) = P{Y6=g(X)}

Exemples

IDiagnostic médical

ICiblage marketing

IRisque de crédit

Fondamentaux pour le Big Data c

Télécom ParisTech 1/7

Un exemple: l’algorithme du

Perceptron pour la

classification

Classification

Séparateurs affines

Le Perceptron

mono-couche

Stéphan Clémençon

Règle optimale

IProbabilité a posteriori

∀x∈Rd, η(x) = P{Y= +1|X=x}

IRègle naïve de Bayes

∀x∈Rd,g∗(x) = 2I{η(x)>1/2} − 1

Risque minimum

L(g∗) = min

gL(g)

IL’erreur L(g)est inconnue... comme P!

Fondamentaux pour le Big Data c

Télécom ParisTech 2/7

Un exemple: l’algorithme du

Perceptron pour la

classification

Classification

Séparateurs affines

Le Perceptron

mono-couche

Stéphan Clémençon

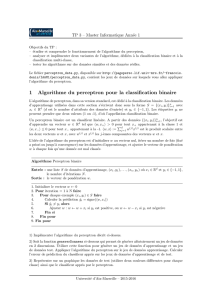

Apprentissage statistique

Minimisation du Risque Empirique

IDonnées observées

(X1,Y1). . . , (Xn,Yn)

IOn cherche à concevoir un algorithme qui "minimise" le

risque empirique

b

Ln(g) = 1

n

n

X

i=1

I{Yi6=g(Xi)}

sur une collection "pas trop complexe" de règles G

IMinimiseur du risque empirique sur G

b

gn=arg min

g∈G b

Ln(g)

Fondamentaux pour le Big Data c

Télécom ParisTech 3/7

Un exemple: l’algorithme du

Perceptron pour la

classification

Classification

Séparateurs affines

Le Perceptron

mono-couche

Stéphan Clémençon

Minimisation du Risque Empirique -

Propriétés

L(ˆ

gn)−L(g∗)≤2 sup

g∈G

|Ln(g)−L(g)|

+inf

g∈G L(g)−L∗

Contrôle de la complexité :

E"sup

g∈G

|Ln(g)−L(g)|≤ CrV

n#

si la dimension de Vapnik-Chervonenkis de Gest finie, égale à

V.

Fondamentaux pour le Big Data c

Télécom ParisTech 4/7

Un exemple: l’algorithme du

Perceptron pour la

classification

Classification

Séparateurs affines

Le Perceptron

mono-couche

Stéphan Clémençon

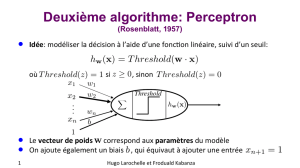

Hyperplans séparateurs

IOn cherche à séparer l’espace d’entrée Rden deux régions

par un hyperplan affine :(w, θ)∈Rd×R

Hw,θ :tw·X+θ=0

IRègle associée : gw,θ(X) = sign(tw·X+θ)

Fondamentaux pour le Big Data c

Télécom ParisTech 5/7

6

6

7

7

1

/

7

100%