Diapositives du cours sur le test du chi2 File

Test du Chi 2

Stéphane Canu

M8 - Principes du traitement de l’information

June 2, 2016

Plan

1Il y a t’il une relation entre ces deux variables ?

2Exemple introductif : test d’une proportion

Cadre général

Comportement de l’échantillon dans le cas d’une pièce normale

La P-valeur

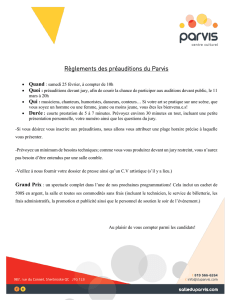

L’exemple des médiums

3Comparaisons de variables qualitatives : les test du χ2

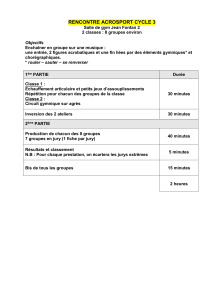

L’exemple des 3 jurys

La loi du χ2

Le test du χ2d’indépendance

Stéphane Canu (INSA Rouen - ASI) Test du Chi 2 June 2, 2016 2 / 29

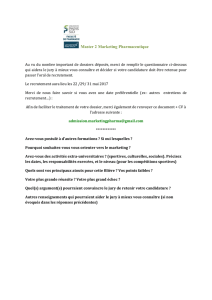

Tests Statistiques : pour quoi faire ?

sur 140 thèses en médecine :

118 utilisent une méthode statistique

87 présentaient des tests statistiques.

I53 tests du χ2

I33 tests de Student.

Le succès de ces 2 tests est dû à la question à laquelle ils répondent :

il y a t’il oui ou non une relation entre ces deux variables ?

deux variables qualitatives : test du χ2

ILes principales maladies sont elles les même à Rouen et à Montpellier ?

une variable qualitative et l’autre quantitative : Analyse de la variance

Ices deux variétés ont elles le même rendement ?

deux variables quantitatives : test de Student

Iy a t’il une relation entre la concentration d’ozone et la température ?

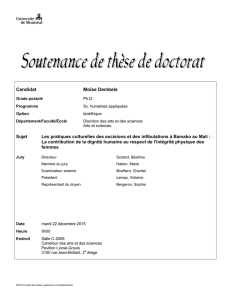

Exemple introductif : test d’une proportion

La question : les hypothèses H0:la pièce est normale

H1:la pièce est biaisée

sur 1000 tirage, j’ai observé :

502 fois pile avec la pièce 1

763 fois pile avec la pièce 2

521 fois pile avec la pièce 3

Exemple introductif : test d’une proportion

La question : les hypothèses H0:la pièce est normale

H1:la pièce est biaisée

Le modèle : observation et reformulation

Afin de pouvoir décider, nous allons observer l’échantillon X1, ..., Xni.i.d.

de loi parente B(p)(une loi de Bernouilli de paramètre p).

H0:la pièce est normale ⇔p=1

2

H1:la pièce est biaisée ⇔p6=1

2

Une règle de décision raisonnable est la suivante : si la fréquence de

« pile » est proche de 1

2nous allons décider la pièce est normale.

Embrouille

Mais même si p=1

2, il est toujours possible d’observer nfois pile...

Comment décider raisonnablement dans ce contexte ?

La question est donc de savoir comment contrôler l’erreur

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

1

/

30

100%