Analyse Discriminante Linéaire et Analyse Discriminante Quadratique

M2 de Statistique, Université Pierre et Marie Curie

Bertrand MICHEL

Notes de cours

Analyse Discriminante Linéaire

Analyse Discriminante Quadratique

On dispose d’une population composée de ksous-populations définies par une variable catégorielle

àkmodalités que l’on note y. Quitte à renommer les classes, on suppose que l’ensemble des moda-

lités est {1, . . . , k}. Chaque individu de la population est aussi décrit par des variables explicatives

x1,...,xj,...,xp.

1 Nuages et décomposition de la variance

Dans cette section, on suppose que les variables explicatives x1,...,xj,...,xpsont toutes de type

continu. Soit Mla matrice associée au nuage des individus mesurés sur chacune des pvariables expli-

catives :

M=

x1

1. . . xp

1

.

.

..

.

..

.

.

x1

n. . . xp

n

.

On appelle nuage de Rple n-uplet des observations (x1,...,xn), où chacun des vecteurs xide Rpest

un point du nuage. Par abus on notera aussi Mle nuage. Dans la suite on supposera toujours que le

nuage est centré : 1

nX

i=1...n

xj

i!j=1...p

= 0.

La matrice de variance-covariance des variables du nuage Mest définie par :

S:= hcov(xj,xj0)i1≤j,j0≤p=1

nM0M=1

n

n

X

i=1

xix0

i

1.1 Géométrie d’un seul nuage

Avant de décrire la géométrie des knuages, considérons le cas d’un seul nuage en laissant de côté

pour le moment le problème de la classification supervisée. L’analyse en composantes principales (voir

le cours dédié) nous dit que l’orientation du nuage Mpeut être décrite à partir de la décomposition en

valeurs propres de la matrice S. Plus précisément, la première direction propre (pour la plus grande

valeur propre) correspond à la direction de Rppour laquelle les données du nuage Msont le plus

dispersée. La seconde direction propre donne la direction orthogonale à la première pour laquelle les

données sont le plus dispersée, etc...

1.2 Géométrie des knuages

Nous supposons désormais que knuages sont observés : la variable yprésente kmodalités distinctes.

Pour simplifier les notations, les individus sont numérotés de telle sorte que les premiers individus sont

ceux du groupe 1, puis ceux du groupe 2 :

M=

x1

1. . . xp

1

.

.

..

.

..

.

.

x1

n. . . xp

n

=

M(1)

.

.

.

M(k)

1

où M(`)est la matrice des données du groupe `. Les kgroupes induits par la variable catégorielle y

définissent knuages dans l’espace Rpdes variables explicatives. On supposera de plus que k≤p<n.

On note :

— I`la liste des individus du groupe `,

—n`l’effectif de la sous-population `,

—g`le centre de gravité du groupe `:g`= (g1

`, . . . , gp

`)0avec

gj

`=1

n`X

i∈I`

xj

i.

1

1

1

1

1

1

1

1

1

g1

2

2

2

2

2

2

22

g2

3

3

3

3

3

3

3

3

3

g3

¯g

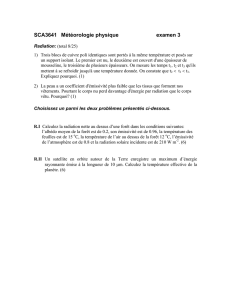

Chacun des knuages M(`)a une orientation Rpqui peut être décrite par sa matrice de variance-

covariance S`(c.f. paragraphe précédent) où

S`:= 1

n`

(M(`)−en`g0

`)0(M(`)−en`g0

`)

=1

n`X

i∈Il

(xi−g`)(xi−g`)0.

où ekdesigne le vecteur (1,...,1)0de Rk. On définit alors la matrice de variance intra-classe par

W:= X

`=1...k

n`

nS`p×p

Cette matrice est la moyenne pondérée des matrices de variance-covariance des knuages. Elle corres-

pond donc à “l’orientation moyenne” des knuages. La première direction principale de Wcorrespond à

la direction selon laquelle les nuages sont le plus étalés, etc ... En général, la matrice West inversible,

ce que l’on supposera dans la suite.

g1

Premiere direction principale de W

Seconde direction principale de W

g3

g2

Figure 1 – Trois nuages avec des orientations comparables.

Soit Gla matrice k×pdu nuage des centres des knuages. Le centre de gravité ¯

gde Gpondéré

des n`vérifie

¯

g:= 1

nX

`=1...k

n`g`=¯

x= 0.

La matrice de variance-covariance Bdes kcentres de gravité pondérés par les nlest appelée matrice

2

de variance inter-classes :

B:= 1

nX

`=1...k

n`(gj

`−¯gj)(gu

`−¯gu)!1≤j,u≤k

=G0Diag(n1

n,...,nk

n)Gcar ¯gj= ¯gu= 0

=1

nX

`=1...k

n`g`g0

`p×p

Puisque P`=1...k n`g`= 0, le nuage des glest contenu dans un sous-espace vectoriel de Rpde dimension

k−1et la matrice Bn’est pas inversible. La matrice Bdécrit la géométrie du nuage des kcentres de

gravité.

Les variances intra et inter classes permettent de décomposer la variance totale du nuage :

Proposition 1. La variance du nuage Mse décompose en variance intra-classe et variance inter-

classes :

S=W+B.

2 Analyses discriminantes linéaire et quadratique

On suppose dans cette section que les variables aléatoires Xjsont toutes de type continu.

2.1 Modélisation

On suppose que les variables en jeu sont des variables aléatoires notées Yet Xj, dont on observe des

réalisations xj

1,...xj

net y1, . . . , yn. Supposons de plus que la distribution de Yadmet k≥2modalités.

Pour chacune de ces modalités on considère la loi conditionnelle de X= (X1, . . . , Xp)sachant Y=`

et on suppose que cette loi conditionnelle admet une densité f`pour la mesure de Lebesgue sur Rp

(que l’on note ici λp). On considère

—π`=P(Y=`): la probabilité a priori d’appartenance au groupe `.

—P(Y=`|X=x): la probabilité a posteriori d’appartenance au groupe `.

Proposition 2. Sous les hypothèses précédentes :

1. La distribution du vecteur aléatoire (X, Y )admet la densité

f:Rp× {1,...k} → R+

(x, y)7→ Pk

`=1 f`(x)π` y=`

par rapport à la mesure λp⊗δk, où δkdésigne la mesure ponctuelle d’atomes {1, . . . , k}.

2. La distribution du vecteur Xadmet la densité suivante par rapport à λp:

fX=

k

X

`=1

π`f`.

3. Pour tout `∈ {1...,k}, la probabilité a posteriori d’appartenance au groupe `vérifie :

P(Y=`|X=x) = π`f`(x)

Pk

s=1 πsfs(x)(1)

Les méthodes d’analyse discriminante linéaire et quadratique sont des méthodes d’analyse discrimi-

nantes de type décisionnel. Pour prédire la variable Yà partir des variables X1, . . . , Xp, il est naturel

de s’appuyer sur les probabilités a posteriori. Plus précisément, la règle bayésienne d’attribution

consiste à attribuer une observation au groupe le plus probable pour celle-ci , c’est-à-dire celui pour

lequel la probabilité a posteriori est maximale, ce qui équivaut d’après la relation (1) à choisir

ˆ

Y(x) = Argmax

`=1...k

f`(x)π`.

Cependant, en pratique ces quantités sont inconnues et il faut les estimer à partir des observations

disponibles. Pour cela on proposera différentes hypothèses de modélisation sur la loi de Xsachant Y.

3

Hypothèse gaussienne. Pour modéliser le fait que les observations de chaque groupe `sont orga-

nisés en “clusters”, nous allons supposer que la loi du vecteur X= (X1, . . . , Xp)peut être modélisée

par une loi normale multivariée de densité sur Rp:

x∈Rp, f`(x) = 1

(2π)p/2√det Σ`

exp −1

2(x−µ`)0Σ−1

`(x−µ`).

Comme dans le cas de la régression linéaire, cette hypothèse n’est jamais rigoureusement vérifiée pour

des données réelles. Cependant, cette modélisation est souvent suffisamment souple pour approcher

efficacement la véritable loi des données (que l’on ne connaît évidemment pas en pratique).

ADL et ADQ. Si toutes les matrices de variance-covariance sont égales : Σ1=··· =Σk=Σ, il

s’agit de l’analyse discriminante linéaire (ADL) :

Au contraire, si les matrices de variance-covariance ne sont pas supposées égales, il s’agit de l’analyse

discriminante quadratique (ADQ) :

2.2 Analyse Discriminante Linéaire (ADL)

Dans le but de déterminer les frontières entre les zones d’attribution, on considère le logarithme

des rapports entre probabilités a posteriori : x∈Rp

log P(Y=`|X=x)

P(Y=h|X=x)= log π`

πh

+ log f`(x)

fh(x)

= log π`

πh−1

2(x−µ`)0Σ−1(x−µ`) + 1

2(x−µh)0Σ−1(x−µh)(2)

= log π`

πh−1

2µ0

`Σ−1µ`+1

2µ0

hΣ−1µh+x0Σ−1(µ`−µh)

On définit une fonction discriminante s`pour chaque groupe `par :

x∈Rp, s`(x) := x0Σ−1µ`+ log π`−1

2µ0

`Σ−1µ`.

La règle de Bayes consiste ici à affecter une observation xau groupe y(x)de score maximum :

y(x) = argmax

`=1...k

s`(x).

Ces fonctions discriminantes (ou scores) sont linéaires en x, d’où l’appellation d’analyse discriminante

linéaire.

4

Inférence. En pratique, les quantités Σ,µ1,...,µket π1, . . . , πksont inconnues. On peut cependant

les estimer par la méthode du maximum de vraisemblance :

Proposition 3. En supposant que la loi conditionnelle de (X|Y=`)est celle d’une loi normale

multivariée p-dimensionnel dont la matrice de variance-covariance est inversible et ne dépend pas de `

(hypothèse ADL), les estimateurs du maximum de vraisemblance de Σ,µ`et π`vérifient :

b

Σ=W=X

`=1...k

n`

nS`,ˆ

µ`=g`=1

n`X

i|yi=`

xiet ˆπ`=n`

n.

Remarque. On utilise aussi parfois l’estimateur sans biais de la matrice de variance-covariance

n

n−kW.

Attribution. La règle d’affection effective pour une observation xest finalement donnée par

ˆy(x) = argmax

`=1...k

ˆs`(x)

où

ˆs`(x) := x0W−1g`+ log n`

n−1

2g0

`W−1g`.

Cas de deux groupes. Si k= 2, l’espace R2est séparé en deux zones dont la frontière est l’hyperplan

affine d’équation

log n1

n2−1

2(g1+g2)0W−1(g1−g2) + x0W−1(g1−g2)=0

Zones de séparation. De façon plus générale, la zone de séparation entre les régions d’attribution

des classes `et hest la région B`,h ⊂Rpdéfinie par l’équation ˆs`(x) = ˆsh(x). Cette région B`,h est un

hyperplan affine car les fonctions discriminantes ˆs`sont linéaires :

11

1

1

1

1

1

1

1

1 1

2

2

2

2

2

2

2

2

2

2

22

3

33

33

33

3

3

3

2.3 Métrique de Mahalanobis et ADL

Si les probabilités a priori sont égales, l’égalité (2) montre que la règle d’attribution revient à

affecter une observation xiau groupe pour lequel la quantité (x−g`)0Σ−1(x−g`)est minimale.

Cette quantité peut être interprétée comme une distance pour une métrique particulière : la métrique

de Mahalanobis. Celle-ci est définie dans Rppar le produit scalaire

<u,v>

W:= u0W−1v.

Pour cette métrique, les points situés sur un ellipsoïde d’équation (x−gl)0W−1(x−gl) = csont tous

équidistants du point gl. Cette normalisation par W−1permet d’éviter que les directions relatives aux

5

6

6

7

7

8

8

1

/

8

100%