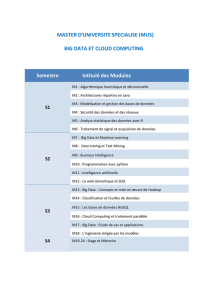

PROGRAMMME D`INTRODUCTION À LA SCIENCE DES DONNÉES

PROGRAMMME D’INTRODUCTION

À LA SCIENCE DES DONNÉES

2015

PUBLIC VISÉ ET PRÉREQUIS

Les modules oerts conviennent à toute

personne ayant une connaissance de

base en informatique ou en statistique

et des notions de programmation. Le

programme est destiné aux praticiens et

chercheurs.

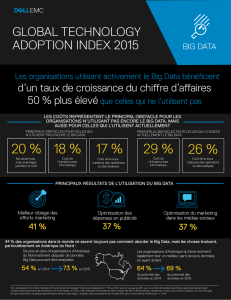

Les concepts et la formation transmis

dans ce programme permettent une

bonne compréhension du contexte des

masses de données, appelées aussi don-

nées massives ou plus communément

«big data», et du dé qu’elles présentent,

dé qui structure l’évolution des sciences

et de nombreux secteurs de l’économie.

Le programme proposé convient tant

aux professionnels en début de carrière

qu’aux managers conrmés ayant besoin

de comprendre ce domaine complexe et

ses applications.

PROGRAMMME

D’INTRODUCTION

À LA SCIENCE DES DONNÉES

Ce programme de formation est destiné

aux professionnels et aux managers et com-

prend des modules d’enseignement et des

travaux pratiques. Il traite des sujets les

plus actuels en science des données et en

big data, allant de la collecte, du stockage

et du traitement des données à l’analytique

et la visualisation, et présente également

une gamme d’applications concrètes et de

cas d’école issus des entreprises et des labo-

ratoires. Ce programme couvre un large

panorama et traitera de façon assez détail-

lée des méthodes et outils nécessaires pour

aborder les données massives.

LE PROGRAMME

La formation couvre 120heures d’ensei-

gnement (les vendredi et samedi en mai,

juin et juillet). Une journée typique

UNE FORMATION PROFESSIONNELLE À LA SCIENCE

DES DONNÉES ET AU «BIG DATA»

PROPOSÉE CONJOINTEMENT PAR LES DEPARTEMENTS DE MATHÉMATIQUES

APPLIQUÉES ET D’INFORMATIQUE DE L’ÉCOLE POLYTECHNIQUE

EXECUTIVE EDUCATION

© thinkstock

comprend un cours de 3h le matin suivi

de travaux pratiques de 3h (avec des tra-

vaux personnels) et une conférence d’une

heure donnée par un expert invité issu du

monde universitaire ou économique. Les

cours traitent largement des disciplines

ayant trait à la science des données : bases

de données, outils big data, prétraitement

des données, visualisation, analyse de

données et apprentissage automatique.

Un quart du programme est organisé

sous forme d’un Atelier Données, dans

lequel les participants vont travailler sur

des jeux de données réels, sur tout le cycle

de vie des données en utilisant les outils,

méthodes et connaissances qu’ils auront

acquis pendant les cours.

Le programme est organisé de la manière

suivante :

– Journée 1. Introduction à la science des

données. Écosystème du big data, cycle

de vie d’un projet de données/gestion

de projet, architecture informatique et

introduction au calcul distribué, ques-

tions de condentialité.

– Journée 2-4. Bases de données, outils

big data. Bases de données : SQL et

NoSQL, calcul distribué, cloud compu-

ting, Map Reduce et Hadoop, HIVE/

PIG, Spark.

– Journé es 5-7. Prétraitement des donnés

et visualisation. Nettoyage de données,

normalisation, sélection et création des

variables, réduction de dimensions,

exploration de données, visualisation

avec R et Python, visualisation par navi-

gateur, data mashup, data munging,

conception et ingénierie des variables.

– Journée 8. Atelier Données - première

partie. Introduction au jeu de données

et à l’objectif de l’atelier. Exploration et

sélection/ingénierie des variables.

– Journées 9-12. Analyse des données et

apprentissage automatique. Introduc-

tion à l’apprentissage, apprentissage

non supervisé, apprentissage supervisé

(régression et sélection des variables,

régression logistique, classication

naïve bayésienne, algorithme des k-voi-

sins les plus proches (KNN), machines

à vecteurs de support (SVM), arbres de

décision et réseaux de neurones), éva-

luation des modèles, surapprentissage,

sélection de modèles, méthodes d’en-

semble.

– Journées 13-14. Apprentissage automa-

tique pour les données non-tradition-

nelles. Filtrage collaboratif, fouilles du

Web, de graphes et de textes (« Web,

graph and text mining») recommanda-

tion, personnalisation, publicité sur le

web et marketing.

– Journées 15-18. Atelier Données - seconde

partie : Application des méthodes d’ap-

prentissage automatique aux résultats de

la première partie. Sélection de modèles

et méthodes d’ensemble.

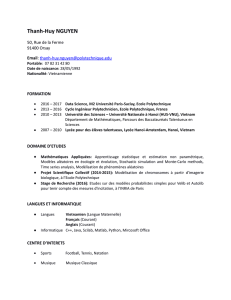

PERSONNEL ENSEIGNANT

S. Gaias (X-CMAP), C. Giatsidis

(X-LIX), B.Kegl (X, LAL), A. Papado-

poulos (X, Aristotle U. of essaloniki)

E.Le Pennec (X-CMAP), E.Matzner-Lo-

ber (X, U. Rennes) M. Vazirgiannis

(X-LIX).

Pour plus d’information, vous pouvez

consulter :

www.polytechnique.edu/bigdata/dssp/

Date limite de candidature :

22 mars 2015. Soumettez votre candida-

ture en ligne via le lien ci-dessus.

ÉCOLE POLYTECHNIQUE

91128 PALAISEAU CEDEX

www.polytechnique.edu

CONTACT

dssp@polytechnique.fr

TARIF

7 500 euros

LIEU

École polytechnique

DATES

Du 12 mai 2015

au 11 juillet 2015

1

/

4

100%