Analyse de données et classification bayésienne

Table des matières

1 Les données 4

1.1 Espace de représentation des données ................................ 4

1.2 Espace engendré par les variables .................................. 4

1.2.1 Variables numériques ..................................... 5

1.2.2 Variables ordinales et nominales .............................. 5

1.2.3 Espace des modèles ..................................... 6

1.3 Distances et similitudes dans les espaces de représentation .................... 6

1.3.1 Variables continues ...................................... 7

1.3.2 Variables booléenne (présence / absence) ......................... 7

2 Variables à 1 ou 2 dimensions 9

2.1 Description d’une variable ...................................... 9

2.1.1 Distribution .......................................... 9

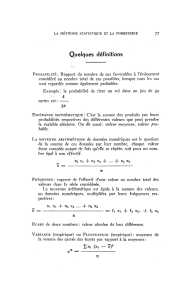

2.1.2 Valeurs centrales ....................................... 10

2.1.3 Paramètres de dispersion .................................. 11

2.1.4 Boîte à moustaches ...................................... 12

2.2 Description de deux variables .................................... 12

2.2.1 Nuage de points et régression linéaire ........................... 12

2.2.2 Corrélation linéaire et axe principal ............................ 14

3 Analyse en composantes principales 17

3.1 Exemple avec les mains ....................................... 17

3.2 Principe de la méthode (sans les mains) .............................. 17

3.3 Reformulation des données ...................................... 19

3.3.1 Matrice de données ...................................... 19

2

3.3.2 Matrices de description ................................... 19

3.3.3 Réduction des données .................................... 20

3.4 Recherche de sous-espaces optimaux ................................ 20

3.5 Inertie ................................................. 21

3.6 Description du nuage des individus ................................. 22

4 Décision bayésienne 24

4.1 Introduction et motivations ..................................... 24

4.2 Position du problème ......................................... 26

4.3 Stratégie bayésienne ......................................... 26

4.4 Exemple : cas gaussien ........................................ 29

3

Chapitre 1

Les données

Fortement inspiré du cours de F. Brucker, Analyse des données, 2007.

1.1 Espace de représentation des données

Ensemble fini Xd’objets noté x1,x2, . . . , x,y,z(taille N).

Pour analyser les objets dans X, il faut disposer d’informations permettant de les comparer ou de les

caractériser à l’aide de paramètres ou de descripteurs.

On plonge ainsi les objets dans un espace de représentation, engendré par les variables issues des descripteurs.

Les variables peuvent être numériques, ordinales ou nominales.

On parlera souvent d’individu pour caractériser les objets de Xet de caractères pour les variables associées.

Variable

?numérique : discrète (crédit sur un compte en centimes) ou continue (poids, taille).

?ordinale : ne retient que des comparaisons entre des valeurs (Je préfère x à y,x est plus intéressant

que y. . . ).

?nominale : ensemble de valeurs non comparables (catégorie socio-professionnelle, couleur, apparte-

nance politique). Comme cas particulier : les variables binaires (présen ce/absence d’un caractère ou

1/2 sexe à la sécurité sociale)

1.2 Espace engendré par les variables

Supposons que nos Nobjets soient décrits par un ensemble de pvariables. L’espace de représentation qui

leur sera associé sera le produit cartésien des ensembles engendrés par chaque variable. On a ainsi =Rp

lorsque les variables sont continues ; tandis dans dans les autres cas on peut poser =Np. Les variables

booléennes correspondant au cas particulier {0,1}p.

4

1.2.1 Variables numériques

L’espace euclidien Rpest l’espace de représentation de l’analyse (géométrique) des données. Chaque objet

xi∈Xest ici codé par un p-uplet xi=x1

i, x2

i, . . . , xp

idans lequel xj

iest la valeur que prend la j-ième

variable (ou descripteur) sur l’objet xi. Le tableau ci-après montre un exemple d’objets (les lignes) décrites

par des données numériques (les colonnes).

En analyse des données, la démarche diffère de celle adoptée en statistique inférentielle où l’ensemble des

objets est souvent vu comme un échantillon d’une population plus vaste et l’on cherche à trouver des infor-

mations sur cette population à partir de l’échantillon considéré. Ici, Xest la population et les valeurs prises

par chaque variable constituent une distribution observée à partir de laquelle on peut calculer des paramètres

(la moyenne, la variance, . . . ), expliquer les valeurs prises par certaines variables à partir de valeurs prises

par d’autres (régressions), ou encore structurer les données (analyses factorielles).

1.2.2 Variables ordinales et nominales

Nous ne parlerons que très peu de ce genre de données par la suite, et nous nous restreindrons aux variables

booléennes, dont le tableau suivant donne un exemple.

?A : l’animal pond-t-il des oeufs ?

?B : présence de plumes ?

?C : présence d’écailles ?

?D : présence de dents ?

?E : l’animal vole-t-il ?

?F : l’animal nage-t-il ?

?G : l’animal respire-t-il dans l’air (1) ou dans l’eau (0) ?

Table 1.1 – tableau booléen

A B C D E F G

Autruche 1 1 0 0 0 0 1

Canari 1 1 0 0 1 0 1

Canard 1 1 0 0 1 1 1

Requin 1 0 0 1 0 1 0

Saumon 1 0 1 0 0 1 0

Grenouille 1 0 0 0 0 1 1

Crocodile 1 0 0 1 0 1 1

Barracuda 1 0 1 1 0 1 0

Ce genre de données peut être représenté en utilisant une terminologie booléenne. Soit Xl’ensemble des N

objets décrits par un ensemble A={A, B, C, . . .}de pattributs ou variables binaires. Chacun, par exemple

A, peut prendre les valeurs a(dite forme directe, codée 1) et ¯a(dite forme indirecte, codée 0). Ceci peut

être ramené à un tableau de valeurs 0 ou 1 avec Nlignes correspondant aux éléments de Xet pcolonnes

correspondant aux attributs.

Le tableau est alors équivalent à la formule Φci-après qui est vérifiée par les assignations induites par les

lignes :

Φ = ab¯c¯

d¯e¯

fg ∨ab¯c¯

de ¯

fg ∨ab¯c¯

defg ∨a¯

b¯cd¯ef ¯g∨

a¯

bc ¯

d¯ef ¯g∨a¯

b¯c¯

d¯efg ∨a¯

b¯cd¯efg ∨a¯

bcd¯ef ¯g

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

1

/

31

100%

![nuage d`orage.ppt [Lecture seule]](http://s1.studylibfr.com/store/data/002610621_1-109d877bfc52cbbc3690b1f9be98a7ee-300x300.png)