Introduction à l`optimisation des bases de données

Conception de bases de données

!"# $%

14 février 2017

4

!!4

&% 4

# '!% 5

( ) 6

* +) 7

, - 7

. /! 8

0 +) 8

1 ! 9

2 +) 10

$ 34 11

5! 11

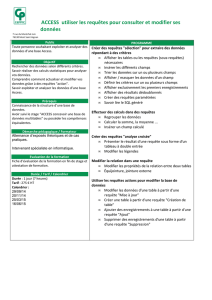

"# !!!!!$%!12

67 12

# 7 12

( 7 13

* 13

, 87 14

&!!!!!!$%!14

9"67:+;/9<= 14

# 7 17

!' (

)&*!+,17

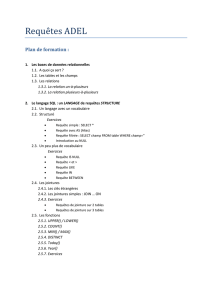

"-.!! !18

19

/!19

"!0!19

21

"."!1.221

"!!!3 .!4,22

24

28

!" 33

#! 34

$! 35

36

!' 5

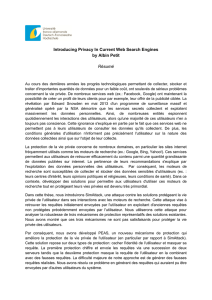

I - I

, !!6")!3.!$!!*! !

!!!7 8 ! 9! 8 ! *! .$! !! ! !

-!)! !*! !!7.:!..! 4,7 !!

%! !-!!!0;!!.$! !!!

&$!

$! 7!< !!!!!!

! $! ! ! $! 6")7 ! ! 8

!,!!!!!$!!%7

$!!!!!-!! !7$7$!!!!

9! ! ! 7 $! ! ! ! ! ! !! ! !

!.3-!.!

$! 6") ! . !! ! $! ! ! !

!7!! !!$ ! !!*!!

!&*!!=!!!!3! !!. 37$!

!9!!&*!7!!3!!!!37!.!!!

9! ! ! -! !! ! !

!3!!!!!!!

-! .!!$!$!!$!!!7$!!9!

! ! !! .$!7 -!*!! !

! !!!!!$!!!;!, !

!!!!!3!!

&'

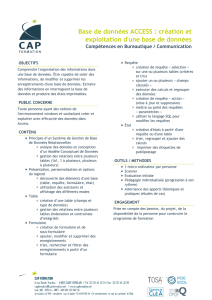

Objectifs

& ( %

) ! !(

%

) (

%#

*' %

,.! !!>&$!?7! ! .$!

6")!7 !! $! !3!;!!

!' @

,!- ! !!! ") !!!!!!!!

;A!!$!6")

! !3! ! ! ! !!

B!. 3%!-!!

!!3!7!+

,!3

,

,!!!9!!'

,!9!*!

,!!.!!>?!-!

> -

1. )!-*!!!;!!8 7

2. ! !7

3. ! 9 !9 8!!!! !-*!

+',%

'

! !!7!- !!!! !!!

.$!$!-!!. !!-*!!!;!

!!!3!!!*!9!!9+

!!!

-!!!

/ $!!!3 !!$%!

!3 !!$%!!3 !>-!!<!7!?

/ $!!!!<>9- ! !?

*!

)-< !!*

4 !!9!*!!! !

- !!3

!

'6

C!;! !!") 9!! 7;!!$!!

!-*!!!;!

, 9!!;!!!;!+

(

!D! >!!7!! !7!?!;

!*!>9!! !7 ! !7!?. !")!

-! ! *! ! * .7 ! ! ! D !3!

!!;E !3$! !

(

! !!!! !!!!!!

!.!7!;9!!*!!*! 9! !

$!! $!; ;!!!$!!8

!;!!!!F!!!30

!' G

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

1

/

37

100%