Op`misa`on dans les télécommunica`ons Alloca`on de

18/03/10

1

!"#$%&'#()*+')&*,-&*

./,/0($$1)%0'#()&*

!2*3(4%,%./*5*3'6&*7898*

:'#'*;'<6=&>?1)&-6*

9/03/10

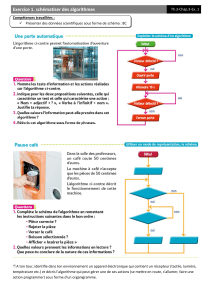

@1-,A1-&*"6(4,=$-&*+B("#$%&'#()**

• C1*)%D-'1*EFGH**

– C,,(0'#()*+-*I6/A1-)0-&*

– J6(1"'K-*+')&*,-&*6/&-'1L*MN3O*

• C1*)%D-'1*3CP**

– C,,(0'#()*+-&*0')'1L*-)*2N3C*

• C1*)%D-'1*?(1.'K-**

– ?-0Q-60Q-*+1*",1&*0(16.*0Q-$%)*

– ?(1.'K-*+B1)*R(.*+B%)I(6$'#()*&16*1)*6/&-'1*6'+%(*$'%,,/*

• C1*)%D-'1*C"",%0'#()*

– E,')%S0'#()*+-*6/&-'1L*$(4%,-&*

– N%$-)&%())-$-).*+B1)*6/&-'1*+-*+%&.6%41#()*+-*0().-)1*

9/03/10

C,,(0'#()*+-*I6/A1-)0-&*

• ?-&&(160-&*T"-0.6',-&*

,%$%./-&O*U-L*H*9VW*0')'1L*

-)*JT3X*9W*0')'1L*-)*

Y87O994Z*

• ?/1#,%&'#()*&"'#',-*+-&*

I6/A1-)0-&*"(16*

'1K$-).-6*,'*0'"'0%./*+1*

6/&-'1*

• P().6'%).-&*"(16*K'6')#6*

1)*P[\*&1]&').*-)*

$%)%$%&').*,-&*

%).-6I/6-)0-&O*

C,,(0'#()*+-*I6/A1-)0-&*U7Z*

• J'6')#6*1)*6'""(6.*&%K)',*^*461%.*&1]&').*H*

• \0*_*\).-6IO*0(>0')',X**

• \'*_*\).-6IO*0')',*'+`'0-).*

• T\a?*_*E?*[*Uab\Z*c*98*+d*-)*Y87O99*

9/03/10

18/03/10

2

C,,(0'#()*+-*I6/A1-)0-&*UeZ*

9/03/10

*C,,(0'#()*+-*I6/A1-)0-&*UfZ*

• *g'*0().6'%).-*&16*,-*T\a?*+(%.*h.6-*6-$",%-*&16*

.(1.-*,'*i()-*+-*&-6D%0-*+1*"(%).*+B'00=&O**

• a/0-&&%.-*+-&*0'6.-&*+-*0(1D-6.16-*j*P',01,&*

0(k.-1LO*C""6(L%$'#()&*"(&&%4,-&*

9/03/10

J6(1"'K-*+')&*,-&*6/&-'1L*MN3*

• ?/&-'1L*("#A1-&*H*

26')&"(6.*"(16*

0Q'A1-*λ*+B1)*.6'S0*

T23>9l*U7Of*J4%.[&Z*

• E6(4,=$-*+1*

K6(1"-$-).*+-&*λ*

A1%*&1%D-).*,-*$h$-*

0Q-$%)*+')&*,-&*

4')+-&*

J6(1"'K-*+')&*,-&*6/&-'1L*MN3*U7Z*

– e*.m"-&*+B/A1%"-$-).*+')&*,-&*)-(1+&*+-*

0($$1)%0'#()*H*

• no!pP*H*?/"/.-16X*

• Mo!pP*H*N/$1,#",-L-*'1*)%D-'1*+-&*,()K1-16&*+B()+-*

-.*0($$1.-*,-&*&%K)'1L*

• do!pP*H*N/$1,#",-L-*'1*)%D-'1*+-&*4')+-&*-.*0($$1.-*

,-&*4')+-&*

• P(k.*+-&*/A1%"-$-).&*^*+/",(m-6*

P(k.Uno!pPZ*q*P(k.Udo!pPZ*q*P(k.UMo!pPZ*

9/03/10

18/03/10

3

J6(1"'K-*+')&*,-&*6/&-'1L*MN3*UeZ*

• !4`-0#I*+1*"6(4,=$-*H**

• J6(1"-6*'1*$%-1L*,-&*,()K1-16&*+B()+-*+')&*

,-&*4')+-&*-.*,-&*4')+-&*+')&*,-&*S46-&*+-*

I'r()*^*$%)%$%&-6*,-*0(k.*.(.',*+1*+/",(%-$-).*

+-&*)s1+&*+-*0($$1)%0'#()*+1*6/&-'1O**

? ?

?

? ?

F-, B- ou W-OXC ?

F = Min(Sum_OXC Coût(OXC))

9/03/10

J6(1"'K-*+')&*,-&*6/&-'1L*MN3*UWZ*

C,,(0'#()*+-*0')'1L*2N3C*

U+')&*1)*6/&-'1*0-,,1,'%6-Z*

• !)*'*H**

– t)*-)&-$4,-*+-*:*1#,%&'.-16&*"'6*CEX**

– 26')&$%&&%()*2N3C**

E6(4,=$-*

– Cu6%41-6*^*0Q'A1-*1#,%&'.-16*1)-*I6'0#()*+1*.-$"&*

+-*"'6(,-*λ*+-*I'r()*^*$'L%$%&-6*,-*+/4%.*+-&*

1#,%&'.-16&O**

....

R time slots

K utilisateurs

AP

9/03/10

C,,(0'#()*+-*0')'1L*-)*2N3C*

Channel State Info :

SINR sur chaque slot

9/03/10

18/03/10

4

D

S

di

?-0Q-60Q-*+v1)*",1&*0(16.*0Q-$%)*

• E(16*1)*6(1.'K-*$1,#>&'1.&*H*

*N/.-6$%)-6*1)-*6(1.-*A1%*6-"6/&-).-*1)*",1&*

0(16.*0Q-$%)*-).6-*T*-.*N*"(16*1)-*$/.6%A1-*

0Q(%&%-O**

9/03/10

?-0Q-60Q-*+v1)*",1&*0(16.*0Q-$%)*

• !)*6-"6/&-).-*,-*6/&-'1*"'6*1)*K6'"Q-*

"()+/6/*

• !)*6-0Q-60Q-*&16*,-*K6'"Q-*"()+/6/*,-*0Q-$%)*

"w*A1%*$%)%$%&-*,'*&($$-*+-&*"(%+&**

D

di

S

9/03/10

?(1.'K-*+B1)*R(.*+-*+'.'**

&16*1)*6/&-'1*6'+%(*$'%,,/*

N')&*1)*6/&-'1*0s16*U4'0x4()-Z*&')&>S,&*UeJX*g2yZX*

$1,#>&'1.&*-.*Q'1.*+/4%.*

?/&-'1*"/6%(+%A1-X*1)*&-1,*0')',*6'+%(X*&m)0Q6()-O**

E/6%(+-*+-*.-$"&*+/0(1"/-*-)*%).-6D',,-&*.*_*z9XOO2{*

C*0Q'A1-*"/6%(+-X*0Q'A1-*

"(%).*+B'00=&*%)`-0.-*+-&**

+())/-&*U+-$')+-Z*^**

/0(1,-6*"'6*,-&**

"'&&-6-,,-&*

routeur

AP

IP

Demande

9/03/10

?(1.'K-*+B1)*R(.*+-*+'.'**

&16*1)*6/&-'1*6'+%(*$'%,,/*

• N/.-6$%)-6*,B(6+6-*+B'0#D'#()*+-&*,%-)&*A1%*

"-6$-u-*+-*$'L%$%&-6*,'*0'"'0%./*+1*6/&-'1*

• P'"'0%./*H*g'*A1')#./*+-*R(.*A1-*"-1.*6/"'6#6*

/A1%.'4,-$-).*1)-*.("(,(K%-*+())/-*^*0Q'A1-*

1#,%&'.-16*A1B-,,-*&-6.*H*

routeur

AP

t=1

1

1

1

1

2

2

2

3

3

3

4

4

4

Max capacité → Min Période T

9/03/10

18/03/10

5

9/03/10

E,')%S0'#()*+-*6/&-'1L*$(4%,-&O*

• !"#$"%#$"&'"&()&*+,-.+/&'",&01"2"3%,&*+3%&

+45"/-%&3/"&63)(-57&'"&8"%9-#"&'+//7"&

:#+39"%53%";&-/5"%<7%"/#",;&'74-5=>&?&&

E1

E2

E3

E4

Zone de

Couverture de E1

E,')%S0'#()*+-*6/&-'1L*$(4%,-&*

E,1&%-16&*"6(4,/$'#A1-&*H*

j*J'6')#6*1)-*0(1D-6.16-O*

j*J'6')#6*1)*6'""(6.*P[\*$%)%$',O*

j*E6("(&-6*1)-*&(,1#()*A1%*K'6')#.*1)*+/4%.*

+())/*+')&*0-6.'%)-&*"%=0-&O*

j*3%)%$%&-6*,-*)($46-*+v/$-u-16&*-)*.-)').*

0($".-*+-*,'*A1',%./*+-*,'*0(1D-6.16-O*

j*E6("(&-6*1)-*0()SK16'#()*+v/$-u-16&*

("#$',-*"(16*1)*&-6D%0-*+-*,(0',%&'#()O*

9/03/10

N%$-)&%())-$-).*+B1)*6/&-'1*+-**

+%&.6%41#()*+-*0().-)1*

9/03/10

N%$-)&%())-$-).*+B1)*6/&-'1*+-**

+%&.6%41#()*+-*0().-)1*

• E(16*I(16)%6*1)*$-%,,-16*&-6D%0-X*()*

+/",(%-*1)*-)&-$4,-*+-*&-6D-16&*B6-,'%&B*-.*

()*$1.1',%&-*,-16*1#,%&'#()O*

9/03/10

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

1

/

34

100%