Ainsi, dans une très large part des tâches auquel un animal est

Alexandre HYAFIL

DEA de Sciences Cognitives 2003-2004

Effort et dopamine

Directeur de stage : Emmanuel GUIGON

INSERM unité U483

Université Pierre et Marie Curie

9, quai Saint-Bernard

75005 PARIS

Introduction

Pourquoi paresse, fainéantise et oisiveté ? Pourquoi l’homme ne s’aventure-t-il pas

frénétiquement à la poursuite de ses innombrables objectifs ? On peut contester le recours

abusif à un tel argument, mais force est de constater que tout individu a tout intérêt à se

soucier de l’effort qu’il devra fournir avant de se lancer dans une quelconque entreprise.

Préserver ses réserves énergétiques est primordial à la survie de l’animal. Voici le point de

vue que nous défendrons.

La psychologie animale a généralement ignoré cette influence du coût de l’action et

formalisé le problème de la construction des comportements comme celui d’une recherche de

récompenses: dans ce cadre, un comportement cherche à maximiser les gains à long terme,

sans prendre en compte les coûts associés à l’obtention de ces gains. Des modèles

d’apprentissage permettant de rendre compte de cette prétendue optimalité du comportement

animal ont été élaborés, et implémentés dans des machines artificielles. Ce n’est que plus

récemment avec les progrès considérables de la neurobiologie que l’on a pu effectuer le

rapprochement entre certaines activités neuronales et les processus clés du comportement tels

que ces modèles les avaient formalisés : apprentissage opérant, régulations des besoins par

des facteurs internes (signaux de faim, de soif …) et externes (disponibilité des stimuli

recherchés dans l’environnement), règles de priorité entre différents objectifs incompatibles…

Ce champ d’étude pluridisciplinaire s’est ainsi enrichi des apports de la psychologie animale,

de la neurophysiologie et de l’approche modélisatrice liée à l’Intelligence Artificielle, et laisse

entrevoir la possibilité de proposer un modèle d’anatomie fonctionnelle à même d’expliquer

les bases neurales du comportement animal et l’optimalité d’un tel comportement.

Le concept clé dans cette littérature est celui de renforcement. L’individu est capable

de renforcer des comportements ayant conduit à une récompense : c’est-à-dire que placé dans

les mêmes conditions environnementales, il sera capable de rappeler sélectivement le

comportement récompensé et de le conduire jusqu’à l’obtention de la récompense recherchée.

La difficulté principale dans la construction de ce comportement réside dans le décalage

temporel entre action et récompense : l’animal doit pouvoir motiver son comportement

pendant toute l’exécution de cette action de par le simple espoir de gagner in fine la

récompense. L’apprentissage doit donc porter rétroactivement sur l’ensemble des actions

ayant amené à l’obtention de la récompense. Le modèle de Sutton et Barto1 prévoit à cet effet

1

qu’un signal de récompense puisse être diffusé largement dans le système exécutif et ainsi

renforcer les actions précédemment exécutées.

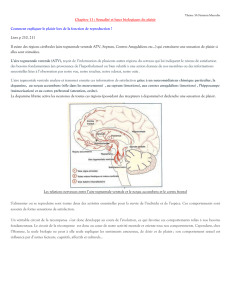

La dopamine (DA) paraît jouer ce rôle de signal de récompense, comme le montrent

de très nombreuses expériences. Outre son implication dans la plupart des addictions, ce

neuromodulateur répond en phase à la présentation de stimuli positifs comme de la nourriture,

de la boisson ou un partenaire sexuel. L’activation de la dopamine induit indéniablement une

modification des efficacités synaptiques, corrélat biologique indispensable à toute forme

d’apprentissage. Et si le rat peut en pressant un levier exciter directement ses fibres

dopaminergiques (self-stimulation), alors il le fera, et même plutôt que de jouir de toute autre

récompense naturelle présentée en concurrence. Par ailleurs, des antagonistes de la dopamine

bloquent le comportement dirigé vers ces stimuli naturels ou artificiels, comme si la

nourriture, le sexe et les drogues ne présentaient plus pour l’animal de valeur hédonique.

Enfin, la théorie du renforcement prévoit qu’un signal de renforcement est émis dès lors que

l’animal est sûr de recevoir une récompense, et non pas seulement au moment de la

récompense. Cette propriété a été retrouvée lors d’enregistrements de neurones

dopaminergiques chez le singe : lorsque les récompenses peuvent être prédites par un signal

déterminé, alors la dopamine répond cette fois à la présentation de ce stimulus prédicteur et

non plus à la récompense subséquente. C’est cette dernière observation qui a précipité le lien

entre les expériences en neuroscience et le modèle théorique de renforcement.

La théorie du renforcement par la dopamine a rencontré un succès à la hauteur de sa

puissance : la dopamine réalise selon ses dires tout l’apprentissage opérant « à elle toute

seule ». Il s’agirait désormais de l’enrichir de cette notion essentielle qu’est le coût de

l’action. Tout animal est amené en effet à effectuer à chaque instant un compromis entre ces

objectifs antagoniques que sont la recherche de récompenses et la préservation de ses réserves

énergétiques. Or la prise en compte de ce dernier paramètre a remis en cause des résultats

fondamentaux de la théorie de la dopamine. Il apparaît notamment qu’à faible dose, des

antagonistes de la DA peuvent altérer le comportement dirigé vers des récompenses sans

affecter la réponse hédonique à ces stimuli, comme si la DA ne jouait pas sur le plaisir associé

à un stimulus mais sur l’aptitude à se motiver pour y parvenir. Par exemple des rats ainsi

traités préfèreront toujours une grosse récompense à une plus petite, mais choisiront la plus

petite si pour y accéder la marche à franchir est moins élevée. Au-delà de la simple fonction

de la dopamine, c’est la viabilité toute entière des modèles de comportement qui pâtit de cette

remise en cause.

2

Il est donc crucial de se poser la question du rôle du coût de l’action dans le

comportement animal. Certaines recherches en psychologie animale ont déjà montré que ce

critère était prépondérant dans l’élaboration d’un comportement optimal ; d’autres travaux en

neurophysiologie mettent en avant la pertinence biologique d’une telle variable. Il manque

cependant une vue d’ensemble capable d’intégrer ces différentes études pour proposer un

modèle. Un modèle de comment le système nerveux appréhende le coût de l’action.

Nous proposons donc de faire un tour de ces différents travaux et des concepts qu’ils

dégagent, en suggérant quelques pistes de recherche en vue de l’élaboration d’un tel modèle.

Plus spécifiquement, nous nous intéresserons aux questions suivantes : qu’elle est l’origine de

la représentation neurale du coût de l’action ? Comment cette variable est-elle intégrée dans le

comportement, et quel rôle pour la dopamine dans l’élaboration d’un compromis entre coût et

récompense ? Nous tenterons enfin d’intégrer simplement ce rôle dans de nouveaux modèles

d’anatomie fonctionnelle.

3

Table des matières

Introduction.............................................................................................................................1

Table des matières.................................................................................................................. 4

I. Représentation du coût de l’action ..................................................................................... 5

1. De la nécessité d’une telle représentation ...................................................................... 5

2. De l’origine d’une telle représentation :......................................................................... 6

i. les afférences sensorielles : ........................................................................................ 6

ii. les grandeurs internes :............................................................................................... 8

3. Du lien avec la perception de l’effort :......................................................................... 10

4. Du lien avec le problème de Bernstein : ...................................................................... 12

5. De la mémoire de l’effort :........................................................................................... 14

II. Dopamine et régulation de l’effort ................................................................................... 17

1. Théories de la dopamine .............................................................................................. 17

2. De l’implication pour les troubles moteurs .................................................................. 23

III. Intégration aux modèles actuels ................................................................................... 32

1. Des différentes fonctions de la dopamine .................................................................... 32

L’apprentissage. ....................................................................................................... 33

La motivation .......................................................................................................... 34

Le gating................................................................................................................... 35

2. De la sélection de l’action la plus judicieuse ............................................................... 39

Conclusion............................................................................................................................ 46

Bibliographie........................................................................................................................ 47

4

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

1

/

51

100%