Du suivi trans-téléphonique au cloud computing: quelles sont les

Du suivi trans-téléphonique au cloud

computing: quelles sont les technologies de la

télécardiologie?

Université Libre de Bruxelles

Laura Zombek

5 Janvier 2015

Introduction

Les maladies cardio-vasculaires représentent aujourd’hui les causes mor-

telles les plus répandues dans les pays à hauts ou moyens revenus[7, p. 16452].

Le vieillissement de la population et le développement continu de la thérapie

moderne amènent à une prévalence croissante de ce type de maladies chro-

niques. Le besoin de créer un contact proche et permanent entre le patient

et les services de santé se fait de plus en plus urgent si l’on veut procurer un

traitement optimal au malade[22, p. 214]. Ce défi peut, en partie, être relevé

par la télémédecine et plus précisément la télécardiologie.

La télémédecine fait partie intégrante de la télésanté. Elle « recouvre toutes

les techniques et applications permettant d’intervenir à distance pour établir des

diagnostics, mettre en œuvre des thérapeutiques, surveiller des traitements, as-

surer et suivre des soins coordonnés. »[23, p. 438]. Elle comprend trois grandes

composantes : les données produites par le patient, la transmission électronique

des données du patient au professionnel de la santé et le feedback personnalisé

adapté au patient. De plus, elle peut être synchrone (basée sur le temps-réel)

et/ou asynchrone (basée sur le principe du stockage et de la retransmission) ou

les deux[22, p. 215]. La télémédecine comporte en tout quatre champs que sont

la télésurveillance, la téléconsultation, la télé-expertise et la téléassistance, aux-

quels on pourrait ajouter le télédiagnostic et le télésuivi. La télésurveillance,

qui est la sorte de télémédecine la plus répandue, consiste en la transmission

et l’interprétation à distance d’un indicateur par un médecin qui peut aboutir

à une décision d’intervention. Certaines données prédéfinies peuvent générer

automatiquement un message d’alerte.[23, pp. 445-446]

1

La télécardiologie est donc une sous-catégorie de la télémédecine, spécialisée

dans les maladies cardiaques chroniques. En général, elle se réalise, soit via une

prothèse cardiaque, soit via un électrocardiogramme (ECG) ou une échocardio-

graphie (ECHO). Lorsque des dysfonctionnements électriques ou des troubles

rythmiques surviennent, le patient va nécessiter l’implantation d’un défibrilla-

teur ou d’un stimulateur cardiaque[13, pp. 17-25]. Un ECG, par contre, est la

méthode la moins invasive pour diagnostiquer les maladies du cœur[20, p. 149].

Un signal ECG est un signal électrique généré par le battement du cœur qui

peut être utilisé comme un important outil de diagnostic pour examiner le

fonctionnement de cet organe[7, p. 16453]. Traditionnellement, un instrument

ECG stocke les données sur la forme de l’onde mesurée sous un format propre

au constructeur. Les données ECG sont alors compressées et encryptées à l’aide

d’algorithmes également spécifiques à l’industriel et une copie papier du rap-

port est ensuite générée[10, p. 1].

De nombreuses applications pratiques découlent de la télécardiologie : la

surveillance du bon fonctionnement de la prothèse (l’état de la pile, les varia-

tions des impédances des sondes, les seuils de stimulation ventriculaire, etc.) et

la surveillance de l’activité cardiaque (la présence de commutations de mode

ou la présence de tachycardies ventriculaires)[1, pp. 316-317]. Il devient ainsi

possible d’éliminer le contrôle à dates fixes et de personnaliser le jour de la

consultation par rapport à un événement détecté. Cela permettra donc de ne

pas devoir se rendre de manière très régulière chez son médecin et, ainsi, des

économies d’échelles par cette prise en charge extra-hospitalière peuvent être

réalisées[19, p. 93]. En outre, c’est un gain de temps pour le patient, notam-

ment celui qui habite en zone rurale, pour le médecin car le diagnostic se fait

plus tôt, c’est un gain d’espace dans le centre hospitalier ainsi qu’une tâche

en moins pour un personnel médical déjà très surchargé[20, p. 147]. Enfin, le

patient obtient également une meilleure compréhension de sa maladie, ce qui

est essentiel pour la bonne conduite de son traitement[22, p. 215].

Comme nous allons le voir, la télécardiologie est utilisée en pré-hospitalisa-

tion (par exemple, dans les ambulances), pendant l’hospitalisation ainsi qu’en

post-hospitalisation.

1 Etat de l’art

La communication entre le médecin, le personnel médical et le patient peut

se réaliser à l’aide de multiples technologies, assurant ainsi les requêtes va-

riées imposées par les différentes possibilités de scénarios. Au fil des années,

l’évolution des technologies et des algorithmes d’analyse pourrait permettre

d’optimiser l’utilisation de la télécardiologie.[22, p. 213]

Il est possible de catégoriser les systèmes de télémédecine, et donc de télé-

cardiologie, en quatre générations[2, p. 733]. La première génération comprend

2

un système de collecte et d’analyse de données non réactives, avec une trans-

mission des données asynchrone. La deuxième génération est un système qui

ne permettrait pas une analyse ou une décision immédiate, mais dont la trans-

mission des données est synchrone, ce qui permet de récolter les données et de

voir les changements importants. Par contre, des retards peuvent être occasion-

nés si le système est uniquement actif le jour. La troisième génération est un

système de gestion du patient à distance avec décision et analyse constantes,

même s’il fonctionne en dehors des heures de travail. Enfin, la quatrième et

dernière génération est un système de gestion à distance dont les données

viennent d’appareils télémédicaux invasifs ou non invasifs, ceux-ci étant liés à

une plateforme télémédicale et accessibles par le prestataire de soins primaires

ainsi que par le centre télémédical. Certaines données peuvent être enregistrées

automatiquement, d’autres sont parfois encodées manuellement par le patient.

1.1 Les débuts de la télécardiologie

L’ancêtre de la télécardiologie s’appelle le « suivi trans-téléphonique ». Via

une ligne téléphonique classique, il était possible de recueillir à distance un lam-

beau d’ECG monopiste ainsi que des caractéristiques basiques de la fonction

de stimulation. Le patient se rendait dans un centre distant qui transmettait

les données à un centre de stimulation cardiaque, ce dernier prodiguant donc

une télé-expertise[15, p. 183]. Une autre technique qui passe également par la

ligne de téléphone « normale », mais qui permet au patient de rester chez lui

est l’enregistrement manuel du battement du cœur en tant que fichier audio.

Le patient pose contre son cœur une « carte », qui enregistre les pulsations.

Ensuite, le patient place la carte contre le combiné du téléphone, à l’autre bout

duquel se trouve le cardiologue.[11, p. 6133]

Le suivi trans-téléphonique a évidemment été laissé tombé avec l’évolu-

tion technologique. Les prothèses implantées sont de plus en plus complexes

et les diagnostiques peuvent dorénavant se faire de manière embarquée. Cela a

conduit à la possibilité d’une transmission des données stockées par la prothèse

via la ligne téléphonique, et non plus par le combiné. Cette transmission est

manuelle et réalisée par le patient à son domicile. Cependant, on reste dans un

suivi calendaire et non automatique.[15, p. 183] Cette transmission manuelle

des données apporte clairement certaines limites puisqu’il règne une réelle dé-

pendance au patient.

1.2 L’arrivée d’Internet

A partir des années 2000, on va arriver à une télécardiologie automatique

et sans fil. La prothèse ou l’instrument d’ECG est muni d’une micro-antenne,

ce qui permet une transmission automatique de courte distance par radiofré-

3

quence entre le dispositif et un boîtier de transmission proche du patient, dans

son domicile.[23, p. 447] Cela mène donc à la diminution du besoin d’interven-

tion du patient et à l’augmentation de la fréquence de transmissions. Ensuite,

via un réseau téléphonique filaire, les données sont acheminées vers le centre de

services géré par l’industriel du boîtier. Ce serveur est sécurisé et reçoit donc

des messages sous forme cryptée. Le rapport généré sera enfin accessible au

médecin et au personnel médical sur un site web via une connexion Internet

sécurisée. Un message d’alerte peut être engendré et envoyé au cardiologue par

e-mail, fax ou encore message téléphonique selon certaines données prédéfi-

nies.[17, pp. 7-8] Ces notifications peuvent être différenciées selon leur gravité

potentielle, par exemple par couleur (jaune, orange, rouge), et peuvent égale-

ment être personnalisées[15, p. 185]. La transmission automatique des données

est le plus souvent réglée pour se réaliser pendant la nuit, le boîtier étant posé

sur la table de chevet du patient[1, p. 136].

En 2002, le développement des ECG informatisés a été véritablement promu

par l’Open-ECG, une organisation académique internationale, en procurant

des formats de données ECG standards : SCP-ECG (Standard Communication

Protocol-ECD) approuvé par ISO (International Organization for Standardi-

zation), XML-ECG (Extensible Markup Language based ECG) proposé par la

FDA (Food and Drug Administration) et DICOM-ECG (Digital Imaging and

Communications in Medicine based ECG) recommandée par la NEMA (Natio-

nal Electrical Manufactures Association). Ce dernier format permet d’intégrer

les images médicales dans les PACS (Picture Archiving and Communication

Systems). Avec l’aide d’Open-ECG, les hôpitaux peuvent développer des «e-

diagnostics» plutôt que des rapports papier. Cependant, ces normes n’ont pas

été adoptées par tous les fabricants d’ECG, ceux-ci développant leurs propres

formats. Ce comportement a, par conséquent, abouti à une hétérogénéité des

formats de données, ce qui amène de grandes difficultés d’incompatibilité aux

cliniciens et techniciens lorsqu’un hôpital décide d’acheter des produits ECG

provenant de différents constructeurs.[10, pp. 1-3]

Malgré cette évolution dans le domaine de la télécardiologie, il est toujours

nécessaire de consulter son médecin afin de modifier la programmation de la

prothèse ou d’effectuer des vérifications complémentaires[15, p. 184]. En outre,

le fait que la télésurveillance cardiologique passe par des réseaux fixes limite

considérablement la liberté du patient, étant donné qu’il doit au minimum être

à côté du boîtier de transmission lorsque les données sont téléchargées. Il règne

donc toujours le problème de la flexibilité.[12, p. 6]

Cette difficilté reste la même pour les instruments ECG. En effet, ceux-ci

ne restent opérationnels qu’à l’intérieur de l’hôpital. Les rapports ne peuvent

être générés en dehors. Le centre hospitalier doit donc acheter une station de

télémédecine ECG supplémentaire pour, par exemple, recevoir les ECG trans-

4

mis à partir des ambulances. Toutefois, un cardiologue expérimenté n’est pas

toujours présent devant le poste et si l’équipe médicale ressent le besoin de

prendre avis auprès d’un cardiologue hors de l’hôpital, celui-ci ne pourra pas

avoir accès aux enregistrements, aux résultats des examens en laboratoire ou

encore aux dossiers de médication.[10, pp. 2-3]

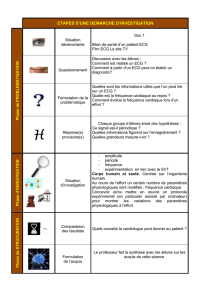

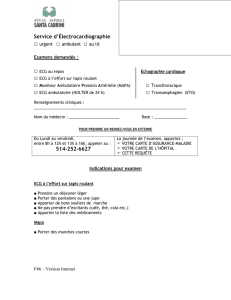

Carlos Costa et José Luis Oliveira proposent, eux, d’utiliser une boîte mail

ordinaire, au lieu de complexes middlewares, pour soutenir le système principal

d’information de télécardiologie et les données associées (Figure 1). Dans la

pratique, le technicien responsable de l’acquisition des données ECG ou ECHO

télécharge les examens vers le centre d’e-mail. Les fichiers sont introduits dans

un conteneur compressé chiffré avec une clé de session. Le conteneur est joint à

un e-mail et envoyé vers l’adresse e-mail centrale via le protocole SMTP. L’uti-

lisateur du logiciel d’examen, qui est une application standalone, sera soumis

à authentification. Cela fait, le logiciel vérifie la boîte de réception de l’utili-

sateur. S’il y a des nouveaux messages, ceux-ci seront déplacés vers le dossier

«en attente». Ce faisant, les fichiers joints sont téléchargés et décryptés. Les

données sont ensuite analysées. Un rapport au format PDF avec la signature

digitale du médecin sera généré pour ensuite être encrypté et déposé dans la

boîte d’envoi centrale. En résumé, toutes les informations opérationnelles du

système, dont les demandes, les images, les rapports et les réponses sont dans

cette boîte mail.[6, pp. 612-615]

Choisir un serveur mail pour la télémédecine revêt de nombreux avantages,

notamment la réduction des exigences opérationnelles et donc des coûts ainsi

que l’intégration naturelle des communications par messages électroniques[5,

p. 107]. De plus, pour explorer la collaboration inter-institutionnelle, il est

nécessaire d’adapter les communications des applications aux exigences du ré-

seau concernant les « pare-feux ». En effet, ceux-ci inhibent généralement les

connexions directes venant de l’extérieur du centre de soins de santé, en raison

des politiques de gestion du réseau. En conséquence, l’approche proposée par

Costa et Oliveira est supportée par le protocole IMAP, protocole qui cohabite

plutôt bien avec les pare-feux. Enfin, il n’est pas nécessaire de créer de nou-

veaux protocoles et répertoires de données, et des ressources IT ne sont pas

requises pour installer le centre de télémédecine.[6, p. 614]

1.3 Les réseaux mobiles

Dans les années 2009 et 2010, une série d’études ont été menées afin d’amé-

liorer la télémédecine, et donc la télécardiologie, par l’utilisation du mobile

computing[10, p. 2]. Ce perfectionnement va de paire avec la rapide progression

des technologies concernant les appareils médicaux, et plus particulièrement

les instruments d’ECG. En effet, ceux-ci acquièrent de nouvelles caractéris-

tiques : les périodes d’enregistrement des données sont plus longues, le patient

ne doit plus porter de fils ou d’électrodes, la petit taille de l’appareil le rend

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

1

/

17

100%