Expériences sur les données du répertoire de données de UCI

Expériences sur les données du

répertoire de données de UCI

avec TANAGRA

Réalisé par : MOHAMED BEN SAAD

Soutenu par : M. Antoine Cornuéjols

M. Yves Lechevallier

M. Edwin Diday

Expériences sur les données du répertoire de données de UCI avec TANAGRA

2

PLAN

1. Introduction

2. Cadre théorique

a. Méthode d’apprentissage.

i. Arbre de Décision

ii. Séparateurs à vaste marge

iii. Réseaux de Neurones

iv. Boosting

b. Méthode de validation.

i. Estimation par validation croisée

ii. Utilisation d’un échantillon de test

3. Jeux de données et Outils

4. Expérimentation et Analyse

a. La base de données Haberman's Survival

b. La base de données Vehicule

c. La base de données letter-recognition

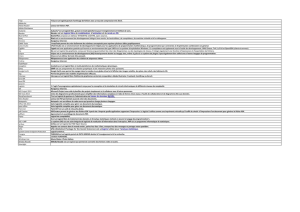

5. Tableau récapitulatif

6. Conclusion

Expériences sur les données du répertoire de données de UCI avec TANAGRA

3

1. Introduction

La classification est une procédure permettant d’affecter un objet à

la famille à laquelle il appartient. Le but de ce travail est de tester la

performance des méthodes d’apprentissage supervisé (taux d’erreur,

matrice de confusion) telles que les réseaux de neurones, les arbres de

décision et les séparateurs à vaste marge ainsi que l’effet du Boosting

sur ses algorithmes. J’ai ici choisi de tester des données du répertoire

UCI à travers l’outil Tanagra. Les jeux de données sélectionnés sont

différents en nombre et type d’attributs descriptifs, taille et classe à

prédire.

2. Cadre théorique

a. Méthode d’apprentissage

i. Arbre de Décision

« Un outil d'aide à la décision et à l'exploration de

données. Il permet de modéliser simplement,

graphiquement et rapidement un phénomène mesuré

plus ou moins complexe. Sa lisibilité, sa rapidité

d'exécution et le peu d'hypothèses nécessaires a priori

expliquent sa popularité actuelle. »

ii. Séparateurs à vaste marge (SVM) : « Technique

d’apprentissage avec professeur destinées à résoudre

des problèmes de discrimination et de régression »

Expériences sur les données du répertoire de données de UCI avec TANAGRA

4

iii. Réseaux de Neurones (RN) : Une méthode d’apprentissage

supervisé, souvent utilisé pour des problèmes de

classification et de généralisation (reconnaissance de

formes, des codes postaux, approximation d’une

fonction inconnue).

iv. Boosting : « domaine de l’apprentissage automatique. Il

permet d’optimiser les performances des méthodes

d’apprentissage ».

b. Méthodes d’évaluation :

i. Estimation par validation croisée : (K-fold cross-validation)

C’est une méthode qui permet de prédire la

performance de la classification. Son mécanisme est

donné par les étapes suivantes :

Partitionner l’ensemble d’apprentissage en k

partitions égales

Appliquer l’apprentissage sur les k-1 partitions et

utiliser la kème partition pour tester.

Répéter ce processus k fois selon la permutation

circulaire

Ainsi, l’erreur obtenue sera égale à la somme des

erreurs trouvées dans les partitions

ii. Utilisation d’un échantillon de test : c’est la méthode la plus

simple. Elle consiste à subdiviser l’ensemble des

Expériences sur les données du répertoire de données de UCI avec TANAGRA

5

exemples en deux ensembles indépendants : T (Test

Set) et A (Training Set). Le nombre d’erreurs.

3. Jeux de données et Outils

J’ai choisi d’utiliser le logiciel Tanagra (Ver 1.4.42) pour son

aspect ergonomique afin de tester les algorithmes. Il faut aussi noter la

préparation des données récupérées par la création d’un fichier .arff et

la structuration par :

Les commandes (@relation,@attribute,@Data..).D’où les jeux de

données utilisées, sont décrits comme suit :

La première Haberman's Survival qui concerne une étude sur la

survie des patients ayant subi une chirurgie du cancer du sein entre

1958 et 1970 aux USA. Elle est composée de 4 attributs et 306

exemples.

La deuxième letter-recognition décrite par 17 attributs et 20000

exemples dont l’objectif est d’identifier les 26 lettres majuscules de

l’alphabet.

La troisième Vehicule lié à une étude des voitures. Elle est

composée de 19 attributs et 846 exemples.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

1

/

18

100%